mistral-flo-finetune-2-T4

This model is a fine-tuned version of mistralai/Mistral-7B-v0.1 on an unknown dataset.

Model description

More information needed

Intended uses & limitations

More information needed

Training and evaluation data

More information needed

Training procedure

Training hyperparameters

The following hyperparameters were used during training:

- learning_rate: 2.5e-05

- train_batch_size: 4

- eval_batch_size: 16

- seed: 42

- optimizer: Adam with betas=(0.9,0.999) and epsilon=1e-08

- lr_scheduler_type: linear

- lr_scheduler_warmup_steps: 1

- training_steps: 500

Framework versions

- PEFT 0.8.2

- Transformers 4.37.0

- Pytorch 2.1.2

- Datasets 2.1.0

- Tokenizers 0.15.1

Mistral_fine_tuning

Florian Dufaure - Volodia Fernandez

Introduction

Nous sommes parties de Mistral afin de créer un générateur de phrase en le fine tunant avec du light novel

Notre modèle est sur Hugging Face à l'adresse suivante : Mistral-fine-tuning-light-novel

Version en local

Nous avons eu quelques soucis avec le fonctionnement depuis Hugging Face, donc il est possible de tester notre modèle en local depuis le fichier Light_Novel_Generation.ipynb.

Pour cela il suffit d'aller à la fin du fichier dans la partie Test en local de notre fichier. Et de modifier l'eval_prompt afin que notre modèle le complète.

Running

Pour lancer notre service il suffit de faire

python app.py

Et de se rendre sur l'url indiqué dans le terminal et de générer ce qu'on veut.

Entrainement du modèle

Nous avons entrainé le modèle sur une petite partie du dataset par manque de temps et sur une époque.

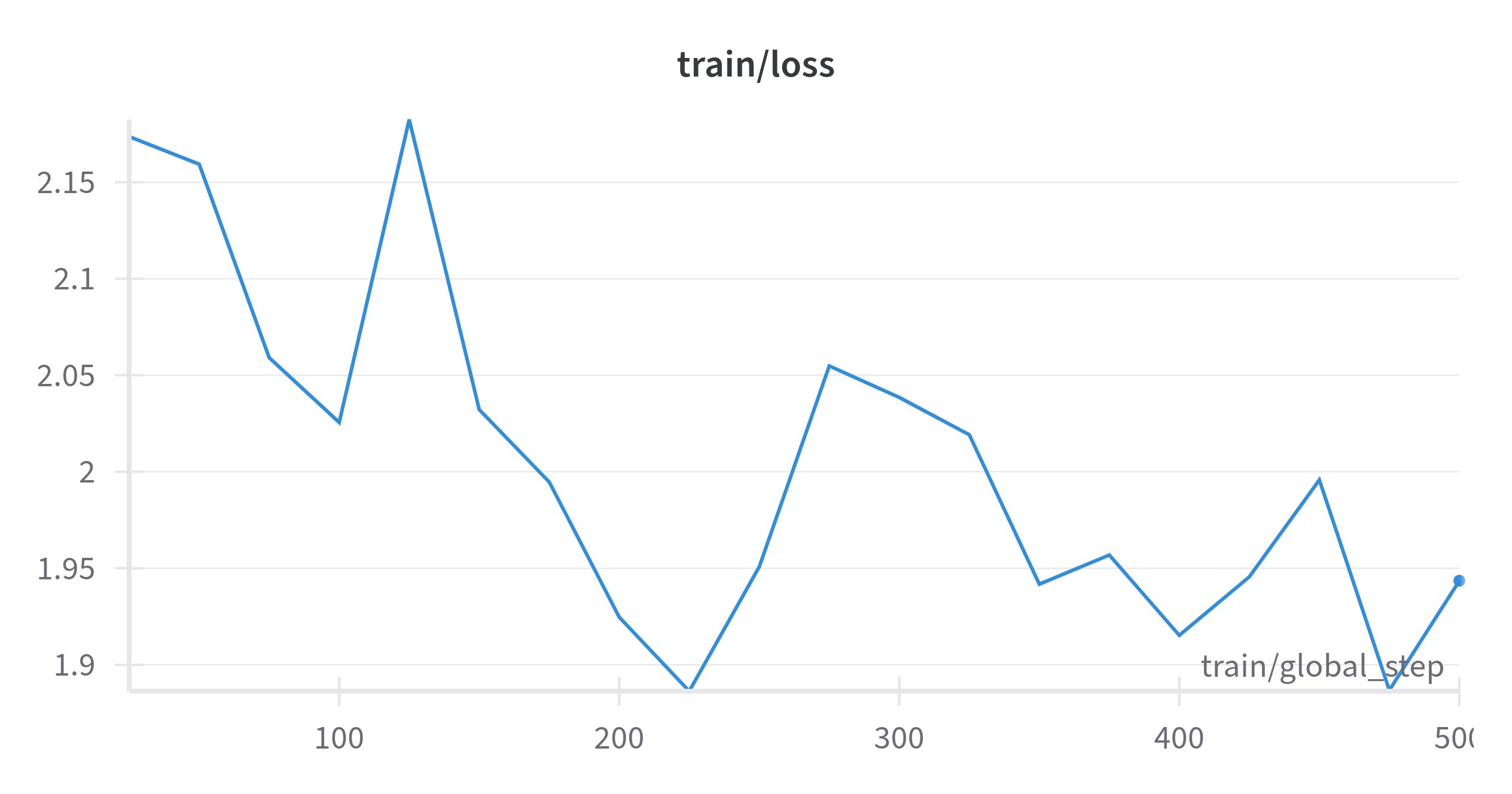

Voici la courbe de loss durant le training du modèle

- Downloads last month

- 7

Model tree for FloVolo/mistral-flo-finetune-2-T4

Base model

mistralai/Mistral-7B-v0.1