GoGPT

基于多样性中文指令数据微调的中文BLOOM底座模型

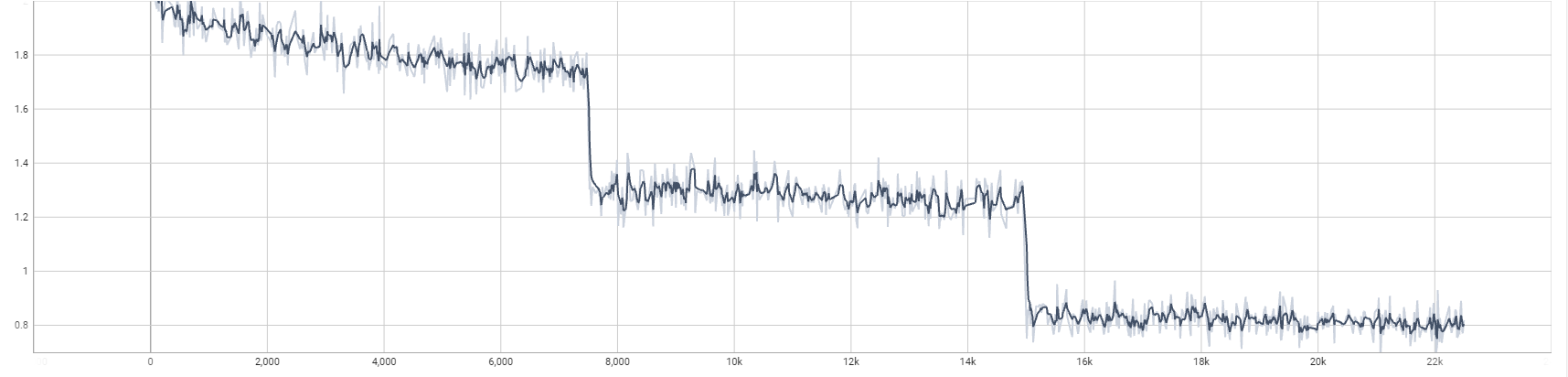

训练第一轮足够了,后续第二轮和第三轮提升不大

- 🚀多样性指令数据

- 🚀筛选高质量中文数据

| 模型名字 | 参数量 | 模型地址 |

|---|---|---|

| gogpt-560m | 5.6亿参数 | 🤗golaxy/gogpt-560m |

| gogpt-3b | 30亿参数 | 🤗golaxy/gogpt-3b-bloom |

| gogpt-7b | 70亿参数 | 🤗golaxy/gogpt-7b-bloom |

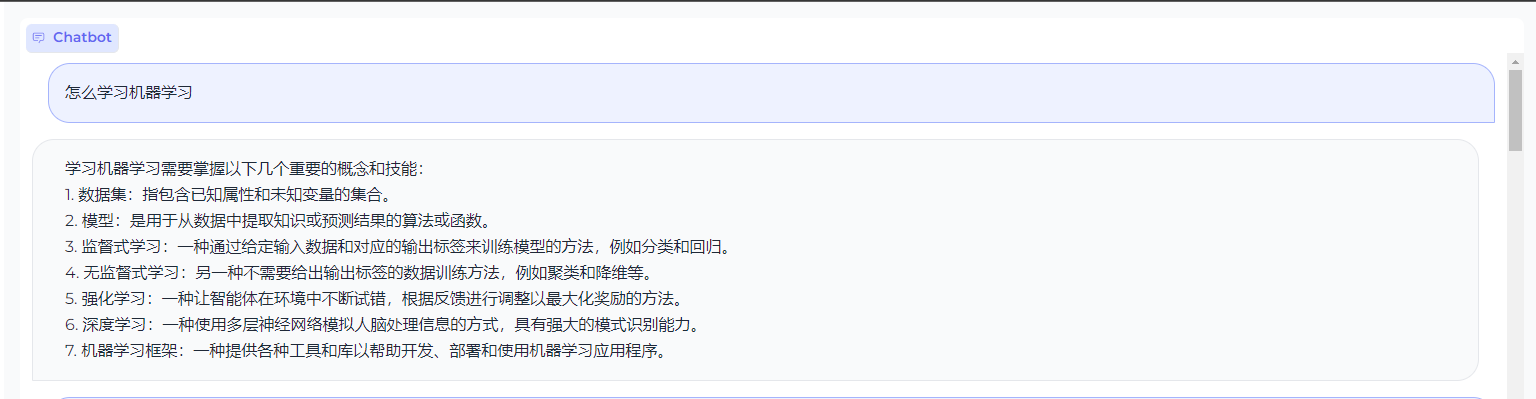

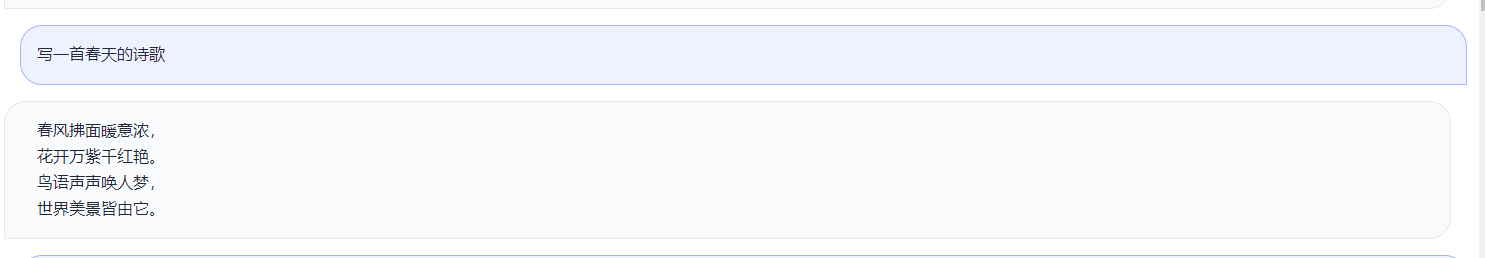

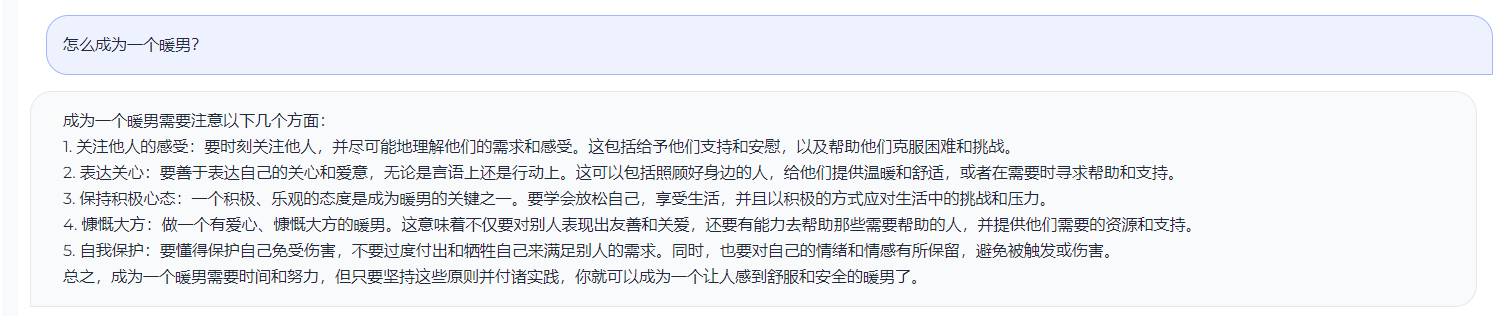

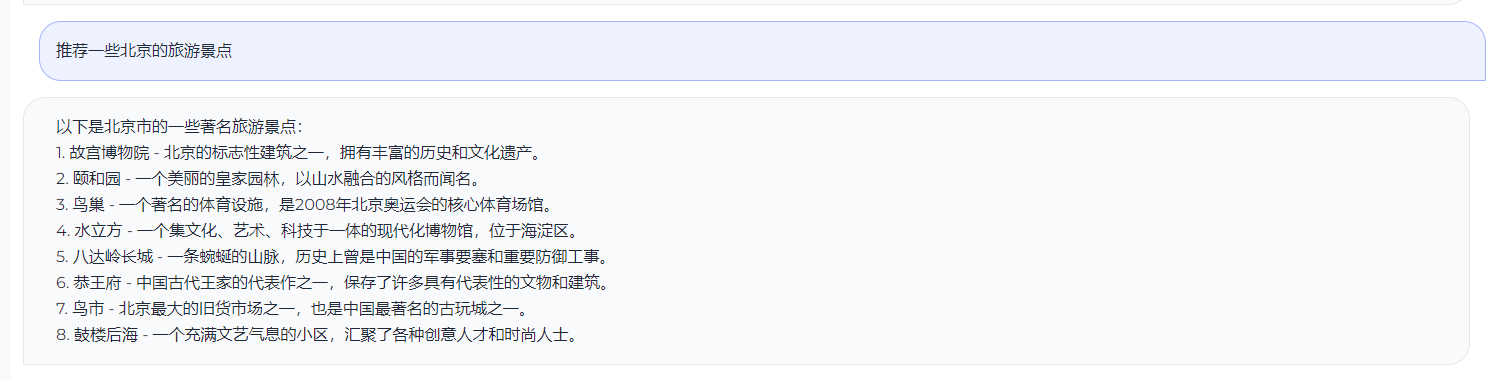

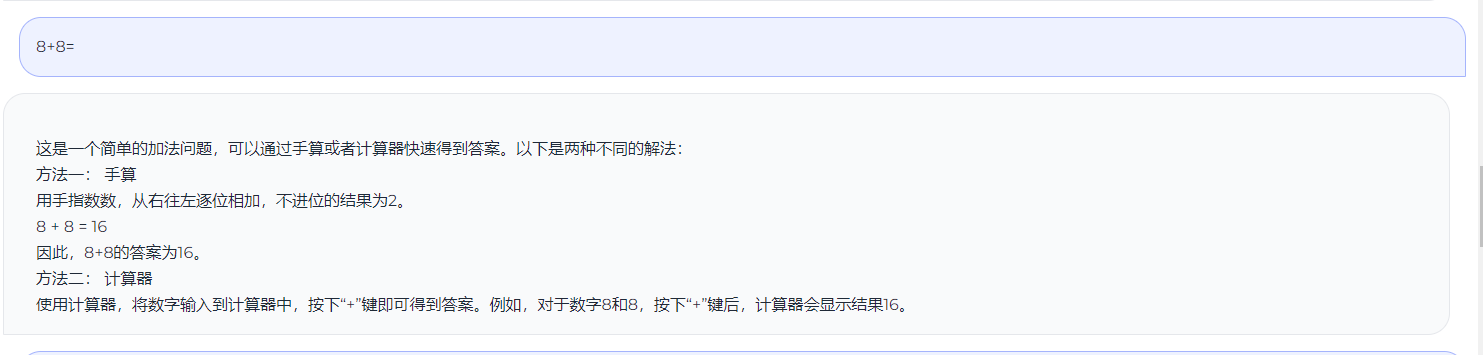

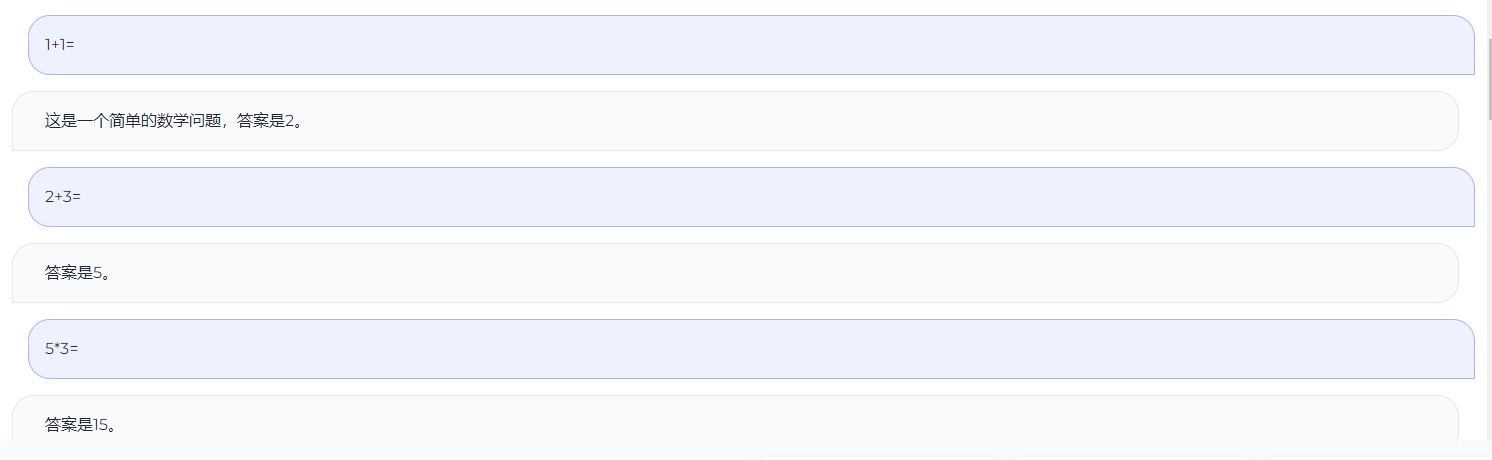

测试效果

TODO

- 进行RLFH训练

- 后续加入中英平行语料

感谢

Citation

如果你在研究中使用了GoGPT,请按如下格式引用:

@misc{GoGPT,

title={GoGPT: Training Medical GPT Model},

author={Qiang Yan},

year={2023},

howpublished={\url{https://github.com/yanqiangmiffy/GoGPT}},

}

- Downloads last month

- 1,258

Inference Providers

NEW

This model isn't deployed by any Inference Provider.

🙋

Ask for provider support