A newer version of the Gradio SDK is available:

5.9.1

Qwen-7B 🤖 | 🤗 | Qwen-7B-Chat 🤖 | 🤗 | Qwen-7B-Chat-Int4 🤗

WeChat | Discord | Demo | Report

日本語ドキュメントメンテナー: Ikko Eltociear Ashimine & Junyang Lin

私たちは、Qwen-7B と Qwen-7B-Chat を 🤖 ModelScope と 🤗 Hugging Face の両方でオープンソース化しています(上部のロゴをクリックすると、コードとチェックポイントのあるリポジトリに移動します)。このレポには、Qwen-7B の簡単な紹介と、使い方の手引き、さらに詳しい情報を提供する技術メモ link が含まれています。

Qwen-7B は、アリババクラウドが提唱する大規模言語モデルシリーズ Qwen(略称:Tongyi Qianwen)の7Bパラメータ版になります。Qwen-7B は Transformer ベースの大規模言語モデルであり、ウェブテキスト、書籍、コードなどを含む大量のデータで事前学習されています。さらに、事前学習された Qwen-7B をベースに、アライメント技術で学習された大規模モデルベースの AI アシスタントである Qwen-7B-Chat をリリースします。Qwen-7B シリーズの特徴は以下の通りです:

- 高品質な事前トレーニングデータでトレーニング。Qwen-7B は 2.2 兆以上のトークンを含む大規模で高品質なデータセットに対して事前学習を行っっています。このデータセットには平文とコードが含まれ、一般的なドメインデータと専門的なドメインデータを含む幅広いドメインをカバーしている。

- 強いパフォーマンス。自然言語理解、数学、コーディングなどを評価する一連のベンチマークデータセットにおいて、同程度のモデルサイズのモデルと比較して、競合他社を凌駕しています。

- 言語サポートの向上。Qwen-7B のトークナイザは、15 万以上のトークンの語彙をベースにしており、他のトークナイザに比べて効率的です。多くの言語に対応しており、ユーザが特定の言語を理解するために Qwen-7B をさらにファインチューニングするのに役立ちます。

- 8K コンテキスト長をサポート。Qwen-7B と Qwen-7B-Chat はともに 8K のコンテキスト長をサポートしており、長いコンテキストでの入力を可能にしている。

- プラグインのサポート。Qwen-7B-Chat は、プラグイン関連のアライメントデータでトレーニングされているため、API、モデル、データベースなどのツールを使用することができ、エージェントとしてプレイすることができる。

以下のセクションには、参考になる情報が記載されています。特に、issue を立ち上げる前に FAQ セクションをお読みになることをお勧めします。

ニュースとアップデート

- 2023.8.21 Qwen-7B-Chat 用 Int4 量子化モデル Qwen-7B-Chat-Int4 をリリースしました。また、ベンチマーク評価においても大きな性能低下は見られませんでした。

- 2023.8.3 ModelScope と Hugging Face 上で Qwen-7B と Qwen-7B-Chat をリリースしました。また、トレーニングの詳細やモデルの性能など、モデルの詳細については技術メモを提供しています。

パフォーマンス

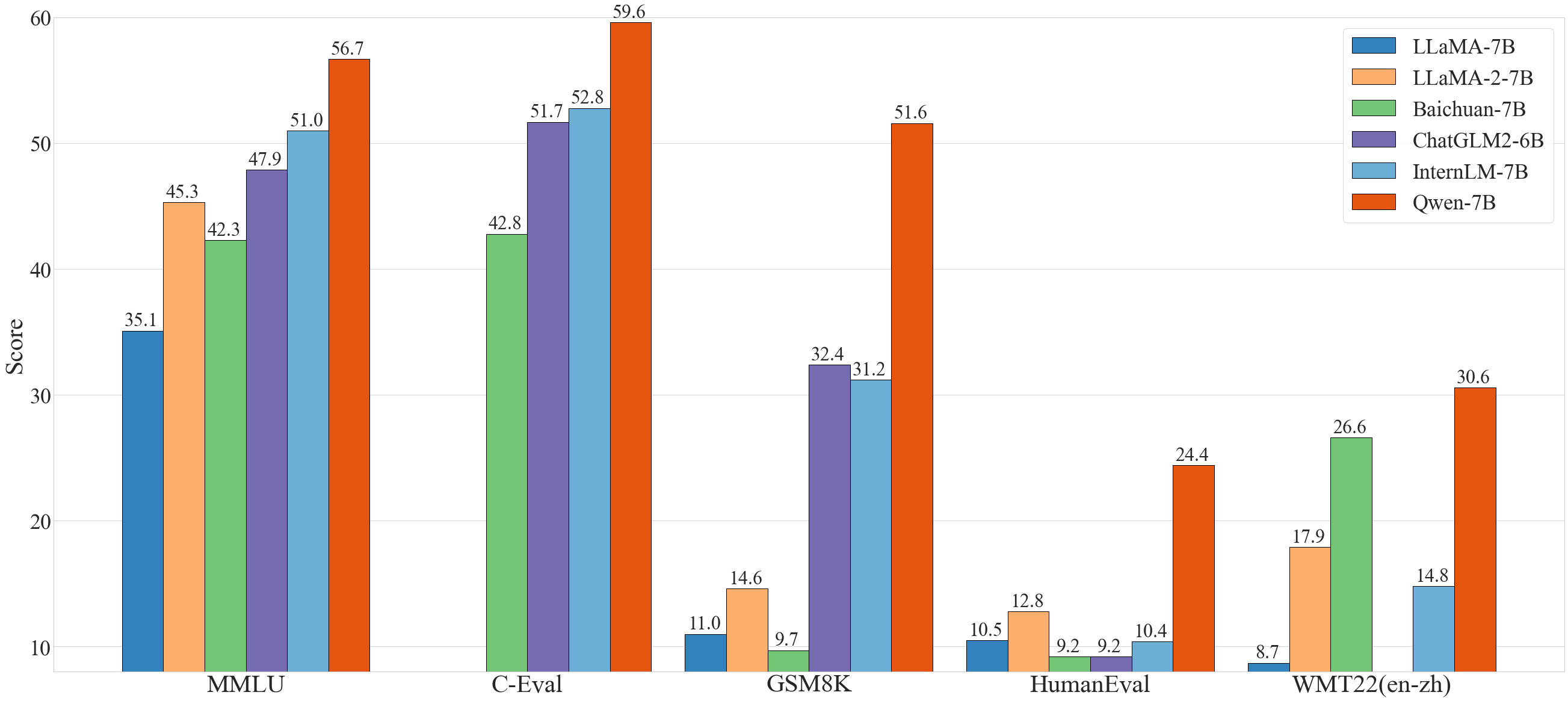

一般的に、Qwen-7B は、MMLU、C-Eval、GSM8K、HumanEval、WMT22、CMMLU など、自然言語理解、数学的問題解決、コーディングなどに関するモデルの能力を評価する一連のベンチマークデータセットにおいて、同程度のモデルサイズのベースラインモデルを凌駕しており、さらには 13B 程度のパラメータを持つより大規模なモデルをも凌駕しています。以下の結果をご覧ください。

| Model | MMLU | C-Eval | GSM8K | HumanEval | WMT22 (en-zh) | CMMLU |

|---|---|---|---|---|---|---|

| LLaMA-7B | 35.1 | - | 11.0 | 10.5 | 8.7 | - |

| LLaMA 2-7B | 45.3 | - | 14.6 | 12.8 | 17.9 | - |

| Baichuan-7B | 42.3 | 42.8 | 9.7 | 9.2 | 26.6 | 44.4 |

| ChatGLM2-6B | 47.9 | 51.7 | 32.4 | 9.2 | - | 48.8 |

| InternLM-7B | 51.0 | 52.8 | 31.2 | 10.4 | 14.8 | - |

| Baichuan-13B | 51.6 | 53.6 | 26.6 | 12.8 | 30.0 | 55.8 |

| LLaMA-13B | 46.9 | 35.5 | 17.8 | 15.8 | 12.0 | - |

| LLaMA 2-13B | 54.8 | - | 28.7 | 18.3 | 24.2 | - |

| ChatGLM2-12B | 56.2 | 61.6 | 40.9 | - | - | - |

| Qwen-7B | 56.7 | 59.6 | 51.6 | 24.4 | 30.6 | 58.8 |

さらに、OpenCompass が実施した大規模言語モデルの第三者評価によると、Qwen-7B と Qwen-7B-Chat は 7B パラメータモデルのトップになります。この評価は、言語理解・生成、コーディング、数学、推論などの評価のための大量の公開ベンチマークで構成されています。

より詳細な実験結果(より多くのベンチマークデータセットでの詳細なモデル性能)や詳細については、こちらをクリックして技術メモを参照してください。

必要条件

- python 3.8 以上

- pytorch 1.12 以上、2.0 以上を推奨

- CUDA 11.4 以上を推奨(GPU ユーザー、フラッシュアテンションユーザー向けなど)

クイックスタート

以下では、Qwen-7B と 🤖 ModelScope と 🤗 Transformers の簡単な使用例を示します。

コードを実行する前に、環境のセットアップと必要なパッケージのインストールが済んでいることを確認してください。上記の要件を満たしていることを確認してから、依存するライブラリをインストールしてください。

pip install -r requirements.txt

お使いのデバイスが fp16 または bf16 をサポートしている場合、flash-attention をインストールすることで、より高い効率とメモリ使用量を抑えることができます。(flash-attention はオプションであり、インストールしなくてもプロジェクトは正常に実行できます)

git clone -b v1.0.8 https://github.com/Dao-AILab/flash-attention

cd flash-attention && pip install .

# 以下はオプションです。インストールに時間がかかる場合があります。

# pip install csrc/layer_norm

# pip install csrc/rotary

これで ModelScope か Transformers で始めることができます。

🤗 Transformers

Qwen-7B-Chat を推論に使用するには、以下のように数行のコードを入力するだけです。最新のコードを使用していることを確認してください。

from transformers import AutoModelForCausalLM, AutoTokenizer

from transformers.generation import GenerationConfig

# 注: デフォルトの動作では、インジェクション攻撃防止機能がオフになっています。

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)

# bf16 を使用

# model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True, bf16=True).eval()

# fp16 を使用

# model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True, fp16=True).eval()

# CPU のみ使用

# model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="cpu", trust_remote_code=True).eval()

# オートモードを使用すると、デバイスに応じて自動的に精度が選択されます。

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="auto", trust_remote_code=True).eval()

# 生成のためのハイパーパラメータを指定

model.generation_config = GenerationConfig.from_pretrained("Qwen/Qwen-7B-Chat", trust_remote_code=True)

# 第一轮对话 第一回対話ターン

response, history = model.chat(tokenizer, "你好", history=None)

print(response)

# こんにちは! お役に立ててうれしいです。

# 第二轮对话 第二回対話ターン

response, history = model.chat(tokenizer, "给我讲一个年轻人奋斗创业最终取得成功的故事。", history=history)

print(response)

# これは、自分のビジネスを始めようと奮闘し、やがて成功する若者の物語である。

# この物語の主人公は、平凡な家庭に生まれ、平凡な労働者である両親を持つ李明である。 李明は子供の頃から起業家として成功することを目標としていた。

# この目標を達成するため、李明は猛勉強して大学に入った。 大学時代には、さまざまな起業家コンテストに積極的に参加し、多くの賞を獲得した。 また、余暇を利用してインターンシップにも参加し、貴重な経験を積んだ。

# 卒業後、李明は起業を決意した。 投資先を探し始めたが、何度も断られた。 しかし、彼はあきらめなかった。 彼は懸命に働き続け、ビジネスプランを改善し、新たな投資機会を探した。

# やがて李明は投資を受けることに成功し、自分のビジネスを始めた。 彼は新しいタイプのソフトウェアの開発に焦点を当てたテクノロジー会社を設立した。 彼のリーダーシップの下、会社は急速に成長し、テクノロジー企業として成功を収めた。

# 李明の成功は偶然ではない。 彼は勤勉で、たくましく、冒険好きで、常に学び、自分を高めている。 彼の成功はまた、努力すれば誰でも成功できることを証明している。

# 第三轮对话 第三回対話ターン

response, history = model.chat(tokenizer, "给这个故事起一个标题", history=history)

print(response)

# 《起業への奮闘:ある若者の成功への道》

Qwen-7B の学習済みベースモデルの実行も簡単です。

Qwen-7B の実行

from transformers import AutoModelForCausalLM, AutoTokenizer

from transformers.generation import GenerationConfig

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B", trust_remote_code=True)

# bf16 を使用

# model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B", device_map="auto", trust_remote_code=True, bf16=True).eval()

# fp16 を使用

# model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B", device_map="auto", trust_remote_code=True, fp16=True).eval()

# CPU のみ使用

# model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B", device_map="cpu", trust_remote_code=True).eval()

# オートモードを使用すると、デバイスに応じて自動的に精度が選択されます。

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B", device_map="auto", trust_remote_code=True).eval()

# 生成のためのハイパーパラメータを指定

model.generation_config = GenerationConfig.from_pretrained("Qwen/Qwen-7B", trust_remote_code=True)

inputs = tokenizer('モンゴルの首都はウランバートル(Ulaanbaatar)\nアイスランドの首都はレイキャビク(Reykjavik)\nエチオピアの首都は', return_tensors='pt')

inputs = inputs.to(model.device)

pred = model.generate(**inputs)

print(tokenizer.decode(pred.cpu()[0], skip_special_tokens=True))

# モンゴルの首都はウランバートル(Ulaanbaatar)\nアイスランドの首都はレイキャビク(Reykjavik)\nエチオピアの首都はアディスアベバ(Addis Ababa)...

🤖 ModelScope

ModelScope は、MaaS(Model-as-a-Service) のためのオープンソースプラットフォームであり、AI 開発者に柔軟で費用対効果の高いモデルサービスを提供します。同様に、以下のように ModelScope でモデルを実行することができます:

import os

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

from modelscope import snapshot_download

model_id = 'QWen/qwen-7b-chat'

revision = 'v1.0.0'

model_dir = snapshot_download(model_id, revision)

pipe = pipeline(

task=Tasks.chat, model=model_dir, device_map='auto')

history = None

text = '浙江省の省都はどこですか?'

results = pipe(text, history=history)

response, history = results['response'], results['history']

print(f'Response: {response}')

text = '何がそんなに面白いのか?'

results = pipe(text, history=history)

response, history = results['response'], results['history']

print(f'Response: {response}')

トークナイザー

tiktoken に基づくトークナイザーは、他のトークナイザー、例えばセンテンスピーストークナイザーとは異なります。特にファインチューニングの際には、特殊なトークンに注意を払う必要があります。トークナイザに関する詳細な情報や、ファインチューニングにおける使用方法については、ドキュメントを参照してください。

量子化

使用方法

注: AutoGPTQ に基づく新しい解決策を提供し、Qwen-7B-Chat 用の Int4 量子化モデルここをクリックをリリースしました。このモデルは、従来の解決策と比較して、ほぼ無損失のモデル効果を達成しつつ、メモリコストと推論速度の両方で性能が向上しています。

ここでは、量子化されたモデルを推論に使用する方法を示します。始める前に、AutoGPTQ の要件を満たしていることを確認し、ソースからインストールしてください(一時的に Qwen のコードは最新版の PyPI パッケージではまだリリースされていません):

git clone https://github.com/PanQiWei/AutoGPTQ.git && cd AutoGPTQ

pip install .

そうすれば、以下のように簡単に量子化モデルを読み込むことができます:

from auto_gptq import AutoGPTQForCausalLM

model = AutoGPTQForCausalLM.from_quantized("Qwen/Qwen-7B-Chat-Int4", device_map="auto", trust_remote_code=True, use_safetensors=True).eval()

推論を実行するには、上で示した基本的な使い方に似ていますが、generation configuration を明示的に渡すことを忘れないで下さい:

from transformers import GenerationConfig

config = GenerationConfig.from_pretrained("Qwen/Qwen-7B-Chat-Int4", trust_remote_code=True)

response, history = model.chat(tokenizer, "Hi", history=None, generation_config=config)

性能

ベンチマークにおける BF16 モデルと Int4 モデルの性能について説明します。その結果は以下に示します:

| Quantization | MMLU | CEval (val) | GSM8K | Humaneval |

|---|---|---|---|---|

| BF16 | 53.9 | 54.2 | 41.1 | 24.4 |

| Int4 | 52.6 | 52.9 | 38.1 | 23.8 |

推論スピード

BF16 の精度と Int4 の量子化レベルの下で、それぞれ 2048 個と 8192 個のトークンを生成する平均推論速度(tokens/s)を測定しました。

| Quantization | Speed (2048 tokens) | Speed (8192 tokens) |

|---|---|---|

| BF16 | 30.34 | 29.32 |

| Int4 | 43.56 | 33.92 |

詳細には、プロファイリングの設定は、1 コンテクストトークンで 8192 個の新しいトークンを生成しています。プロファイリングは、PyTorch 2.0.1 と CUDA 11.4 を搭載したシングル A100-SXM4-80G GPU で実行されました。推論速度は生成された 8192 個のトークンの平均値となります。

GPU メモリ使用量

また、BF16またはInt4の量子化レベルで、それぞれ2048トークンをコンテキストとしてエンコードした場合(および単一のトークンを生成した場合)と、8192トークンを生成した場合(単一のトークンをコンテキストとして生成した場合)のGPUメモリ使用量のピーク値をプロファイリングしました。その結果を以下に示します。

| Quantization Level | Peak Usage for Encoding 2048 Tokens | Peak Usage for Generating 8192 Tokens |

|---|---|---|

| BF16 | 17.66GB | 22.58GB |

| Int4 | 8.21GB | 13.62GB |

上記のスピードとメモリーのプロファイリングは、このスクリプトを使用しています。

デモ

ウェブ UI

ウェブ UI デモを構築するためのコードを提供します(@wysaid に感謝)。これを始める前に、以下のパッケージがインストールされていることを確認してください:

pip install -r requirements_web_demo.txt

そして、以下のコマンドを実行し、生成されたリンクをクリックします:

python web_demo.py

CLI デモ

cli_demo.py に CLI のデモ例を用意しています。ユーザはプロンプトを入力することで Qwen-7B-Chat と対話することができ、モデルはストリーミングモードでモデルの出力を返します。以下のコマンドを実行する:

python cli_demo.py

API

OpenAI API をベースにローカルAPIをデプロイする方法を提供する(@hanpenggit に感謝)。始める前に、必要なパッケージをインストールしてください:

pip install fastapi uvicorn openai pydantic sse_starlette

それから、API をデプロイするコマンドを実行します:

python openai_api.py

チェックポイント名やパスには -c、CPU デプロイメントには --cpu-only など、引数を変更できます。API デプロイメントを起動する際に問題が発生した場合は、パッケージを最新バージョンに更新することで解決できる可能性があります。

API の使い方も簡単です。以下の例をご覧ください:

import openai

openai.api_base = "http://localhost:8000/v1"

openai.api_key = "none"

# ストリーミングレスポンスを有効化するリクエストを作成する

for chunk in openai.ChatCompletion.create(

model="Qwen",

messages=[

{"role": "user", "content": "你好"}

],

stream=True

# ストリーミング出力形式でのストップワードの指定はまだサポートされておらず、開発中です。

):

if hasattr(chunk.choices[0].delta, "content"):

print(chunk.choices[0].delta.content, end="", flush=True)

# ストリーミングレスポンスを有効化しないリクエストを作成する

response = openai.ChatCompletion.create(

model="Qwen",

messages=[

{"role": "user", "content": "你好"}

],

stream=False,

stop=[] # 例えば、stop=["Observation:"] (ReAct プロンプトの場合)。

)

print(response.choices[0].message.content)

デプロイ

CPU 上でモデルを実行するのは簡単であり、以下のようにデバイスを指定する必要があります:

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen-7B-Chat", device_map="cpu", trust_remote_code=True).eval()

メモリ不足に悩まされ、複数の GPU にモデルをデプロイしたい場合は、utils.py で提供されているスクリプトを使うことができます:

from utils import load_model_on_gpus

model = load_model_on_gpus('Qwen/Qwen-7B-Chat', num_gpus=2)

7B チャットモデルの推論を 2GPU で実行できます。

ツールの使用

Qwen-7B-Chat は、API、データベース、モデルなど、ツールの利用に特化して最適化されており、ユーザは独自の Qwen-7B ベースの LangChain、エージェント、コードインタプリタを構築することができます。ツール利用能力を評価するための評価ベンチマークでは、Qwen-7B は安定した性能に達しています。

| Model | Tool Selection (Acc.↑) | Tool Input (Rouge-L↑) | False Positive Error↓ |

|---|---|---|---|

| GPT-4 | 95% | 0.90 | 15% |

| GPT-3.5 | 85% | 0.88 | 75% |

| Qwen-7B-Chat | 99% | 0.89 | 9.7% |

ReAct プロンプトの書き方や使い方については、ReAct の例を参照してください。ツールを使用することで、モデルがよりよいタスクを実行できるようになります。

さらに、エージェントとしての能力を示す実験結果を提供する。詳細は Hugging Face Agent を参照して下さい。Hugging Face が提供するランモードベンチマークでの性能は以下の通りです:

| Model | Tool Selection↑ | Tool Used↑ | Code↑ |

|---|---|---|---|

| GPT-4 | 100 | 100 | 97.41 |

| GPT-3.5 | 95.37 | 96.30 | 87.04 |

| StarCoder-15.5B | 87.04 | 87.96 | 68.89 |

| Qwen-7B-Chat | 90.74 | 92.59 | 74.07 |

長い文脈の理解

コンテキストの長さを拡張し、訓練シーケンスの長さのボトルネックを解消するために、NTK を考慮した補間、ウィンドウアテンション、LogN アテンションスケーリングなどの技術を導入し、コンテキストの長さを 8K トークン以上に拡張する。arXiv データセットを用いて PPL 評価による言語モデリング実験を行い、Qwen-7B が長いコンテキストのシナリオにおいて卓越した性能を達成できることを見出した。以下に結果を示します:

| Model | Sequence Length | ||||

|---|---|---|---|---|---|

| 1024 | 2048 | 4096 | 8192 | 16384 | |

| Qwen-7B | 4.23 | 3.78 | 39.35 | 469.81 | 2645.09 |

| + dynamic_ntk | 4.23 | 3.78 | 3.59 | 3.66 | 5.71 |

| + dynamic_ntk + logn | 4.23 | 3.78 | 3.58 | 3.56 | 4.62 |

| + dynamic_ntk + logn + window_attn | 4.23 | 3.78 | 3.58 | 3.49 | 4.32 |

再現

ベンチマークデータセットでのモデル性能の再現のために、結果を再現するスクリプトを提供しています。詳しくは eval/EVALUATION.md を確認してください。なお、再現の結果、我々の報告結果と若干異なる場合があります。

FAQ

問題が発生した場合は、まずは FAQ や issue を参照し、新しい issue を立ち上げる前に解決策を探してください。

ライセンス契約

Qwen-7B と Qwen-7B-Chat のコードとモデルウェイトは、研究者や開発者が自由に使用することができます。また、商用利用も可能です。詳しくは LICENSE をご覧ください。商用利用を希望される方は、リクエストフォームに必要事項をご記入の上、お申し込みください。

お問い合わせ

研究チームまたは製品チームへのメッセージは、qianwen_opensource@alibabacloud.com までお気軽にお送りください。