Transformers documentation

Ein Modell teilen

Ein Modell teilen

Die letzten beiden Tutorials haben gezeigt, wie man ein Modell mit PyTorch, Keras und 🤗 Accelerate für verteilte Setups feinabstimmen kann. Der nächste Schritt besteht darin, Ihr Modell mit der Community zu teilen! Bei Hugging Face glauben wir an den offenen Austausch von Wissen und Ressourcen, um künstliche Intelligenz für alle zu demokratisieren. Wir ermutigen Sie, Ihr Modell mit der Community zu teilen, um anderen zu helfen, Zeit und Ressourcen zu sparen.

In diesem Tutorial lernen Sie zwei Methoden kennen, wie Sie ein trainiertes oder verfeinertes Modell auf dem Model Hub teilen können:

- Programmgesteuertes Übertragen Ihrer Dateien auf den Hub.

- Ziehen Sie Ihre Dateien per Drag-and-Drop über die Weboberfläche in den Hub.

Um ein Modell mit der Öffentlichkeit zu teilen, benötigen Sie ein Konto auf huggingface.co. Sie können auch einer bestehenden Organisation beitreten oder eine neue Organisation gründen.

Repository-Funktionen

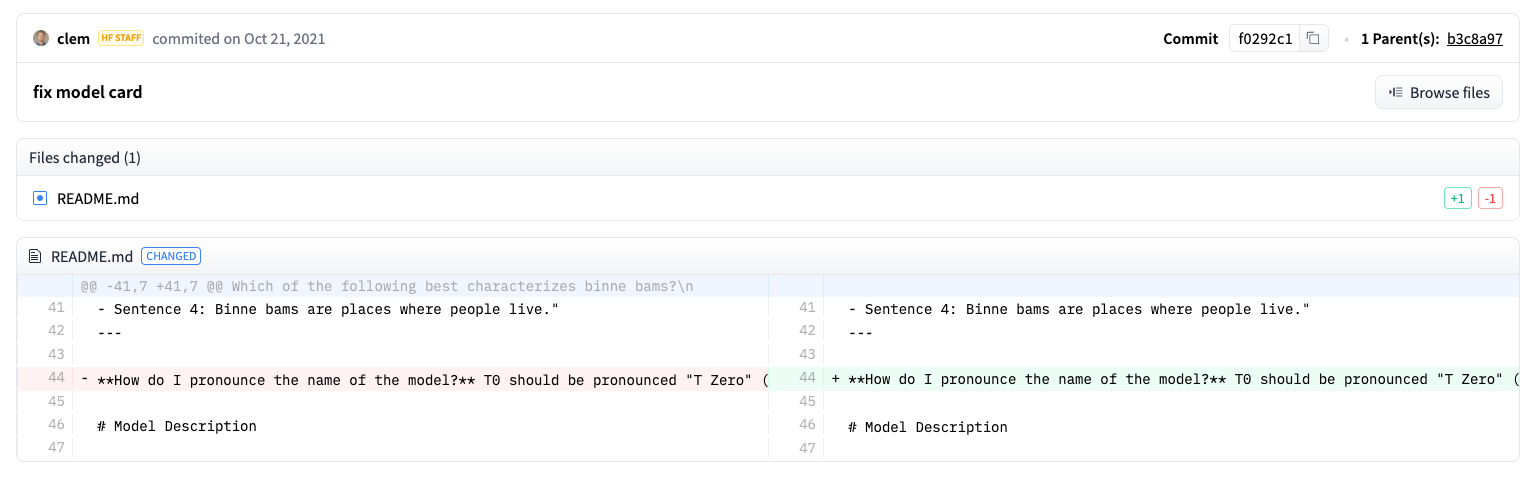

Jedes Repository im Model Hub verhält sich wie ein typisches GitHub-Repository. Unsere Repositorys bieten Versionierung, Commit-Historie und die Möglichkeit, Unterschiede zu visualisieren.

Die integrierte Versionierung des Model Hub basiert auf Git und git-lfs. Mit anderen Worten: Sie können ein Modell als ein Repository behandeln, was eine bessere Zugriffskontrolle und Skalierbarkeit ermöglicht. Die Versionskontrolle ermöglicht Revisionen, eine Methode zum Anheften einer bestimmten Version eines Modells mit einem Commit-Hash, Tag oder Branch.

Folglich können Sie eine bestimmte Modellversion mit dem Parameter “Revision” laden:

>>> model = AutoModel.from_pretrained(

... "julien-c/EsperBERTo-small", revision="v2.0.1" # tag name, or branch name, or commit hash

... )Dateien lassen sich auch in einem Repository leicht bearbeiten, und Sie können die Commit-Historie sowie die Unterschiede einsehen:

Einrichtung

Bevor Sie ein Modell für den Hub freigeben, benötigen Sie Ihre Hugging Face-Anmeldedaten. Wenn Sie Zugang zu einem Terminal haben, führen Sie den folgenden Befehl in der virtuellen Umgebung aus, in der 🤗 Transformers installiert ist. Dadurch werden Ihre Zugangsdaten in Ihrem Hugging Face-Cache-Ordner (standardmäßig ~/.cache/) gespeichert:

huggingface-cli login

Wenn Sie ein Notebook wie Jupyter oder Colaboratory verwenden, stellen Sie sicher, dass Sie die huggingface_hub Bibliothek installiert haben. Diese Bibliothek ermöglicht Ihnen die programmatische Interaktion mit dem Hub.

pip install huggingface_hub

Verwenden Sie dann notebook_login, um sich beim Hub anzumelden, und folgen Sie dem Link hier, um ein Token für die Anmeldung zu generieren:

>>> from huggingface_hub import notebook_login

>>> notebook_login()Ein Modell für alle Frameworks konvertieren

Um sicherzustellen, dass Ihr Modell von jemandem verwendet werden kann, der mit einem anderen Framework arbeitet, empfehlen wir Ihnen, Ihr Modell sowohl mit PyTorch- als auch mit TensorFlow-Checkpoints zu konvertieren und hochzuladen. Während Benutzer immer noch in der Lage sind, Ihr Modell von einem anderen Framework zu laden, wenn Sie diesen Schritt überspringen, wird es langsamer sein, weil 🤗 Transformers den Checkpoint on-the-fly konvertieren müssen.

Die Konvertierung eines Checkpoints für ein anderes Framework ist einfach. Stellen Sie sicher, dass Sie PyTorch und TensorFlow installiert haben (siehe hier für Installationsanweisungen), und finden Sie dann das spezifische Modell für Ihre Aufgabe in dem anderen Framework.

Geben Sie from_tf=True an, um einen Prüfpunkt von TensorFlow nach PyTorch zu konvertieren:

>>> pt_model = DistilBertForSequenceClassification.from_pretrained("path/to/awesome-name-you-picked", from_tf=True)

>>> pt_model.save_pretrained("path/to/awesome-name-you-picked")Geben Sie from_pt=True an, um einen Prüfpunkt von PyTorch nach TensorFlow zu konvertieren:

>>> tf_model = TFDistilBertForSequenceClassification.from_pretrained("path/to/awesome-name-you-picked", from_pt=True)Dann können Sie Ihr neues TensorFlow-Modell mit seinem neuen Checkpoint speichern:

>>> tf_model.save_pretrained("path/to/awesome-name-you-picked")Wenn ein Modell in Flax verfügbar ist, können Sie auch einen Kontrollpunkt von PyTorch nach Flax konvertieren:

>>> flax_model = FlaxDistilBertForSequenceClassification.from_pretrained(

... "path/to/awesome-name-you-picked", from_pt=True

... )Ein Modell während des Trainings hochladen

Die Weitergabe eines Modells an den Hub ist so einfach wie das Hinzufügen eines zusätzlichen Parameters oder Rückrufs. Erinnern Sie sich an das Feinabstimmungs-Tutorial, in der Klasse TrainingArguments geben Sie Hyperparameter und zusätzliche Trainingsoptionen an. Eine dieser Trainingsoptionen beinhaltet die Möglichkeit, ein Modell direkt an den Hub zu pushen. Setzen Sie push_to_hub=True in Ihrer TrainingArguments:

>>> training_args = TrainingArguments(output_dir="my-awesome-model", push_to_hub=True)Übergeben Sie Ihre Trainingsargumente wie gewohnt an Trainer:

>>> trainer = Trainer(

... model=model,

... args=training_args,

... train_dataset=small_train_dataset,

... eval_dataset=small_eval_dataset,

... compute_metrics=compute_metrics,

... )Nach der Feinabstimmung Ihres Modells rufen Sie push_to_hub() auf Trainer auf, um das trainierte Modell an den Hub zu übertragen. Transformers fügt sogar automatisch Trainings-Hyperparameter, Trainingsergebnisse und Framework-Versionen zu Ihrer Modellkarte hinzu!

>>> trainer.push_to_hub()Geben Sie ein Modell mit PushToHubCallback an den Hub weiter. In der PushToHubCallback Funktion, fügen Sie hinzu:

- Ein Ausgabeverzeichnis für Ihr Modell.

- Einen Tokenizer.

- Die

hub_model_id, die Ihr Hub-Benutzername und Modellname ist.

>>> from transformers import PushToHubCallback

>>> push_to_hub_callback = PushToHubCallback(

... output_dir="./your_model_save_path", tokenizer=tokenizer, hub_model_id="your-username/my-awesome-model"

... )Fügen Sie den Callback zu fit hinzu, und 🤗 Transformers wird das trainierte Modell an den Hub weiterleiten:

>>> model.fit(tf_train_dataset, validation_data=tf_validation_dataset, epochs=3, callbacks=push_to_hub_callback)Verwenden Sie die Funktion push_to_hub .

Sie können push_to_hub auch direkt für Ihr Modell aufrufen, um es in den Hub hochzuladen.

Geben Sie den Namen Ihres Modells in “push_to_hub” an:

>>> pt_model.push_to_hub("my-awesome-model")Dadurch wird ein Repository unter Ihrem Benutzernamen mit dem Modellnamen my-awesome-model erstellt. Benutzer können nun Ihr Modell mit der Funktion from_pretrained laden:

>>> from transformers import AutoModel

>>> model = AutoModel.from_pretrained("your_username/my-awesome-model")Wenn Sie zu einer Organisation gehören und Ihr Modell stattdessen unter dem Namen der Organisation pushen wollen, fügen Sie diesen einfach zur repo_id hinzu:

>>> pt_model.push_to_hub("my-awesome-org/my-awesome-model")Die Funktion “push_to_hub” kann auch verwendet werden, um andere Dateien zu einem Modell-Repository hinzuzufügen. Zum Beispiel kann man einen Tokenizer zu einem Modell-Repository hinzufügen:

>>> tokenizer.push_to_hub("my-awesome-model")Oder vielleicht möchten Sie die TensorFlow-Version Ihres fein abgestimmten PyTorch-Modells hinzufügen:

>>> tf_model.push_to_hub("my-awesome-model")Wenn Sie nun zu Ihrem Hugging Face-Profil navigieren, sollten Sie Ihr neu erstelltes Modell-Repository sehen. Wenn Sie auf die Registerkarte Dateien klicken, werden alle Dateien angezeigt, die Sie in das Repository hochgeladen haben.

Weitere Einzelheiten zum Erstellen und Hochladen von Dateien in ein Repository finden Sie in der Hub-Dokumentation hier.

Hochladen mit der Weboberfläche

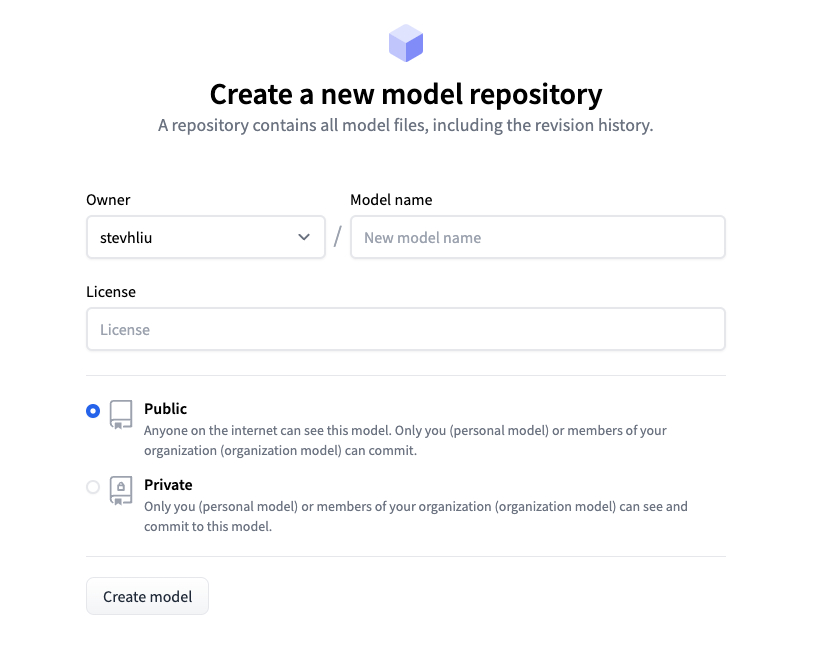

Benutzer, die einen no-code Ansatz bevorzugen, können ein Modell über das Webinterface des Hubs hochladen. Besuchen Sie huggingface.co/new um ein neues Repository zu erstellen:

Fügen Sie von hier aus einige Informationen über Ihr Modell hinzu:

- Wählen Sie den Besitzer des Repositorys. Dies können Sie selbst oder eine der Organisationen sein, denen Sie angehören.

- Wählen Sie einen Namen für Ihr Modell, der auch der Name des Repositorys sein wird.

- Wählen Sie, ob Ihr Modell öffentlich oder privat ist.

- Geben Sie die Lizenzverwendung für Ihr Modell an.

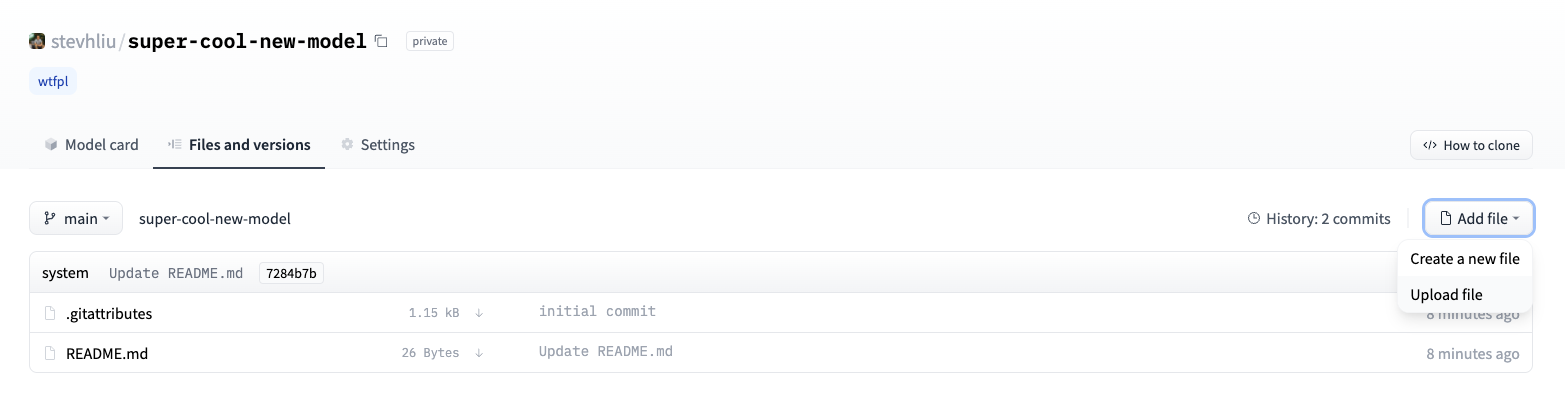

Klicken Sie nun auf die Registerkarte Dateien und klicken Sie auf die Schaltfläche Datei hinzufügen, um eine neue Datei in Ihr Repository hochzuladen. Ziehen Sie dann eine Datei per Drag-and-Drop hoch und fügen Sie eine Übergabemeldung hinzu.

Hinzufügen einer Modellkarte

Um sicherzustellen, dass die Benutzer die Fähigkeiten, Grenzen, möglichen Verzerrungen und ethischen Aspekte Ihres Modells verstehen, fügen Sie bitte eine Modellkarte zu Ihrem Repository hinzu. Die Modellkarte wird in der Datei README.md definiert. Sie können eine Modellkarte hinzufügen, indem Sie:

- Manuelles Erstellen und Hochladen einer “README.md”-Datei.

- Klicken Sie auf die Schaltfläche Modellkarte bearbeiten in Ihrem Modell-Repository.

Werfen Sie einen Blick auf die DistilBert model card als gutes Beispiel für die Art von Informationen, die eine Modellkarte enthalten sollte. Weitere Details über andere Optionen, die Sie in der Datei “README.md” einstellen können, wie z.B. den Kohlenstoff-Fußabdruck eines Modells oder Beispiele für Widgets, finden Sie in der Dokumentation hier.

< > Update on GitHub