Commit

•

591d836

1

Parent(s):

c35aef8

Create README.md

Browse files

README.md

ADDED

|

@@ -0,0 +1,120 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

---

|

| 2 |

+

language: pt

|

| 3 |

+

license: mit

|

| 4 |

+

tags:

|

| 5 |

+

- question-answering

|

| 6 |

+

- bert

|

| 7 |

+

- bert-large

|

| 8 |

+

- pytorch

|

| 9 |

+

datasets:

|

| 10 |

+

- brWaC

|

| 11 |

+

- squad

|

| 12 |

+

metrics:

|

| 13 |

+

- squad

|

| 14 |

+

widget:

|

| 15 |

+

- text: "Quando começou a pandemia de Covid-19 no mundo?"

|

| 16 |

+

context: "A pandemia de COVID-19, também conhecida como pandemia de coronavírus, é uma pandemia em curso de COVID-19, uma doença respiratória causada pelo coronavírus da síndrome respiratória aguda grave 2 (SARS-CoV-2). O vírus tem origem zoonótica e o primeiro caso conhecido da doença remonta a dezembro de 2019 em Wuhan, na China."

|

| 17 |

+

- text: "Onde foi descoberta a Covid-19?"

|

| 18 |

+

context: "A pandemia de COVID-19, também conhecida como pandemia de coronavírus, é uma pandemia em curso de COVID-19, uma doença respiratória causada pelo coronavírus da síndrome respiratória aguda grave 2 (SARS-CoV-2). O vírus tem origem zoonótica e o primeiro caso conhecido da doença remonta a dezembro de 2019 em Wuhan, na China."

|

| 19 |

+

---

|

| 20 |

+

|

| 21 |

+

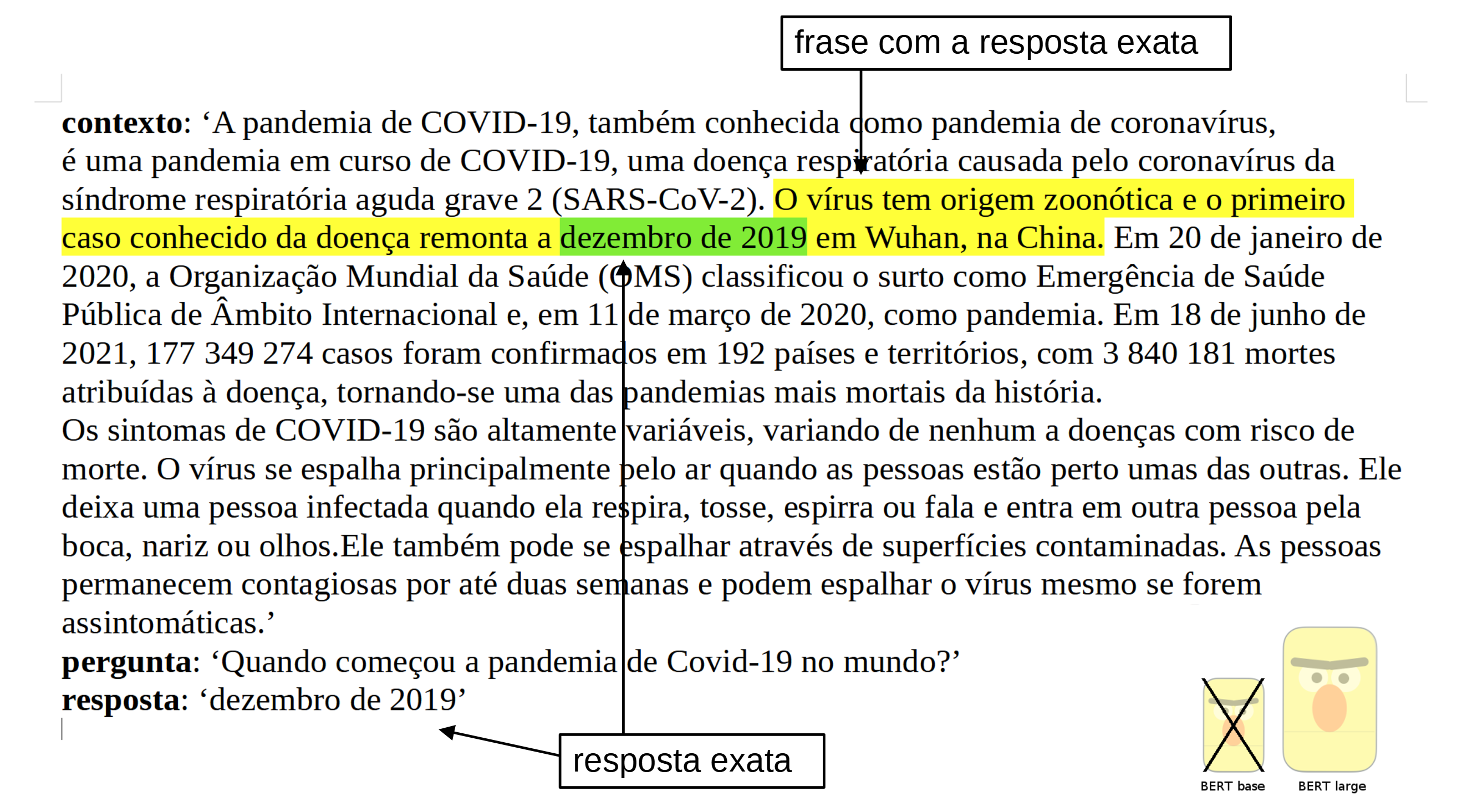

# Portuguese BERT large cased QA (Question Answering), finetuned on SQUAD v1.1

|

| 22 |

+

|

| 23 |

+

|

| 24 |

+

|

| 25 |

+

## Introduction

|

| 26 |

+

|

| 27 |

+

The model was trained on the dataset SQUAD v1.1 in portuguese from the [Deep Learning Brasil group](http://www.deeplearningbrasil.com.br/).

|

| 28 |

+

|

| 29 |

+

The language model used is the [BERTimbau Large](https://huggingface.co/neuralmind/bert-large-portuguese-cased) (aka "bert-large-portuguese-cased") from [Neuralmind.ai](https://neuralmind.ai/): BERTimbau is a pretrained BERT model for Brazilian Portuguese that achieves state-of-the-art performances on three downstream NLP tasks: Named Entity Recognition, Sentence Textual Similarity and Recognizing Textual Entailment. It is available in two sizes: Base and Large.

|

| 30 |

+

|

| 31 |

+

## Informations on the method used

|

| 32 |

+

|

| 33 |

+

All the informations are in the blog post : [NLP | Como treinar um modelo de Question Answering em qualquer linguagem baseado no BERT large, melhorando o desempenho do modelo utilizando o BERT base? (estudo de caso em português)](https://medium.com/@pierre_guillou/nlp-como-treinar-um-modelo-de-question-answering-em-qualquer-linguagem-baseado-no-bert-large-1c899262dd96)

|

| 34 |

+

|

| 35 |

+

## Notebook in GitHub

|

| 36 |

+

|

| 37 |

+

[question_answering_BERT_large_cased_squad_v11_pt.ipynb](https://github.com/piegu/language-models/blob/master/question_answering_BERT_large_cased_squad_v11_pt.ipynb) ([nbviewer version](https://nbviewer.jupyter.org/github/piegu/language-models/blob/master/question_answering_BERT_large_cased_squad_v11_pt.ipynb))

|

| 38 |

+

|

| 39 |

+

## Performance

|

| 40 |

+

|

| 41 |

+

The results obtained are the following:

|

| 42 |

+

|

| 43 |

+

```

|

| 44 |

+

f1 = 84.43 (against 82.50 for the base model)

|

| 45 |

+

exact match = 72.68 (against 70.49 for the base model)

|

| 46 |

+

```

|

| 47 |

+

|

| 48 |

+

## How to use the model... with Pipeline

|

| 49 |

+

|

| 50 |

+

```python

|

| 51 |

+

import transformers

|

| 52 |

+

from transformers import pipeline

|

| 53 |

+

|

| 54 |

+

# source: https://pt.wikipedia.org/wiki/Pandemia_de_COVID-19

|

| 55 |

+

context = r"""

|

| 56 |

+

A pandemia de COVID-19, também conhecida como pandemia de coronavírus, é uma pandemia em curso de COVID-19,

|

| 57 |

+

uma doença respiratória causada pelo coronavírus da síndrome respiratória aguda grave 2 (SARS-CoV-2).

|

| 58 |

+

O vírus tem origem zoonótica e o primeiro caso conhecido da doença remonta a dezembro de 2019 em Wuhan, na China.

|

| 59 |

+

Em 20 de janeiro de 2020, a Organização Mundial da Saúde (OMS) classificou o surto

|

| 60 |

+

como Emergência de Saúde Pública de Âmbito Internacional e, em 11 de março de 2020, como pandemia.

|

| 61 |

+

Em 18 de junho de 2021, 177 349 274 casos foram confirmados em 192 países e territórios,

|

| 62 |

+

com 3 840 181 mortes atribuídas à doença, tornando-se uma das pandemias mais mortais da história.

|

| 63 |

+

Os sintomas de COVID-19 são altamente variáveis, variando de nenhum a doenças com risco de morte.

|

| 64 |

+

O vírus se espalha principalmente pelo ar quando as pessoas estão perto umas das outras.

|

| 65 |

+

Ele deixa uma pessoa infectada quando ela respira, tosse, espirra ou fala e entra em outra pessoa pela boca, nariz ou olhos.

|

| 66 |

+

Ele também pode se espalhar através de superfícies contaminadas.

|

| 67 |

+

As pessoas permanecem contagiosas por até duas semanas e podem espalhar o vírus mesmo se forem assintomáticas.

|

| 68 |

+

"""

|

| 69 |

+

|

| 70 |

+

model_name = 'pierreguillou/bert-large-cased-squad-v1.1-portuguese'

|

| 71 |

+

nlp = pipeline("question-answering", model=model_name)

|

| 72 |

+

|

| 73 |

+

question = "Quando começou a pandemia de Covid-19 no mundo?"

|

| 74 |

+

|

| 75 |

+

result = nlp(question=question, context=context)

|

| 76 |

+

|

| 77 |

+

print(f"Answer: '{result['answer']}', score: {round(result['score'], 4)}, start: {result['start']}, end: {result['end']}")

|

| 78 |

+

|

| 79 |

+

# Answer: 'dezembro de 2019', score: 0.5087, start: 290, end: 306

|

| 80 |

+

```

|

| 81 |

+

|

| 82 |

+

## How to use the model... with the Auto classes

|

| 83 |

+

|

| 84 |

+

```python

|

| 85 |

+

from transformers import AutoTokenizer, AutoModelForQuestionAnswering

|

| 86 |

+

|

| 87 |

+

tokenizer = AutoTokenizer.from_pretrained("pierreguillou/bert-large-cased-squad-v1.1-portuguese")

|

| 88 |

+

model = AutoModelForQuestionAnswering.from_pretrained("pierreguillou/bert-large-cased-squad-v1.1-portuguese")

|

| 89 |

+

```

|

| 90 |

+

|

| 91 |

+

Or just clone the model repo:

|

| 92 |

+

|

| 93 |

+

```python

|

| 94 |

+

git lfs install

|

| 95 |

+

git clone https://huggingface.co/pierreguillou/bert-large-cased-squad-v1.1-portuguese

|

| 96 |

+

|

| 97 |

+

# if you want to clone without large files – just their pointers

|

| 98 |

+

# prepend your git clone with the following env var:

|

| 99 |

+

|

| 100 |

+

GIT_LFS_SKIP_SMUDGE=1

|

| 101 |

+

```

|

| 102 |

+

|

| 103 |

+

## Limitations and bias

|

| 104 |

+

|

| 105 |

+

The training data used for this model come from Portuguese SQUAD. It could contain a lot of unfiltered content, which is far from neutral, and biases.

|

| 106 |

+

|

| 107 |

+

## Author

|

| 108 |

+

|

| 109 |

+

Portuguese BERT large cased QA (Question Answering), finetuned on SQUAD v1.1 was trained and evaluated by [Pierre GUILLOU](https://www.linkedin.com/in/pierreguillou/) thanks to the Open Source code, platforms and advices of many organizations ([link to the list](https://medium.com/@pierre_guillou/nlp-como-treinar-um-modelo-de-question-answering-em-qualquer-linguagem-baseado-no-bert-large-1c899262dd96#c2f5)). In particular: [Hugging Face](https://huggingface.co/), [Neuralmind.ai](https://neuralmind.ai/), [Deep Learning Brasil group](http://www.deeplearningbrasil.com.br/) and [AI Lab](https://ailab.unb.br/).

|

| 110 |

+

|

| 111 |

+

## Citation

|

| 112 |

+

If you use our work, please cite:

|

| 113 |

+

|

| 114 |

+

```bibtex

|

| 115 |

+

@inproceedings{pierreguillou2021bertlargecasedsquadv11portuguese,

|

| 116 |

+

title={Portuguese BERT large cased QA (Question Answering), finetuned on SQUAD v1.1},

|

| 117 |

+

author={Pierre Guillou},

|

| 118 |

+

year={2021}

|

| 119 |

+

}

|

| 120 |

+

```

|