Upload README.md with huggingface_hub

Browse files

README.md

ADDED

|

@@ -0,0 +1,110 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

---

|

| 2 |

+

base_model: cenkersisman/gpt2-turkish-128-token

|

| 3 |

+

inference: false

|

| 4 |

+

language:

|

| 5 |

+

- tr

|

| 6 |

+

model_creator: cenkersisman

|

| 7 |

+

model_name: gpt2-turkish-128-token

|

| 8 |

+

pipeline_tag: text-generation

|

| 9 |

+

quantized_by: afrideva

|

| 10 |

+

tags:

|

| 11 |

+

- gguf

|

| 12 |

+

- ggml

|

| 13 |

+

- quantized

|

| 14 |

+

- q2_k

|

| 15 |

+

- q3_k_m

|

| 16 |

+

- q4_k_m

|

| 17 |

+

- q5_k_m

|

| 18 |

+

- q6_k

|

| 19 |

+

- q8_0

|

| 20 |

+

widget:

|

| 21 |

+

- example_title: fransa'nın başkenti

|

| 22 |

+

text: fransa'nın başkenti

|

| 23 |

+

- example_title: ingiltere'nin başkenti

|

| 24 |

+

text: ingiltere'nın başkenti

|

| 25 |

+

- example_title: italya'nın başkenti

|

| 26 |

+

text: italya'nın başkenti

|

| 27 |

+

- example_title: moğolistan'ın başkenti

|

| 28 |

+

text: moğolistan'ın başkenti

|

| 29 |

+

- example_title: amazon ormanlarının bulunduğu ülke olan

|

| 30 |

+

text: amazon ormanlarının bulunduğu ülke olan

|

| 31 |

+

- example_title: avrupa'yı asya'ya bağlayan şehir

|

| 32 |

+

text: avrupa'yı asya'ya bağlayan şehir

|

| 33 |

+

- example_title: zebraların yaşadığı kıta olan

|

| 34 |

+

text: zebraların yaşadığı kıta olan

|

| 35 |

+

- example_title: fenerbahçe'nin ezeli rakibi olan

|

| 36 |

+

text: fenerbahçe'nin ezeli rakibi olan

|

| 37 |

+

- example_title: tek bacaklı kurbağa

|

| 38 |

+

text: tek bacaklı kurbağa

|

| 39 |

+

- example_title: rize'de yağmur

|

| 40 |

+

text: rize'de yağmur

|

| 41 |

+

- example_title: hayatın anlamı

|

| 42 |

+

text: hayatın anlamı

|

| 43 |

+

- example_title: saint-joseph

|

| 44 |

+

text: saint-joseph

|

| 45 |

+

- example_title: renk isimleri şunlardır

|

| 46 |

+

text: renk isimleri şunlardır

|

| 47 |

+

- example_title: iklim değişikliği

|

| 48 |

+

text: iklim değişikliği

|

| 49 |

+

- example_title: tuzlu yiyecekler arasında

|

| 50 |

+

text: tuzlu yiyecekler arasında

|

| 51 |

+

---

|

| 52 |

+

# cenkersisman/gpt2-turkish-128-token-GGUF

|

| 53 |

+

|

| 54 |

+

Quantized GGUF model files for [gpt2-turkish-128-token](https://huggingface.co/cenkersisman/gpt2-turkish-128-token) from [cenkersisman](https://huggingface.co/cenkersisman)

|

| 55 |

+

|

| 56 |

+

|

| 57 |

+

| Name | Quant method | Size |

|

| 58 |

+

| ---- | ---- | ---- |

|

| 59 |

+

| [gpt2-turkish-128-token.fp16.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.fp16.gguf) | fp16 | 328.01 MB |

|

| 60 |

+

| [gpt2-turkish-128-token.q2_k.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.q2_k.gguf) | q2_k | 81.10 MB |

|

| 61 |

+

| [gpt2-turkish-128-token.q3_k_m.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.q3_k_m.gguf) | q3_k_m | 95.37 MB |

|

| 62 |

+

| [gpt2-turkish-128-token.q4_k_m.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.q4_k_m.gguf) | q4_k_m | 110.07 MB |

|

| 63 |

+

| [gpt2-turkish-128-token.q5_k_m.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.q5_k_m.gguf) | q5_k_m | 124.01 MB |

|

| 64 |

+

| [gpt2-turkish-128-token.q6_k.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.q6_k.gguf) | q6_k | 135.82 MB |

|

| 65 |

+

| [gpt2-turkish-128-token.q8_0.gguf](https://huggingface.co/afrideva/gpt2-turkish-128-token-GGUF/resolve/main/gpt2-turkish-128-token.q8_0.gguf) | q8_0 | 175.27 MB |

|

| 66 |

+

|

| 67 |

+

|

| 68 |

+

|

| 69 |

+

## Original Model Card:

|

| 70 |

+

# Model

|

| 71 |

+

|

| 72 |

+

GPT-2 Türkçe Modeli

|

| 73 |

+

|

| 74 |

+

### Model Açıklaması

|

| 75 |

+

|

| 76 |

+

GPT-2 Türkçe Modeli, Türkçe diline özelleştirilmiş olan GPT-2 mimarisi temel alınarak oluşturulmuş bir dil modelidir. Belirli bir başlangıç metni temel alarak insana benzer metinler üretme yeteneğine sahiptir ve geniş bir Türkçe metin veri kümesi üzerinde eğitilmiştir.

|

| 77 |

+

Modelin eğitimi için 900 milyon karakterli Vikipedi seti kullanılmıştır. Eğitim setindeki cümleler maksimum 128 tokendan (token = kelime kökü ve ekleri) oluşmuştur bu yüzden oluşturacağı cümlelerin boyu sınırlıdır..

|

| 78 |

+

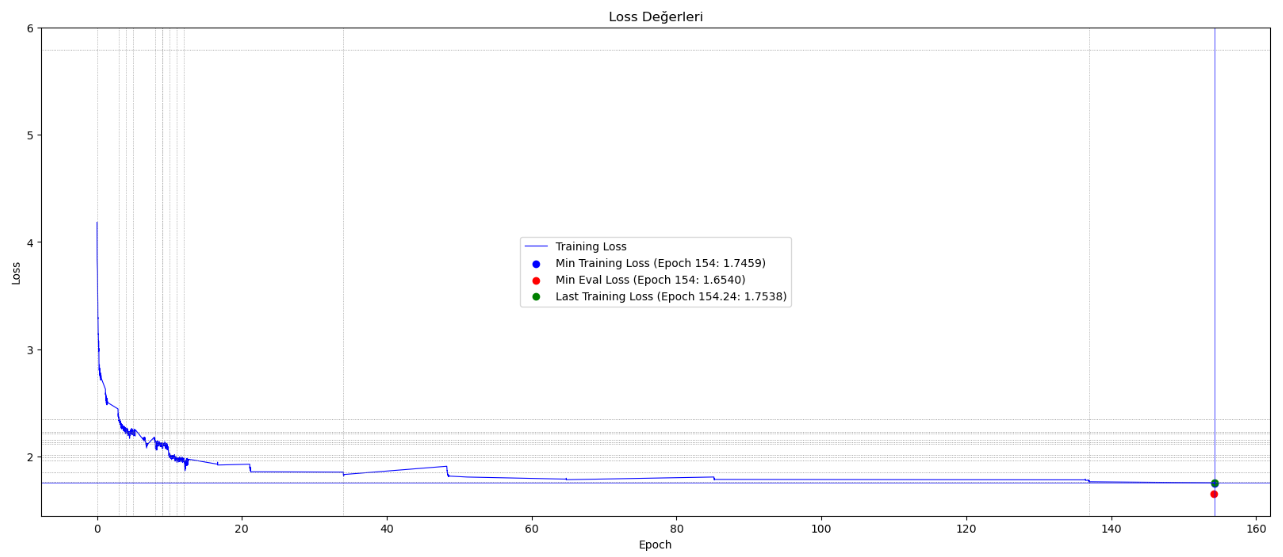

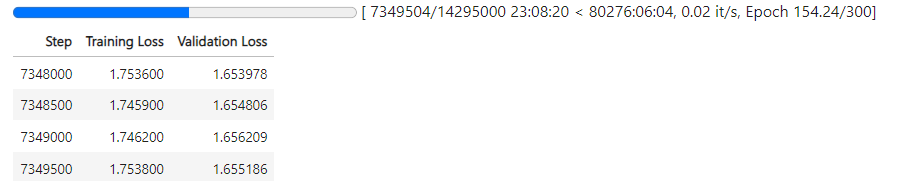

Türkçe heceleme yapısına uygun tokenizer kullanılmış ve model 7.5 milyon adımda yaklaşık 154 epoch eğitilmiştir.

|

| 79 |

+

Eğitim için 4GB hafızası olan Nvidia Geforce RTX 3050 GPU kullanılmaktadır. 16GB Paylaşılan GPU'dan da yararlanılmakta ve eğitimin devamında toplamda 20GB hafıza kullanılmaktadır.

|

| 80 |

+

|

| 81 |

+

## Model Nasıl Kullanılabilir

|

| 82 |

+

ÖNEMLİ: model harf büyüklüğüne duyarlı olduğu için, prompt tamamen küçük harflerle yazılmalıdır.

|

| 83 |

+

|

| 84 |

+

```python

|

| 85 |

+

# Model ile çıkarım yapmak için örnek kod

|

| 86 |

+

|

| 87 |

+

from transformers import GPT2Tokenizer, GPT2LMHeadModel

|

| 88 |

+

|

| 89 |

+

model_name = "cenkersisman/gpt2-turkish-128-token"

|

| 90 |

+

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

|

| 91 |

+

model = GPT2LMHeadModel.from_pretrained(model_name)

|

| 92 |

+

|

| 93 |

+

prompt = "okyanusun derinliklerinde bulunan"

|

| 94 |

+

input_ids = tokenizer.encode(prompt, return_tensors="pt")

|

| 95 |

+

output = model.generate(input_ids, max_length=100, pad_token_id=tokenizer.eos_token_id)

|

| 96 |

+

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

|

| 97 |

+

print(generated_text)

|

| 98 |

+

|

| 99 |

+

```

|

| 100 |

+

## Eğitim Süreci Eğrisi

|

| 101 |

+

|

| 102 |

+

|

| 103 |

+

|

| 104 |

+

|

| 105 |

+

## Sınırlamalar ve Önyargılar

|

| 106 |

+

Bu model, bir özyineli dil modeli olarak eğitildi. Bu, temel işlevinin bir metin dizisi alıp bir sonraki belirteci tahmin etmek olduğu anlamına gelir. Dil modelleri bunun dışında birçok görev için yaygın olarak kullanılsa da, bu çalışmayla ilgili birçok bilinmeyen bulunmaktadır.

|

| 107 |

+

|

| 108 |

+

Model, küfür, açık saçıklık ve aksi davranışlara yol açan metinleri içerdiği bilinen bir veri kümesi üzerinde eğitildi. Kullanım durumunuza bağlı olarak, bu model toplumsal olarak kabul edilemez metinler üretebilir.

|

| 109 |

+

|

| 110 |

+

Tüm dil modellerinde olduğu gibi, bu modelin belirli bir girişe nasıl yanıt vereceğini önceden tahmin etmek zordur ve uyarı olmaksızın saldırgan içerik ortaya çıkabilir. Sonuçları yayınlamadan önce hem istenmeyen içeriği sansürlemek hem de sonuçların kalitesini iyileştirmek için insanların çıktıları denetlemesini veya filtrelemesi önerilir.

|