Spaces:

Runtime error

Runtime error

Commit

·

983684c

1

Parent(s):

ff1b8c8

V1

Browse filesThis view is limited to 50 files because it contains too many changes.

See raw diff

- app.py +267 -0

- packages.txt +4 -0

- requirements.txt +7 -0

- vtoonify/LICENSE.md +12 -0

- vtoonify/data/077436.jpg +0 -0

- vtoonify/data/pexels-andrea-piacquadio-733872.jpg +0 -0

- vtoonify/model/__init__.py +0 -0

- vtoonify/model/bisenet/LICENSE +21 -0

- vtoonify/model/bisenet/README.md +68 -0

- vtoonify/model/bisenet/model.py +283 -0

- vtoonify/model/bisenet/resnet.py +109 -0

- vtoonify/model/dualstylegan.py +203 -0

- vtoonify/model/encoder/__init__.py +0 -0

- vtoonify/model/encoder/align_all_parallel.py +217 -0

- vtoonify/model/encoder/criteria/id_loss.py +33 -0

- vtoonify/model/encoder/encoders/__init__.py +0 -0

- vtoonify/model/encoder/encoders/helpers.py +119 -0

- vtoonify/model/encoder/encoders/model_irse.py +84 -0

- vtoonify/model/encoder/encoders/psp_encoders.py +186 -0

- vtoonify/model/encoder/psp.py +125 -0

- vtoonify/model/encoder/readme.md +9 -0

- vtoonify/model/raft/LICENSE +29 -0

- vtoonify/model/raft/RAFT.png +0 -0

- vtoonify/model/raft/README.md +80 -0

- vtoonify/model/raft/alt_cuda_corr/correlation.cpp +54 -0

- vtoonify/model/raft/alt_cuda_corr/correlation_kernel.cu +324 -0

- vtoonify/model/raft/alt_cuda_corr/setup.py +15 -0

- vtoonify/model/raft/chairs_split.txt +22872 -0

- vtoonify/model/raft/core/__init__.py +0 -0

- vtoonify/model/raft/core/corr.py +91 -0

- vtoonify/model/raft/core/datasets.py +235 -0

- vtoonify/model/raft/core/extractor.py +267 -0

- vtoonify/model/raft/core/raft.py +144 -0

- vtoonify/model/raft/core/update.py +139 -0

- vtoonify/model/raft/core/utils/__init__.py +0 -0

- vtoonify/model/raft/core/utils/augmentor.py +246 -0

- vtoonify/model/raft/core/utils/flow_viz.py +132 -0

- vtoonify/model/raft/core/utils/frame_utils.py +137 -0

- vtoonify/model/raft/core/utils/utils.py +82 -0

- vtoonify/model/raft/demo.py +75 -0

- vtoonify/model/raft/download_models.sh +3 -0

- vtoonify/model/raft/evaluate.py +197 -0

- vtoonify/model/raft/train.py +247 -0

- vtoonify/model/raft/train_mixed.sh +6 -0

- vtoonify/model/raft/train_standard.sh +6 -0

- vtoonify/model/simple_augment.py +468 -0

- vtoonify/model/stylegan/__init__.py +0 -0

- vtoonify/model/stylegan/dataset.py +40 -0

- vtoonify/model/stylegan/distributed.py +126 -0

- vtoonify/model/stylegan/lpips/__init__.py +161 -0

app.py

ADDED

|

@@ -0,0 +1,267 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

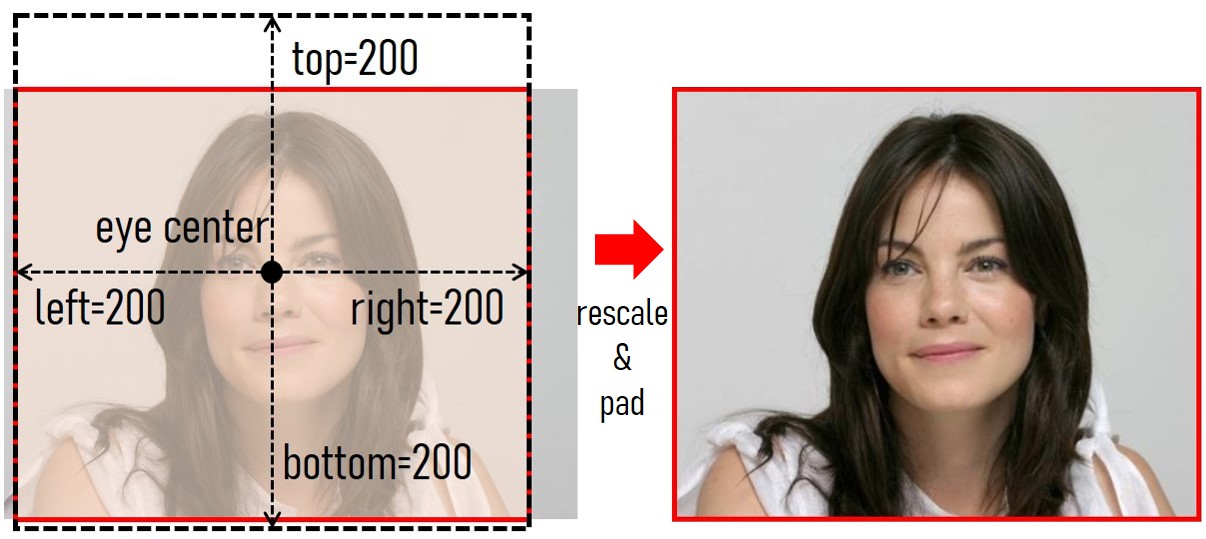

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

#!/usr/bin/env python

|

| 2 |

+

|

| 3 |

+

from __future__ import annotations

|

| 4 |

+

|

| 5 |

+

import argparse

|

| 6 |

+

import pathlib

|

| 7 |

+

|

| 8 |

+

import gradio as gr

|

| 9 |

+

|

| 10 |

+

from vtoonify_model import Model

|

| 11 |

+

|

| 12 |

+

DESCRIPTION = '''

|

| 13 |

+

<div align=center>

|

| 14 |

+

<h1 style="font-weight: 900; margin-bottom: 7px;">

|

| 15 |

+

Portrait Style Transfer with <a href="https://github.com/williamyang1991/VToonify">VToonify</a>

|

| 16 |

+

</h1>

|

| 17 |

+

<video id="video" width=50% controls="" preload="none" poster="https://repository-images.githubusercontent.com/534480768/53715b0f-a2df-4daa-969c-0e74c102d339">

|

| 18 |

+

<source id="mp4" src="https://user-images.githubusercontent.com/18130694/189483939-0fc4a358-fb34-43cc-811a-b22adb820d57.mp4

|

| 19 |

+

" type="video/mp4">

|

| 20 |

+

</videos></div>

|

| 21 |

+

'''

|

| 22 |

+

FOOTER = '<div align=center><img id="visitor-badge" alt="visitor badge" src="https://visitor-badge.glitch.me/badge?page_id=gradio-blocks.vtoonify" /></div>'

|

| 23 |

+

|

| 24 |

+

ARTICLE = r"""

|

| 25 |

+

If VToonify is helpful, please help to ⭐ the <a href='https://github.com/williamyang1991/VToonify' target='_blank'>Github Repo</a>. Thanks!

|

| 26 |

+

[](https://github.com/williamyang1991/VToonify)

|

| 27 |

+

---

|

| 28 |

+

📝 **Citation**

|

| 29 |

+

If our work is useful for your research, please consider citing:

|

| 30 |

+

```bibtex

|

| 31 |

+

@article{yang2022Vtoonify,

|

| 32 |

+

title={VToonify: Controllable High-Resolution Portrait Video Style Transfer},

|

| 33 |

+

author={Yang, Shuai and Jiang, Liming and Liu, Ziwei and Loy, Chen Change},

|

| 34 |

+

journal={ACM Transactions on Graphics (TOG)},

|

| 35 |

+

volume={41},

|

| 36 |

+

number={6},

|

| 37 |

+

articleno={203},

|

| 38 |

+

pages={1--15},

|

| 39 |

+

year={2022},

|

| 40 |

+

publisher={ACM New York, NY, USA},

|

| 41 |

+

doi={10.1145/3550454.3555437},

|

| 42 |

+

}

|

| 43 |

+

```

|

| 44 |

+

📋 **License**

|

| 45 |

+

This project is licensed under <a rel="license" href="https://github.com/williamyang1991/VToonify/blob/main/LICENSE.md">S-Lab License 1.0</a>.

|

| 46 |

+

Redistribution and use for non-commercial purposes should follow this license.

|

| 47 |

+

📧 **Contact**

|

| 48 |

+

If you have any questions, please feel free to reach me out at <b>williamyang@pku.edu.cn</b>.

|

| 49 |

+

"""

|

| 50 |

+

|

| 51 |

+

def update_slider(choice: str) -> dict:

|

| 52 |

+

if type(choice) == str and choice.endswith('-d'):

|

| 53 |

+

return gr.Slider.update(maximum=1, minimum=0, value=0.5)

|

| 54 |

+

else:

|

| 55 |

+

return gr.Slider.update(maximum=0.5, minimum=0.5, value=0.5)

|

| 56 |

+

|

| 57 |

+

def set_example_image(example: list) -> dict:

|

| 58 |

+

return gr.Image.update(value=example[0])

|

| 59 |

+

|

| 60 |

+

def set_example_video(example: list) -> dict:

|

| 61 |

+

return gr.Video.update(value=example[0]),

|

| 62 |

+

|

| 63 |

+

sample_video = ['./vtoonify/data/529.mp4', './vtoonify/data/pexels-anthony-shkraba-7525601.mp4']

|

| 64 |

+

sample_vid = gr.Video(label='Video file') #for displaying the example

|

| 65 |

+

example_videos = gr.components.Dataset(components=[sample_vid], samples=[[path] for path in sample_video], type='values', label='Video Examples')

|

| 66 |

+

|

| 67 |

+

def main():

|

| 68 |

+

args = parse_args()

|

| 69 |

+

model = Model(device=args.device)

|

| 70 |

+

|

| 71 |

+

with gr.Blocks(theme=args.theme, css='style.css') as demo:

|

| 72 |

+

|

| 73 |

+

gr.Markdown(DESCRIPTION)

|

| 74 |

+

|

| 75 |

+

with gr.Box():

|

| 76 |

+

gr.Markdown('''## Step 1(Select Style)

|

| 77 |

+

- Select **Style Type**.

|

| 78 |

+

- Types with `-d` means it supports style degree adjustment.

|

| 79 |

+

- Types without `-d` usually has better toonification quality.

|

| 80 |

+

|

| 81 |

+

''')

|

| 82 |

+

with gr.Row():

|

| 83 |

+

with gr.Column():

|

| 84 |

+

gr.Markdown('''Select Style Type''')

|

| 85 |

+

with gr.Row():

|

| 86 |

+

style_type = gr.Radio(label='Style Type',

|

| 87 |

+

choices=['cartoon1','cartoon1-d','cartoon2-d','cartoon3-d',

|

| 88 |

+

'cartoon4','cartoon4-d','cartoon5-d','comic1-d',

|

| 89 |

+

'comic2-d','comic3-d', 'arcane1','arcane1-d','arcane2', 'arcane2-d',

|

| 90 |

+

'caricature1','caricature2','pixar','pixar-d'

|

| 91 |

+

]

|

| 92 |

+

)

|

| 93 |

+

exstyle = gr.Variable()

|

| 94 |

+

with gr.Row():

|

| 95 |

+

loadmodel_button = gr.Button('Load Model')

|

| 96 |

+

with gr.Row():

|

| 97 |

+

load_info = gr.Textbox(label='Process Information', interactive=False, value='No model loaded.')

|

| 98 |

+

with gr.Column():

|

| 99 |

+

gr.Markdown('''Reference Styles

|

| 100 |

+

''')

|

| 101 |

+

|

| 102 |

+

|

| 103 |

+

with gr.Box():

|

| 104 |

+

gr.Markdown('''## Step 2 (Preprocess Input Image / Video)

|

| 105 |

+

- Drop an image/video containing a near-frontal face to the **Input Image**/**Input Video.

|

| 106 |

+

- If there are multiple faces, hit the Edit button in the upper right corner and crop the source beforehand.

|

| 107 |

+

- Hit the **Rescale Image**/ **Rescale First Frame** button.

|

| 108 |

+

- The final image result will be based on this **Rescaled Face**.

|

| 109 |

+

- Use padding parameters to adjust the background space.

|

| 110 |

+

- For video input, further hit the **Rescale Video** button.

|

| 111 |

+

- The final video result will be based on this **Rescaled Video**.

|

| 112 |

+

|

| 113 |

+

''')

|

| 114 |

+

with gr.Row():

|

| 115 |

+

with gr.Box():

|

| 116 |

+

with gr.Column():

|

| 117 |

+

gr.Markdown('''Choose the padding parameters.

|

| 118 |

+

''')

|

| 119 |

+

with gr.Row():

|

| 120 |

+

top = gr.Slider(128,

|

| 121 |

+

320,

|

| 122 |

+

value=200,

|

| 123 |

+

step=8,

|

| 124 |

+

label='top')

|

| 125 |

+

with gr.Row():

|

| 126 |

+

bottom = gr.Slider(128,

|

| 127 |

+

320,

|

| 128 |

+

value=200,

|

| 129 |

+

step=8,

|

| 130 |

+

label='bottom')

|

| 131 |

+

with gr.Row():

|

| 132 |

+

left = gr.Slider(128,

|

| 133 |

+

320,

|

| 134 |

+

value=200,

|

| 135 |

+

step=8,

|

| 136 |

+

label='left')

|

| 137 |

+

with gr.Row():

|

| 138 |

+

right = gr.Slider(128,

|

| 139 |

+

320,

|

| 140 |

+

value=200,

|

| 141 |

+

step=8,

|

| 142 |

+

label='right')

|

| 143 |

+

with gr.Box():

|

| 144 |

+

with gr.Column():

|

| 145 |

+

gr.Markdown('''Input''')

|

| 146 |

+

with gr.Row():

|

| 147 |

+

input_image = gr.Image(label='Input Image',

|

| 148 |

+

type='filepath')

|

| 149 |

+

with gr.Row():

|

| 150 |

+

preprocess_image_button = gr.Button('Rescale Image')

|

| 151 |

+

with gr.Row():

|

| 152 |

+

input_video = gr.Video(label='Input Video',

|

| 153 |

+

mirror_webcam=False,

|

| 154 |

+

type='filepath')

|

| 155 |

+

with gr.Row():

|

| 156 |

+

preprocess_video0_button = gr.Button('Rescale First Frame')

|

| 157 |

+

preprocess_video1_button = gr.Button('Rescale Video')

|

| 158 |

+

|

| 159 |

+

with gr.Box():

|

| 160 |

+

with gr.Column():

|

| 161 |

+

gr.Markdown('''View''')

|

| 162 |

+

with gr.Row():

|

| 163 |

+

input_info = gr.Textbox(label='Process Information', interactive=False, value='n.a.')

|

| 164 |

+

with gr.Row():

|

| 165 |

+

aligned_face = gr.Image(label='Rescaled Face',

|

| 166 |

+

type='numpy',

|

| 167 |

+

interactive=False)

|

| 168 |

+

instyle = gr.Variable()

|

| 169 |

+

with gr.Row():

|

| 170 |

+

aligned_video = gr.Video(label='Rescaled Video',

|

| 171 |

+

type='mp4',

|

| 172 |

+

interactive=False)

|

| 173 |

+

with gr.Row():

|

| 174 |

+

with gr.Column():

|

| 175 |

+

paths = ['./vtoonify/data/077436.jpg', './vtoonify/data/pexels-andrea-piacquadio-733872.jpg']

|

| 176 |

+

example_images = gr.Dataset(components=[input_image],

|

| 177 |

+

samples=[[path] for path in paths],

|

| 178 |

+

label='Image Examples')

|

| 179 |

+

with gr.Column():

|

| 180 |

+

#example_videos = gr.Dataset(components=[input_video], samples=[['./vtoonify/data/529.mp4']], type='values')

|

| 181 |

+

#to render video example on mouse hover/click

|

| 182 |

+

example_videos.render()

|

| 183 |

+

#to load sample video into input_video upon clicking on it

|

| 184 |

+

def load_examples(video):

|

| 185 |

+

print("****** inside load_example() ******")

|

| 186 |

+

print("in_video is : ", video[0])

|

| 187 |

+

return video[0]

|

| 188 |

+

|

| 189 |

+

example_videos.click(load_examples, example_videos, input_video)

|

| 190 |

+

|

| 191 |

+

with gr.Box():

|

| 192 |

+

gr.Markdown('''## Step 3 (Generate Style Transferred Image/Video)''')

|

| 193 |

+

with gr.Row():

|

| 194 |

+

with gr.Column():

|

| 195 |

+

gr.Markdown('''

|

| 196 |

+

|

| 197 |

+

- Adjust **Style Degree**.

|

| 198 |

+

- For image, hit **Toonify!** to toonify **Rescaled Face**.

|

| 199 |

+

- For video, hit e **VToonify!** to toonify **Rescaled Video**.

|

| 200 |

+

''')

|

| 201 |

+

style_degree = gr.Slider(0,

|

| 202 |

+

1,

|

| 203 |

+

value=0.5,

|

| 204 |

+

step=0.05,

|

| 205 |

+

label='Style Degree')

|

| 206 |

+

with gr.Column():

|

| 207 |

+

gr.Markdown('''

|

| 208 |

+

''')

|

| 209 |

+

with gr.Row():

|

| 210 |

+

with gr.Column():

|

| 211 |

+

with gr.Row():

|

| 212 |

+

result_face = gr.Image(label='Result Image',

|

| 213 |

+

type='numpy',

|

| 214 |

+

interactive=False)

|

| 215 |

+

with gr.Row():

|

| 216 |

+

toonify_button = gr.Button('Toonify!')

|

| 217 |

+

with gr.Column():

|

| 218 |

+

with gr.Row():

|

| 219 |

+

result_video = gr.Video(label='Result Video',

|

| 220 |

+

type='mp4',

|

| 221 |

+

interactive=False)

|

| 222 |

+

with gr.Row():

|

| 223 |

+

vtoonify_button = gr.Button('VToonify!')

|

| 224 |

+

|

| 225 |

+

gr.Markdown(ARTICLE)

|

| 226 |

+

gr.Markdown(FOOTER)

|

| 227 |

+

|

| 228 |

+

loadmodel_button.click(fn=model.load_model,

|

| 229 |

+

inputs=[style_type],

|

| 230 |

+

outputs=[exstyle, load_info])

|

| 231 |

+

|

| 232 |

+

|

| 233 |

+

style_type.change(fn=update_slider,

|

| 234 |

+

inputs=style_type,

|

| 235 |

+

outputs=style_degree)

|

| 236 |

+

|

| 237 |

+

preprocess_image_button.click(fn=model.detect_and_align_image,

|

| 238 |

+

inputs=[input_image, top, bottom, left, right],

|

| 239 |

+

outputs=[aligned_face, instyle, input_info])

|

| 240 |

+

preprocess_video0_button.click(fn=model.detect_and_align_video,

|

| 241 |

+

inputs=[input_video, top, bottom, left, right],

|

| 242 |

+

outputs=[aligned_face, instyle, input_info])

|

| 243 |

+

preprocess_video1_button.click(fn=model.detect_and_align_full_video,

|

| 244 |

+

inputs=[input_video, top, bottom, left, right],

|

| 245 |

+

outputs=[aligned_video, instyle, input_info])

|

| 246 |

+

|

| 247 |

+

toonify_button.click(fn=model.image_toonify,

|

| 248 |

+

inputs=[aligned_face, instyle, exstyle, style_degree],

|

| 249 |

+

outputs=[result_face])

|

| 250 |

+

vtoonify_button.click(fn=model.video_tooniy,

|

| 251 |

+

inputs=[aligned_video, instyle, exstyle, style_degree],

|

| 252 |

+

outputs=[result_video])

|

| 253 |

+

|

| 254 |

+

|

| 255 |

+

example_images.click(fn=set_example_image,

|

| 256 |

+

inputs=example_images,

|

| 257 |

+

outputs=example_images.components)

|

| 258 |

+

|

| 259 |

+

demo.launch(

|

| 260 |

+

enable_queue=args.enable_queue,

|

| 261 |

+

server_port=args.port,

|

| 262 |

+

share=args.share,

|

| 263 |

+

)

|

| 264 |

+

|

| 265 |

+

|

| 266 |

+

if __name__ == '__main__':

|

| 267 |

+

main()

|

packages.txt

ADDED

|

@@ -0,0 +1,4 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

bzip2

|

| 2 |

+

cmake

|

| 3 |

+

ninja-build

|

| 4 |

+

|

requirements.txt

ADDED

|

@@ -0,0 +1,7 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

dlib==19.23.0

|

| 2 |

+

numpy==1.22.3

|

| 3 |

+

opencv-python-headless==4.5.5.62

|

| 4 |

+

Pillow==9.0.1

|

| 5 |

+

scipy==1.8.0

|

| 6 |

+

torch==1.11.0

|

| 7 |

+

torchvision==0.12.0

|

vtoonify/LICENSE.md

ADDED

|

@@ -0,0 +1,12 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

# S-Lab License 1.0

|

| 2 |

+

|

| 3 |

+

Copyright 2022 S-Lab

|

| 4 |

+

|

| 5 |

+

Redistribution and use for non-commercial purpose in source and binary forms, with or without modification, are permitted provided that the following conditions are met:

|

| 6 |

+

1. Redistributions of source code must retain the above copyright notice, this list of conditions and the following disclaimer.

|

| 7 |

+

2. Redistributions in binary form must reproduce the above copyright notice, this list of conditions and the following disclaimer in the documentation and/or other materials provided with the distribution.

|

| 8 |

+

3. Neither the name of the copyright holder nor the names of its contributors may be used to endorse or promote products derived from this software without specific prior written permission.\

|

| 9 |

+

THIS SOFTWARE IS PROVIDED BY THE COPYRIGHT HOLDERS AND CONTRIBUTORS "AS IS" AND ANY EXPRESS OR IMPLIED WARRANTIES, INCLUDING, BUT NOT LIMITED TO, THE IMPLIED WARRANTIES OF MERCHANTABILITY AND FITNESS FOR A PARTICULAR PURPOSE ARE DISCLAIMED. IN NO EVENT SHALL THE COPYRIGHT HOLDER OR CONTRIBUTORS BE LIABLE FOR ANY DIRECT, INDIRECT, INCIDENTAL, SPECIAL, EXEMPLARY, OR CONSEQUENTIAL DAMAGES (INCLUDING, BUT NOT LIMITED TO, PROCUREMENT OF SUBSTITUTE GOODS OR SERVICES; LOSS OF USE, DATA, OR PROFITS; OR BUSINESS INTERRUPTION) HOWEVER CAUSED AND ON ANY THEORY OF LIABILITY, WHETHER IN CONTRACT, STRICT LIABILITY, OR TORT (INCLUDING NEGLIGENCE OR OTHERWISE) ARISING IN ANY WAY OUT OF THE USE OF THIS SOFTWARE, EVEN IF ADVISED OF THE POSSIBILITY OF SUCH DAMAGE.

|

| 10 |

+

4. In the event that redistribution and/or use for commercial purpose in source or binary forms, with or without modification is required, please contact the contributor(s) of the work.

|

| 11 |

+

|

| 12 |

+

|

vtoonify/data/077436.jpg

ADDED

|

vtoonify/data/pexels-andrea-piacquadio-733872.jpg

ADDED

|

vtoonify/model/__init__.py

ADDED

|

File without changes

|

vtoonify/model/bisenet/LICENSE

ADDED

|

@@ -0,0 +1,21 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

MIT License

|

| 2 |

+

|

| 3 |

+

Copyright (c) 2019 zll

|

| 4 |

+

|

| 5 |

+

Permission is hereby granted, free of charge, to any person obtaining a copy

|

| 6 |

+

of this software and associated documentation files (the "Software"), to deal

|

| 7 |

+

in the Software without restriction, including without limitation the rights

|

| 8 |

+

to use, copy, modify, merge, publish, distribute, sublicense, and/or sell

|

| 9 |

+

copies of the Software, and to permit persons to whom the Software is

|

| 10 |

+

furnished to do so, subject to the following conditions:

|

| 11 |

+

|

| 12 |

+

The above copyright notice and this permission notice shall be included in all

|

| 13 |

+

copies or substantial portions of the Software.

|

| 14 |

+

|

| 15 |

+

THE SOFTWARE IS PROVIDED "AS IS", WITHOUT WARRANTY OF ANY KIND, EXPRESS OR

|

| 16 |

+

IMPLIED, INCLUDING BUT NOT LIMITED TO THE WARRANTIES OF MERCHANTABILITY,

|

| 17 |

+

FITNESS FOR A PARTICULAR PURPOSE AND NONINFRINGEMENT. IN NO EVENT SHALL THE

|

| 18 |

+

AUTHORS OR COPYRIGHT HOLDERS BE LIABLE FOR ANY CLAIM, DAMAGES OR OTHER

|

| 19 |

+

LIABILITY, WHETHER IN AN ACTION OF CONTRACT, TORT OR OTHERWISE, ARISING FROM,

|

| 20 |

+

OUT OF OR IN CONNECTION WITH THE SOFTWARE OR THE USE OR OTHER DEALINGS IN THE

|

| 21 |

+

SOFTWARE.

|

vtoonify/model/bisenet/README.md

ADDED

|

@@ -0,0 +1,68 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

# face-parsing.PyTorch

|

| 2 |

+

|

| 3 |

+

<p align="center">

|

| 4 |

+

<a href="https://github.com/zllrunning/face-parsing.PyTorch">

|

| 5 |

+

<img class="page-image" src="https://github.com/zllrunning/face-parsing.PyTorch/blob/master/6.jpg" >

|

| 6 |

+

</a>

|

| 7 |

+

</p>

|

| 8 |

+

|

| 9 |

+

### Contents

|

| 10 |

+

- [Training](#training)

|

| 11 |

+

- [Demo](#Demo)

|

| 12 |

+

- [References](#references)

|

| 13 |

+

|

| 14 |

+

## Training

|

| 15 |

+

|

| 16 |

+

1. Prepare training data:

|

| 17 |

+

-- download [CelebAMask-HQ dataset](https://github.com/switchablenorms/CelebAMask-HQ)

|

| 18 |

+

|

| 19 |

+

-- change file path in the `prepropess_data.py` and run

|

| 20 |

+

```Shell

|

| 21 |

+

python prepropess_data.py

|

| 22 |

+

```

|

| 23 |

+

|

| 24 |

+

2. Train the model using CelebAMask-HQ dataset:

|

| 25 |

+

Just run the train script:

|

| 26 |

+

```

|

| 27 |

+

$ CUDA_VISIBLE_DEVICES=0,1 python -m torch.distributed.launch --nproc_per_node=2 train.py

|

| 28 |

+

```

|

| 29 |

+

|

| 30 |

+

If you do not wish to train the model, you can download [our pre-trained model](https://drive.google.com/open?id=154JgKpzCPW82qINcVieuPH3fZ2e0P812) and save it in `res/cp`.

|

| 31 |

+

|

| 32 |

+

|

| 33 |

+

## Demo

|

| 34 |

+

1. Evaluate the trained model using:

|

| 35 |

+

```Shell

|

| 36 |

+

# evaluate using GPU

|

| 37 |

+

python test.py

|

| 38 |

+

```

|

| 39 |

+

|

| 40 |

+

## Face makeup using parsing maps

|

| 41 |

+

[**face-makeup.PyTorch**](https://github.com/zllrunning/face-makeup.PyTorch)

|

| 42 |

+

<table>

|

| 43 |

+

|

| 44 |

+

<tr>

|

| 45 |

+

<th> </th>

|

| 46 |

+

<th>Hair</th>

|

| 47 |

+

<th>Lip</th>

|

| 48 |

+

</tr>

|

| 49 |

+

|

| 50 |

+

<!-- Line 1: Original Input -->

|

| 51 |

+

<tr>

|

| 52 |

+

<td><em>Original Input</em></td>

|

| 53 |

+

<td><img src="makeup/116_ori.png" height="256" width="256" alt="Original Input"></td>

|

| 54 |

+

<td><img src="makeup/116_lip_ori.png" height="256" width="256" alt="Original Input"></td>

|

| 55 |

+

</tr>

|

| 56 |

+

|

| 57 |

+

<!-- Line 3: Color -->

|

| 58 |

+

<tr>

|

| 59 |

+

<td>Color</td>

|

| 60 |

+

<td><img src="makeup/116_1.png" height="256" width="256" alt="Color"></td>

|

| 61 |

+

<td><img src="makeup/116_3.png" height="256" width="256" alt="Color"></td>

|

| 62 |

+

</tr>

|

| 63 |

+

|

| 64 |

+

</table>

|

| 65 |

+

|

| 66 |

+

|

| 67 |

+

## References

|

| 68 |

+

- [BiSeNet](https://github.com/CoinCheung/BiSeNet)

|

vtoonify/model/bisenet/model.py

ADDED

|

@@ -0,0 +1,283 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

#!/usr/bin/python

|

| 2 |

+

# -*- encoding: utf-8 -*-

|

| 3 |

+

|

| 4 |

+

|

| 5 |

+

import torch

|

| 6 |

+

import torch.nn as nn

|

| 7 |

+

import torch.nn.functional as F

|

| 8 |

+

import torchvision

|

| 9 |

+

|

| 10 |

+

from model.bisenet.resnet import Resnet18

|

| 11 |

+

# from modules.bn import InPlaceABNSync as BatchNorm2d

|

| 12 |

+

|

| 13 |

+

|

| 14 |

+

class ConvBNReLU(nn.Module):

|

| 15 |

+

def __init__(self, in_chan, out_chan, ks=3, stride=1, padding=1, *args, **kwargs):

|

| 16 |

+

super(ConvBNReLU, self).__init__()

|

| 17 |

+

self.conv = nn.Conv2d(in_chan,

|

| 18 |

+

out_chan,

|

| 19 |

+

kernel_size = ks,

|

| 20 |

+

stride = stride,

|

| 21 |

+

padding = padding,

|

| 22 |

+

bias = False)

|

| 23 |

+

self.bn = nn.BatchNorm2d(out_chan)

|

| 24 |

+

self.init_weight()

|

| 25 |

+

|

| 26 |

+

def forward(self, x):

|

| 27 |

+

x = self.conv(x)

|

| 28 |

+

x = F.relu(self.bn(x))

|

| 29 |

+

return x

|

| 30 |

+

|

| 31 |

+

def init_weight(self):

|

| 32 |

+

for ly in self.children():

|

| 33 |

+

if isinstance(ly, nn.Conv2d):

|

| 34 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 35 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 36 |

+

|

| 37 |

+

class BiSeNetOutput(nn.Module):

|

| 38 |

+

def __init__(self, in_chan, mid_chan, n_classes, *args, **kwargs):

|

| 39 |

+

super(BiSeNetOutput, self).__init__()

|

| 40 |

+

self.conv = ConvBNReLU(in_chan, mid_chan, ks=3, stride=1, padding=1)

|

| 41 |

+

self.conv_out = nn.Conv2d(mid_chan, n_classes, kernel_size=1, bias=False)

|

| 42 |

+

self.init_weight()

|

| 43 |

+

|

| 44 |

+

def forward(self, x):

|

| 45 |

+

x = self.conv(x)

|

| 46 |

+

x = self.conv_out(x)

|

| 47 |

+

return x

|

| 48 |

+

|

| 49 |

+

def init_weight(self):

|

| 50 |

+

for ly in self.children():

|

| 51 |

+

if isinstance(ly, nn.Conv2d):

|

| 52 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 53 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 54 |

+

|

| 55 |

+

def get_params(self):

|

| 56 |

+

wd_params, nowd_params = [], []

|

| 57 |

+

for name, module in self.named_modules():

|

| 58 |

+

if isinstance(module, nn.Linear) or isinstance(module, nn.Conv2d):

|

| 59 |

+

wd_params.append(module.weight)

|

| 60 |

+

if not module.bias is None:

|

| 61 |

+

nowd_params.append(module.bias)

|

| 62 |

+

elif isinstance(module, nn.BatchNorm2d):

|

| 63 |

+

nowd_params += list(module.parameters())

|

| 64 |

+

return wd_params, nowd_params

|

| 65 |

+

|

| 66 |

+

|

| 67 |

+

class AttentionRefinementModule(nn.Module):

|

| 68 |

+

def __init__(self, in_chan, out_chan, *args, **kwargs):

|

| 69 |

+

super(AttentionRefinementModule, self).__init__()

|

| 70 |

+

self.conv = ConvBNReLU(in_chan, out_chan, ks=3, stride=1, padding=1)

|

| 71 |

+

self.conv_atten = nn.Conv2d(out_chan, out_chan, kernel_size= 1, bias=False)

|

| 72 |

+

self.bn_atten = nn.BatchNorm2d(out_chan)

|

| 73 |

+

self.sigmoid_atten = nn.Sigmoid()

|

| 74 |

+

self.init_weight()

|

| 75 |

+

|

| 76 |

+

def forward(self, x):

|

| 77 |

+

feat = self.conv(x)

|

| 78 |

+

atten = F.avg_pool2d(feat, feat.size()[2:])

|

| 79 |

+

atten = self.conv_atten(atten)

|

| 80 |

+

atten = self.bn_atten(atten)

|

| 81 |

+

atten = self.sigmoid_atten(atten)

|

| 82 |

+

out = torch.mul(feat, atten)

|

| 83 |

+

return out

|

| 84 |

+

|

| 85 |

+

def init_weight(self):

|

| 86 |

+

for ly in self.children():

|

| 87 |

+

if isinstance(ly, nn.Conv2d):

|

| 88 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 89 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 90 |

+

|

| 91 |

+

|

| 92 |

+

class ContextPath(nn.Module):

|

| 93 |

+

def __init__(self, *args, **kwargs):

|

| 94 |

+

super(ContextPath, self).__init__()

|

| 95 |

+

self.resnet = Resnet18()

|

| 96 |

+

self.arm16 = AttentionRefinementModule(256, 128)

|

| 97 |

+

self.arm32 = AttentionRefinementModule(512, 128)

|

| 98 |

+

self.conv_head32 = ConvBNReLU(128, 128, ks=3, stride=1, padding=1)

|

| 99 |

+

self.conv_head16 = ConvBNReLU(128, 128, ks=3, stride=1, padding=1)

|

| 100 |

+

self.conv_avg = ConvBNReLU(512, 128, ks=1, stride=1, padding=0)

|

| 101 |

+

|

| 102 |

+

self.init_weight()

|

| 103 |

+

|

| 104 |

+

def forward(self, x):

|

| 105 |

+

H0, W0 = x.size()[2:]

|

| 106 |

+

feat8, feat16, feat32 = self.resnet(x)

|

| 107 |

+

H8, W8 = feat8.size()[2:]

|

| 108 |

+

H16, W16 = feat16.size()[2:]

|

| 109 |

+

H32, W32 = feat32.size()[2:]

|

| 110 |

+

|

| 111 |

+

avg = F.avg_pool2d(feat32, feat32.size()[2:])

|

| 112 |

+

avg = self.conv_avg(avg)

|

| 113 |

+

avg_up = F.interpolate(avg, (H32, W32), mode='nearest')

|

| 114 |

+

|

| 115 |

+

feat32_arm = self.arm32(feat32)

|

| 116 |

+

feat32_sum = feat32_arm + avg_up

|

| 117 |

+

feat32_up = F.interpolate(feat32_sum, (H16, W16), mode='nearest')

|

| 118 |

+

feat32_up = self.conv_head32(feat32_up)

|

| 119 |

+

|

| 120 |

+

feat16_arm = self.arm16(feat16)

|

| 121 |

+

feat16_sum = feat16_arm + feat32_up

|

| 122 |

+

feat16_up = F.interpolate(feat16_sum, (H8, W8), mode='nearest')

|

| 123 |

+

feat16_up = self.conv_head16(feat16_up)

|

| 124 |

+

|

| 125 |

+

return feat8, feat16_up, feat32_up # x8, x8, x16

|

| 126 |

+

|

| 127 |

+

def init_weight(self):

|

| 128 |

+

for ly in self.children():

|

| 129 |

+

if isinstance(ly, nn.Conv2d):

|

| 130 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 131 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 132 |

+

|

| 133 |

+

def get_params(self):

|

| 134 |

+

wd_params, nowd_params = [], []

|

| 135 |

+

for name, module in self.named_modules():

|

| 136 |

+

if isinstance(module, (nn.Linear, nn.Conv2d)):

|

| 137 |

+

wd_params.append(module.weight)

|

| 138 |

+

if not module.bias is None:

|

| 139 |

+

nowd_params.append(module.bias)

|

| 140 |

+

elif isinstance(module, nn.BatchNorm2d):

|

| 141 |

+

nowd_params += list(module.parameters())

|

| 142 |

+

return wd_params, nowd_params

|

| 143 |

+

|

| 144 |

+

|

| 145 |

+

### This is not used, since I replace this with the resnet feature with the same size

|

| 146 |

+

class SpatialPath(nn.Module):

|

| 147 |

+

def __init__(self, *args, **kwargs):

|

| 148 |

+

super(SpatialPath, self).__init__()

|

| 149 |

+

self.conv1 = ConvBNReLU(3, 64, ks=7, stride=2, padding=3)

|

| 150 |

+

self.conv2 = ConvBNReLU(64, 64, ks=3, stride=2, padding=1)

|

| 151 |

+

self.conv3 = ConvBNReLU(64, 64, ks=3, stride=2, padding=1)

|

| 152 |

+

self.conv_out = ConvBNReLU(64, 128, ks=1, stride=1, padding=0)

|

| 153 |

+

self.init_weight()

|

| 154 |

+

|

| 155 |

+

def forward(self, x):

|

| 156 |

+

feat = self.conv1(x)

|

| 157 |

+

feat = self.conv2(feat)

|

| 158 |

+

feat = self.conv3(feat)

|

| 159 |

+

feat = self.conv_out(feat)

|

| 160 |

+

return feat

|

| 161 |

+

|

| 162 |

+

def init_weight(self):

|

| 163 |

+

for ly in self.children():

|

| 164 |

+

if isinstance(ly, nn.Conv2d):

|

| 165 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 166 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 167 |

+

|

| 168 |

+

def get_params(self):

|

| 169 |

+

wd_params, nowd_params = [], []

|

| 170 |

+

for name, module in self.named_modules():

|

| 171 |

+

if isinstance(module, nn.Linear) or isinstance(module, nn.Conv2d):

|

| 172 |

+

wd_params.append(module.weight)

|

| 173 |

+

if not module.bias is None:

|

| 174 |

+

nowd_params.append(module.bias)

|

| 175 |

+

elif isinstance(module, nn.BatchNorm2d):

|

| 176 |

+

nowd_params += list(module.parameters())

|

| 177 |

+

return wd_params, nowd_params

|

| 178 |

+

|

| 179 |

+

|

| 180 |

+

class FeatureFusionModule(nn.Module):

|

| 181 |

+

def __init__(self, in_chan, out_chan, *args, **kwargs):

|

| 182 |

+

super(FeatureFusionModule, self).__init__()

|

| 183 |

+

self.convblk = ConvBNReLU(in_chan, out_chan, ks=1, stride=1, padding=0)

|

| 184 |

+

self.conv1 = nn.Conv2d(out_chan,

|

| 185 |

+

out_chan//4,

|

| 186 |

+

kernel_size = 1,

|

| 187 |

+

stride = 1,

|

| 188 |

+

padding = 0,

|

| 189 |

+

bias = False)

|

| 190 |

+

self.conv2 = nn.Conv2d(out_chan//4,

|

| 191 |

+

out_chan,

|

| 192 |

+

kernel_size = 1,

|

| 193 |

+

stride = 1,

|

| 194 |

+

padding = 0,

|

| 195 |

+

bias = False)

|

| 196 |

+

self.relu = nn.ReLU(inplace=True)

|

| 197 |

+

self.sigmoid = nn.Sigmoid()

|

| 198 |

+

self.init_weight()

|

| 199 |

+

|

| 200 |

+

def forward(self, fsp, fcp):

|

| 201 |

+

fcat = torch.cat([fsp, fcp], dim=1)

|

| 202 |

+

feat = self.convblk(fcat)

|

| 203 |

+

atten = F.avg_pool2d(feat, feat.size()[2:])

|

| 204 |

+

atten = self.conv1(atten)

|

| 205 |

+

atten = self.relu(atten)

|

| 206 |

+

atten = self.conv2(atten)

|

| 207 |

+

atten = self.sigmoid(atten)

|

| 208 |

+

feat_atten = torch.mul(feat, atten)

|

| 209 |

+

feat_out = feat_atten + feat

|

| 210 |

+

return feat_out

|

| 211 |

+

|

| 212 |

+

def init_weight(self):

|

| 213 |

+

for ly in self.children():

|

| 214 |

+

if isinstance(ly, nn.Conv2d):

|

| 215 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 216 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 217 |

+

|

| 218 |

+

def get_params(self):

|

| 219 |

+

wd_params, nowd_params = [], []

|

| 220 |

+

for name, module in self.named_modules():

|

| 221 |

+

if isinstance(module, nn.Linear) or isinstance(module, nn.Conv2d):

|

| 222 |

+

wd_params.append(module.weight)

|

| 223 |

+

if not module.bias is None:

|

| 224 |

+

nowd_params.append(module.bias)

|

| 225 |

+

elif isinstance(module, nn.BatchNorm2d):

|

| 226 |

+

nowd_params += list(module.parameters())

|

| 227 |

+

return wd_params, nowd_params

|

| 228 |

+

|

| 229 |

+

|

| 230 |

+

class BiSeNet(nn.Module):

|

| 231 |

+

def __init__(self, n_classes, *args, **kwargs):

|

| 232 |

+

super(BiSeNet, self).__init__()

|

| 233 |

+

self.cp = ContextPath()

|

| 234 |

+

## here self.sp is deleted

|

| 235 |

+

self.ffm = FeatureFusionModule(256, 256)

|

| 236 |

+

self.conv_out = BiSeNetOutput(256, 256, n_classes)

|

| 237 |

+

self.conv_out16 = BiSeNetOutput(128, 64, n_classes)

|

| 238 |

+

self.conv_out32 = BiSeNetOutput(128, 64, n_classes)

|

| 239 |

+

self.init_weight()

|

| 240 |

+

|

| 241 |

+

def forward(self, x):

|

| 242 |

+

H, W = x.size()[2:]

|

| 243 |

+

feat_res8, feat_cp8, feat_cp16 = self.cp(x) # here return res3b1 feature

|

| 244 |

+

feat_sp = feat_res8 # use res3b1 feature to replace spatial path feature

|

| 245 |

+

feat_fuse = self.ffm(feat_sp, feat_cp8)

|

| 246 |

+

|

| 247 |

+

feat_out = self.conv_out(feat_fuse)

|

| 248 |

+

feat_out16 = self.conv_out16(feat_cp8)

|

| 249 |

+

feat_out32 = self.conv_out32(feat_cp16)

|

| 250 |

+

|

| 251 |

+

feat_out = F.interpolate(feat_out, (H, W), mode='bilinear', align_corners=True)

|

| 252 |

+

feat_out16 = F.interpolate(feat_out16, (H, W), mode='bilinear', align_corners=True)

|

| 253 |

+

feat_out32 = F.interpolate(feat_out32, (H, W), mode='bilinear', align_corners=True)

|

| 254 |

+

return feat_out, feat_out16, feat_out32

|

| 255 |

+

|

| 256 |

+

def init_weight(self):

|

| 257 |

+

for ly in self.children():

|

| 258 |

+

if isinstance(ly, nn.Conv2d):

|

| 259 |

+

nn.init.kaiming_normal_(ly.weight, a=1)

|

| 260 |

+

if not ly.bias is None: nn.init.constant_(ly.bias, 0)

|

| 261 |

+

|

| 262 |

+

def get_params(self):

|

| 263 |

+

wd_params, nowd_params, lr_mul_wd_params, lr_mul_nowd_params = [], [], [], []

|

| 264 |

+

for name, child in self.named_children():

|

| 265 |

+

child_wd_params, child_nowd_params = child.get_params()

|

| 266 |

+

if isinstance(child, FeatureFusionModule) or isinstance(child, BiSeNetOutput):

|

| 267 |

+

lr_mul_wd_params += child_wd_params

|

| 268 |

+

lr_mul_nowd_params += child_nowd_params

|

| 269 |

+

else:

|

| 270 |

+

wd_params += child_wd_params

|

| 271 |

+

nowd_params += child_nowd_params

|

| 272 |

+

return wd_params, nowd_params, lr_mul_wd_params, lr_mul_nowd_params

|

| 273 |

+

|

| 274 |

+

|

| 275 |

+

if __name__ == "__main__":

|

| 276 |

+

net = BiSeNet(19)

|

| 277 |

+

net.cuda()

|

| 278 |

+

net.eval()

|

| 279 |

+

in_ten = torch.randn(16, 3, 640, 480).cuda()

|

| 280 |

+

out, out16, out32 = net(in_ten)

|

| 281 |

+

print(out.shape)

|

| 282 |

+

|

| 283 |

+

net.get_params()

|

vtoonify/model/bisenet/resnet.py

ADDED

|

@@ -0,0 +1,109 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 1 |

+

#!/usr/bin/python

|

| 2 |

+

# -*- encoding: utf-8 -*-

|

| 3 |

+

|

| 4 |

+

import torch

|

| 5 |

+

import torch.nn as nn

|

| 6 |

+

import torch.nn.functional as F

|

| 7 |

+

import torch.utils.model_zoo as modelzoo

|

| 8 |

+

|

| 9 |

+

# from modules.bn import InPlaceABNSync as BatchNorm2d

|

| 10 |

+

|

| 11 |

+

resnet18_url = 'https://download.pytorch.org/models/resnet18-5c106cde.pth'

|

| 12 |

+

|

| 13 |

+

|

| 14 |

+

def conv3x3(in_planes, out_planes, stride=1):

|

| 15 |

+

"""3x3 convolution with padding"""

|

| 16 |

+

return nn.Conv2d(in_planes, out_planes, kernel_size=3, stride=stride,

|

| 17 |

+

padding=1, bias=False)

|

| 18 |

+

|

| 19 |

+

|

| 20 |

+

class BasicBlock(nn.Module):

|

| 21 |

+

def __init__(self, in_chan, out_chan, stride=1):

|

| 22 |

+

super(BasicBlock, self).__init__()

|

| 23 |

+

self.conv1 = conv3x3(in_chan, out_chan, stride)

|

| 24 |

+

self.bn1 = nn.BatchNorm2d(out_chan)

|

| 25 |

+

self.conv2 = conv3x3(out_chan, out_chan)

|

| 26 |

+

self.bn2 = nn.BatchNorm2d(out_chan)

|

| 27 |

+

self.relu = nn.ReLU(inplace=True)

|

| 28 |

+

self.downsample = None

|

| 29 |

+

if in_chan != out_chan or stride != 1:

|

| 30 |

+

self.downsample = nn.Sequential(

|

| 31 |

+

nn.Conv2d(in_chan, out_chan,

|

| 32 |

+

kernel_size=1, stride=stride, bias=False),

|

| 33 |

+

nn.BatchNorm2d(out_chan),

|

| 34 |

+

)

|

| 35 |

+

|

| 36 |

+

def forward(self, x):

|

| 37 |

+

residual = self.conv1(x)

|

| 38 |

+

residual = F.relu(self.bn1(residual))

|

| 39 |

+

residual = self.conv2(residual)

|

| 40 |

+

residual = self.bn2(residual)

|

| 41 |

+

|

| 42 |

+

shortcut = x

|

| 43 |

+

if self.downsample is not None:

|

| 44 |

+

shortcut = self.downsample(x)

|

| 45 |

+

|

| 46 |

+

out = shortcut + residual

|

| 47 |

+

out = self.relu(out)

|

| 48 |

+

return out

|

| 49 |

+

|

| 50 |

+

|

| 51 |

+

def create_layer_basic(in_chan, out_chan, bnum, stride=1):

|

| 52 |

+

layers = [BasicBlock(in_chan, out_chan, stride=stride)]

|

| 53 |

+

for i in range(bnum-1):

|

| 54 |

+

layers.append(BasicBlock(out_chan, out_chan, stride=1))

|

| 55 |

+

return nn.Sequential(*layers)

|

| 56 |

+

|

| 57 |

+

|

| 58 |

+

class Resnet18(nn.Module):

|

| 59 |

+

def __init__(self):

|

| 60 |

+

super(Resnet18, self).__init__()

|

| 61 |

+

self.conv1 = nn.Conv2d(3, 64, kernel_size=7, stride=2, padding=3,

|

| 62 |

+

bias=False)

|

| 63 |

+

self.bn1 = nn.BatchNorm2d(64)

|

| 64 |

+

self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

|

| 65 |

+

self.layer1 = create_layer_basic(64, 64, bnum=2, stride=1)

|

| 66 |

+

self.layer2 = create_layer_basic(64, 128, bnum=2, stride=2)

|

| 67 |

+

self.layer3 = create_layer_basic(128, 256, bnum=2, stride=2)

|

| 68 |

+

self.layer4 = create_layer_basic(256, 512, bnum=2, stride=2)

|

| 69 |

+

self.init_weight()

|

| 70 |

+

|

| 71 |

+

def forward(self, x):

|

| 72 |

+

x = self.conv1(x)

|

| 73 |

+

x = F.relu(self.bn1(x))

|

| 74 |

+

x = self.maxpool(x)

|

| 75 |

+

|

| 76 |

+

x = self.layer1(x)

|

| 77 |

+

feat8 = self.layer2(x) # 1/8

|

| 78 |

+

feat16 = self.layer3(feat8) # 1/16

|

| 79 |

+

feat32 = self.layer4(feat16) # 1/32

|

| 80 |

+

return feat8, feat16, feat32

|

| 81 |

+

|

| 82 |

+

def init_weight(self):

|

| 83 |

+

state_dict = modelzoo.load_url(resnet18_url)

|

| 84 |

+

self_state_dict = self.state_dict()

|

| 85 |

+

for k, v in state_dict.items():

|

| 86 |

+

if 'fc' in k: continue

|

| 87 |

+

self_state_dict.update({k: v})

|

| 88 |

+

self.load_state_dict(self_state_dict)

|

| 89 |

+

|

| 90 |

+

def get_params(self):

|

| 91 |

+

wd_params, nowd_params = [], []

|

| 92 |

+

for name, module in self.named_modules():

|

| 93 |

+

if isinstance(module, (nn.Linear, nn.Conv2d)):

|

| 94 |

+

wd_params.append(module.weight)

|

| 95 |

+

if not module.bias is None:

|

| 96 |

+

nowd_params.append(module.bias)

|

| 97 |

+

elif isinstance(module, nn.BatchNorm2d):

|

| 98 |

+

nowd_params += list(module.parameters())

|

| 99 |

+

return wd_params, nowd_params

|

| 100 |

+

|

| 101 |

+

|

| 102 |

+

if __name__ == "__main__":

|

| 103 |

+

net = Resnet18()

|

| 104 |

+

x = torch.randn(16, 3, 224, 224)

|

| 105 |

+

out = net(x)

|

| 106 |

+

print(out[0].size())

|

| 107 |

+

print(out[1].size())

|

| 108 |

+

print(out[2].size())

|

| 109 |

+

net.get_params()

|

vtoonify/model/dualstylegan.py

ADDED

|

@@ -0,0 +1,203 @@

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|