text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Лепим снеговика (украшаем приложение)

Хорошие новости. Скоро Новый Год.

И, хочешь — не хочешь, а создавать новогоднее настроение пользователям — надо.

Халявщики дизайнеры/иллюстраторы — уже давно прибили какую-ть снежинку/шапочку/веточку к логотипу и побежали покупать подарки с чистой совестью. Ну а мы, неумехи-программисты — легких путей не умеем.

Сперва я конечно решил делать снег. Много лет назад для своего первого сайта я тоже лепил снег. Видимо традиция такая.

Скачал [Nine Old Androids (бэкпорт анимаций из третьего анроида)](http://nineoldandroids.com/), запустил Droid Flakes:

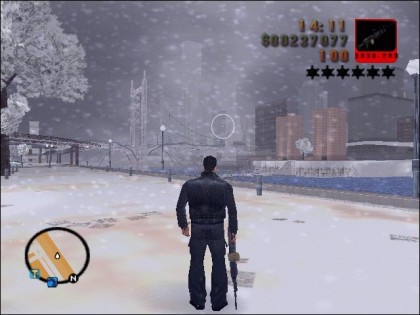

Мне макс пэйн запомнился из-за снега. Очень атмосферный там был снег. Сидишь бывало и залипаешь.

Как думаете, сколько снежинок на картинке выше? Тысяча? Так вот. У меня вроде самый мощный смартфон из того что было в магазине. И он подлагивает уже на 256 объектах. Которые даже не по синусоиде-ближе-дальше-вправо-влево-поворот, а тупо в вниз летят. Нет, такой снег нам не нужен. Это вообще не снег, это падающие роботы какие-то. Можно наверно оптимизировать, но время то уходит.

Несколько часов было убито на поиск красивого, свободного новогоднего шрифта с поддержкой кириллицы. Наверно я не там искал.

Я уже решил сдаться и ныть в скайп знакомым дизайнерам с просьбой прибить веточку к логотипу, как вдруг меня осенило —

Прелоадер! Прелоадер ненавязчив. Его легко делать. Он не тормозит, не жрет ресурсов и вообще — няшечка.

Итак, простой рецепт, как за пол часа слепить снеговика к новогоднему столу:

1. Выбираем прелоадер.

— я выбирал тут: [preloaders.net](http://preloaders.net/)

2. Настраиваем под себя

— задаем размер

— цвет фона

— количество фреймов

[скрин](http://leprastuff.ru/data/img/20121229/22e6c848307cd6c7082cb82ad9e28e42.png), для просто толковых

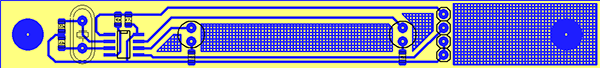

3. Жмем — Скачать как спрайты (сразу переназываем файл буковками типа snowman)

4. Открываем в фотошоп

— задаем направляющие

for (int i=0;i

— View/New Guide

— guide.setValue( i \* frame.getWidth );

}

(ну в смысле я не знаю есть ли в фотошопе какой то скриптовый язык и как им пользоваться. В итоге как дебил кликал мышкой 12 раз. Не волнуйтесь, это самая сложная часть)

— Выбираем Slice tool (у меня он спрятался в правом клике на иконке crop)

— Кнопка — Slice from guides (неожиданно появилась вверху)

— File/save for web and devices

5. Copy/paste иконки в папку drawable

6. Открываем Idea

— правый клик на папке Drawable, New/Drawable resource file — loader.xml

— вставляем текст:

```

xml version="1.0" encoding="utf-8"?

```

— открываем наш лэйаут и добавляем новый, блестящий прогресс-бар

```

```

7. Открываем активити, в котором будет вращать бедрами наш сексуальный снеговик

— Объявляем, инициализируем:

```

private ImageView progressBar;

@Override

public View onCreateView(LayoutInflater inflater, ViewGroup container,

Bundle savedInstanceState) {

View v = inflater.inflate(R.layout.videos, container, false);

progressBar = (ImageView)v.findViewById(R.id.progressBar);

progressBar.setVisibility(View.GONE);

}

```

— Запускаем анимацию (например на запрос):

```

private String restRequest(Bundle params,Boolean useCashe,int httpVerb,int mode,String method) {

progressBar.setVisibility(View.VISIBLE);

progressBar.post(new Runnable() {

@Override

public void run() {

AnimationDrawable frameAnimation =

(AnimationDrawable) progressBar.getBackground();

frameAnimation.start();

}

});

}

```

— Тушим анимацию (например на ответ):

```

private void onRESTResult(int code, String result, int mode) {

progressBar.setVisibility(View.GONE);

progressBar.clearAnimation();

}

```

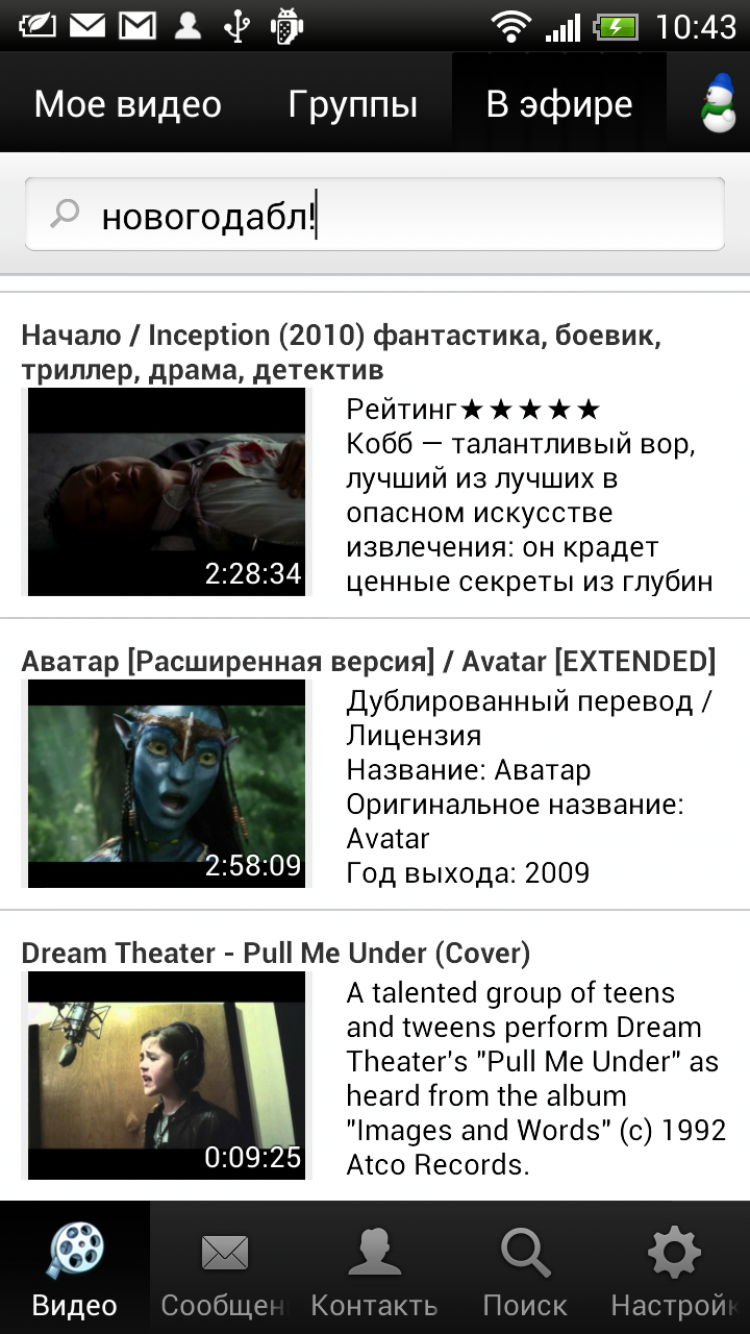

**Снеговик готов!**

Вот что получилось в итоге:

— картинка

— архив c нарезанным снеговиком и лэйаутом, для лентяев

[www.dropbox.com/s/xp1bke8jztc9gbo/snowman.zip](https://www.dropbox.com/s/xp1bke8jztc9gbo/snowman.zip)

— приложение

[ссылку на приложения я убрал, дабы не смущать рекламой]

|

https://habr.com/ru/post/164333/

| null |

ru

| null |

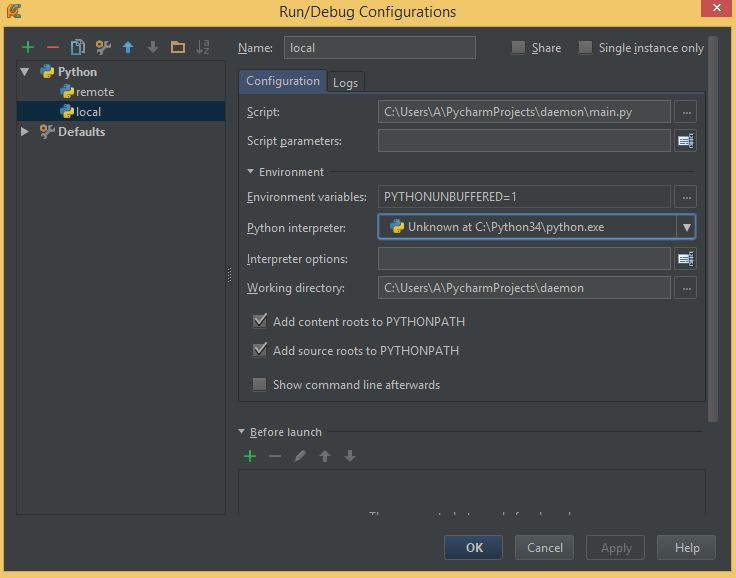

# Пишем чат бота для ВКонтакте на python с помощью longpoll. Часть вторая. Двойные циклы, исключения и прочая ересь

Приветствую, Хабр. Эта статья является продолжением [вот этой](https://habr.com/post/428507/). Перед прочтением настоятельно рекомендую ознакомится с ней если вы этого не сделали ранее.

Сегодня вы узнаете:

1. Как получать более одного ответа, пусть и колхозно

2. Как подключить к этому яндекс переводчик

3. И как писать пользователю что он сделал всё неправильно

### Api яндекс переводчика

У яндекс переводчика есть неплохой api его мы и будем использовать. Внимательно изучаем [документацию](https://tech.yandex.ru/translate/doc/dg/concepts/about-docpage/) и в бой. Но тут Яндекс подкладывает нам свинью.

> Требования к использованию результатов перевода

>

> Согласно Лицензии на использование Яндекс.Переводчика над или под результатом перевода должен быть указан текст Переведено сервисом «Яндекс.Переводчик» с активной ссылкой на страницу [translate.yandex.ru](http://translate.yandex.ru/).

>

>

>

> Требования к расположению текста

>

> Текст должен быть указан:

>

> в описании программного продукта;

>

> в справке о программном продукте;

>

> на официальном сайте программного продукта;

>

> на всех страницах или экранах, где используются данные сервиса.

>

>

Ну мы люди не гордые, переживём.

#### Как оно работает

Пользователь пишет нам сообщение, мы спрашиваем на какой язык он хочет перевести фразу. После спрашиваем текст, который надо перевести и отправляем результат.

#### Техническая реализация

[Получаем](https://translate.yandex.ru/developers/keys) api ключ

Используем вот [эту библиотеку](https://github.com/dveselov/python-yandex-translate)

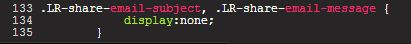

```

from yandex_translate import YandexTranslate #Импортируем библиотеку

translate = YandexTranslate('Вставьте ключ сюда')

```

Пинаем longpoll как я описывал в 1-й части.

```

if event.text == 'Перевод': #если пришло сообщение с текстом "Перевод"

if event.from_user:

vk.messages.send( #Отправляем сообщение

user_id=event.user_id,

message='На какой язык? Указывать двумя буквами.\n Например: Русский - ru, Английский - en' #C текстом "На какой язык? Указывать двумя буквами.\n Например: Русский - ru, Английский - en". Замечание текст должен быть одной строкой

)

elif event.from_chat:

vk.messages.send( #Тоже самое, но для бесед

chat_id=event.chat_id,

message='На какой язык? Указывать двумя буквами.\n Например: Русский - ru, Английский - en'

)

flag = 0 #Шаманский танец для выхода из 2-х циклов

for event in longpoll.listen():

if event.type == VkEventType.MESSAGE_NEW and event.to_me and event.text: #Если получили сообщение с текстом

trTo = event.text #Сохраняем текст в переменную

if event.from_user:

vk.messages.send( #Отправляем сообщение

user_id=event.user_id,

message='Введите фразу, которую надо перевести '

)

elif event.from_chat:

vk.messages.send( #Тоже самое, но для бесед

chat_id=event.chat_id,

message='Введите фразу, которую надо перевести '

)

for event in longpoll.listen():

if event.type == VkEventType.MESSAGE_NEW and event.to_me and event.text: #Если получили сообщение с текстом

trNormal = 1 #Колхозный флаг для ошибки

try: #Исключение, о них поговорим ниже

trFrom = translate.detect(event.text) #Определяем язык

trResult = translate.translate(event.text, trFrom + '-' + trTo) #Переводим

except Exception as e: #Если что-то пошло не так

trNormal = 0 #Пинаем флаг ошибки

print("Exception:", e) #Пишем в консоль

pass

if trNormal == 1: #Если всё хорошо

if event.from_user:

vk.messages.send( #Отправляем сообщение

user_id=event.user_id,

message='Переведено сервисом «Яндекс.Переводчик» translate.yandex.ru\n' + str(trResult['text'])

)

flag = 1 #Выходим из 2-х циклов

break

elif event.from_chat:

vk.messages.send( #Тоже самое, но для бесед

chat_id=event.chat_id,

message='Переведено сервисом «Яндекс.Переводчик» translate.yandex.ru\n' + str(trResult['text'])

)

flag = 1

break

if trNormal == 0: #Если всё плохо

if event.from_user:

vk.messages.send( #Отправляем сообщение

user_id=event.user_id,

message='Неправильно введён язык' #Т.к. всё плохо в 99% случаев из-за того, что пользователь написал язык неправильно пишем ему об этом

)

flag = 1 #Выходим из 2-х циклов

break

elif event.from_chat:

vk.messages.send( #Тоже самое, но для бесед

chat_id=event.chat_id,

message='Неправильно введён язык'

)

flag = 1

break

if flag == 1: #Шаманский танец для выхода из 2-х циклов

break

```

### Что такое исключения и с чем их едят

Исключения — это такая штука, которая в случае ошибки бежит и говорит нам об этом. Для обработки исключений используется конструкция try — except.

Давайте попробуем реализовать наш код без этой конструкции.

> -Перевод

>

> -На какой язык? Указывать двумя буквами.

>

> Например: Русский — ru, Английский — en

>

> -en

>

> -Введите фразу, которую надо перевести

>

> -Привет хабр

>

> -Переведено сервисом «Яндекс.Переводчик» translate.yandex.ru

>

> ['Hi Habr']

Ну вот работает, и зачем нам ваши исключения?

А вот зачем:

> -Перевод

>

> -На какой язык? Указывать двумя буквами.

>

> Например: Русский — ru, Английский — en

>

> -абракадабра

>

> -Введите фразу, которую надо перевести

>

> -Привет хабр

>

> ...

Тем временем в консоли:

```

Traceback (most recent call last):

File "C:\Py_trash\habrex.py", line 112, in

main()

File "C:\Py\_trash\habrex.py", line 78, in main

trResult = translate.translate(event.text, trFrom + '-' + trTo)

File "C:\Users\Hukuma\AppData\Local\Programs\Python\Python37-32\lib\site-packages\yandex\_translate\\_\_init\_\_.py", line 150, in translate

raise YandexTranslateException(status\_code)

yandex\_translate.YandexTranslateException: None

```

А с исключениями:

> -Перевод

>

> -На какой язык? Указывать двумя буквами.

>

> Например: Русский — ru, Английский — en

>

> -Абракадабра

>

> -Введите фразу, которую надо перевести

>

> -Привет хабр

>

> -Неправильно введён язык

Более подробно разберу конструкцию try — except:

```

try:

#sample code

except Exception:

#код который выполнится ТОЛЬКО если будет исключение

```

Приведу пример с wikipedia api:

```

try:

result = str(wikipedia.summary(event.text))

except wikipedia.exceptions.PageError:

print('Ничего не найдено')

except wikipedia.exceptions.DisambiguationError:

print('Неоднозначность')

```

Как вы поняли, исключений может быть несколько.

На этом я с вами прощаюсь. Всего хорошего

|

https://habr.com/ru/post/428790/

| null |

ru

| null |

# А есть ли случайные числа в CSS?

CSS позволяет создавать динамические макеты и интерфейсы в Интернете, но как язык разметки он является статическим — после установки значения его нельзя изменить. Идея случайности не обсуждается. Генерация случайных чисел во время выполнения — это территория JavaScript, а не CSS.

Или нет? Если мы учтем небольшое взаимодействие с пользователем, мы на самом деле можем генерировать некоторую степень случайности в CSS. Давайте взглянем!

#### Случайность в других языках

Есть способы получить некоторую «динамическую рандомизацию» с помощью переменных CSS, как объясняет Робин Рендл (Robin Rendle) в статье [о хитростях CSS](https://css-tricks.com/random-numbers-css/). Но эти решения не 100% CSS, так как они требуют JavaScript для обновления переменной CSS новым случайным значением.

Мы можем использовать препроцессоры, такие как Sass или Less, чтобы генерировать случайные значения, но как только код CSS компилируется и экспортируется, значения фиксируются и случайность теряется.

#### Почему меня волнуют случайные значения в CSS?

В прошлом я разрабатывал простые приложения только для CSS, такие как [Викторина](https://codepen.io/alvaromontoro/pen/jGLOBy), игра [CSСимона](https://codepen.io/alvaromontoro/pen/BGNaYo) и [Магический трюк](https://codepen.io/alvaromontoro/pen/xagVOa), но я хотел сделать что-то более сложное.

\*Я оставлю обсуждение обоснованности, полезности или практичности создания этих фрагментов только на CSS на более позднее время.

Исходя из того, что некоторые настольные игры могут быть представлены как конечные автоматы (FSM), значит они могут быть представлены с использованием HTML и CSS.

Поэтому я начал разрабатывать игру [«Лила»](https://ru.wikipedia.org/wiki/%D0%9B%D0%B8%D0%BB%D0%B0_(%D0%B8%D0%B3%D1%80%D0%B0)(она же «Змеи и Лестницы»).

Это простая игра. Если вкратце, то цель игры состоит в том, чтобы продвинуть фишку от начала до конца доски, избегая змей и пытаясь подняться по лестнице.

Проект казался осуществимым, но я кое-что упустил, ага точно — игральные кости!

Бросок костей (в других играх бросок монеты) – общепризнанные методы получения случайного значения. Вы бросаете кости или подбрасываете монету, и каждый раз получаете неизвестное значение. Кажется все просто.

#### Имитация случайного броска костей

Я собирался наложить слои с метками и использовать CSS-анимацию, чтобы «вращать» и обмениваться тем, какой слой был сверху. Что-то вроде этого:

Код для имитации этой рандомизации не слишком сложен и может быть достигнут с помощью анимации и различных задержек анимации:

```

/* Самый высокий z-index - количество сторон в кости */

@keyframes changeOrder {

from { z-index: 6; }

to { z-index: 1; }

}

/* Все метки перекрываются с помощью абсолютного позиционирования */

label {

animation: changeOrder 3s infinite linear;

background: #ddd;

cursor: pointer;

display: block;

left: 1rem;

padding: 1rem;

position: absolute;

top: 1rem;

user-select: none;

}

/* Отрицательная задержка, поэтому все части анимации находятся в движении */

label:nth-of-type(1) { animation-delay: -0.0s; }

label:nth-of-type(2) { animation-delay: -0.5s; }

label:nth-of-type(3) { animation-delay: -1.0s; }

label:nth-of-type(4) { animation-delay: -1.5s; }

label:nth-of-type(5) { animation-delay: -2.0s; }

label:nth-of-type(6) { animation-delay: -2.5s; }

```

Анимация была замедлена, чтобы упростить взаимодействие (но все ещё достаточно быстро, чтобы увидеть препятствие, объясненное ниже). Псевдослучайность также более ясна.

```

Click here to roll the dice

Click here to roll the dice

Click here to roll the dice

Click here to roll the dice

Click here to roll the dice

Click here to roll the dice

You got a:

```

```

@keyframes changeOrder {

from { z-index: 6;}

to { z-index: 1; }

}

label {

animation: changeOrder 3s infinite linear;

background: #ddd;

cursor: pointer;

display: block;

left: 1rem;

padding: 1rem;

position: absolute;

top: 1rem;

user-select: none;

}

label:nth-of-type(1) { animation-delay: 0s; }

label:nth-of-type(2) { animation-delay: -0.5s; }

label:nth-of-type(3) { animation-delay: -1.0s; }

label:nth-of-type(4) { animation-delay: -1.5s; }

label:nth-of-type(5) { animation-delay: -2.0s; }

label:nth-of-type(6) { animation-delay: -2.5s; }

div {

left: 1rem;

position: absolute;

top: 5rem;

width: 100%;

}

#d1:checked ~ p span::before { content: "1"; }

#d2:checked ~ p span::before { content: "2"; }

#d3:checked ~ p span::before { content: "3"; }

#d4:checked ~ p span::before { content: "4"; }

#d5:checked ~ p span::before { content: "5"; }

#d6:checked ~ p span::before { content: "6"; }

```

Но затем я наткнулся на некое ограничение. Я получал случайные числа, но иногда, даже когда я нажимал на «кости», поле не возвращало никакого значения.

Я попытался увеличить время анимации, и это, казалось, немного помогло, но у меня все ещё были некоторые неожиданные значения.

Именно тогда я сделал то, что делают большинство разработчиков, когда они находят препятствия, которые они не могут решить — Я поперся за помощью на StackOverflow. Рекомендую.

К счастью для меня, всегда найдутся люди готовые помочь, в моем случае это был [Темани Афиф (Temani Afif) с его объяснением](https://stackoverflow.com/questions/51449737/labels-dont-activate-associated-fields-when-part-of-an-animation/51451218#51451218).

Если постараться упростить, то проблема заключалась в том, что браузер запускает событие нажатия только тогда, когда элемент, находится в активном состоянии (при нажатии мыши), иначе говоря, является тем же элементом, который активен при отжатой клавиши мыши.

Из-за подменяющейся анимации верхний слой-метка (label), при нажатии мыши, по сути, не был тем верхним слоем (label -ом) при отжатой мыши, если только я не сделал это достаточно быстро, ну или медленно, чтобы анимация уже успела пройти все значения цикла. Вот почему увеличение времени анимации скрыло эту проблему.

Решение состояло в том, чтобы применить положение «static», чтобы разорвать стековый контекст, и использовать псевдоэлемент, такой как :: before или :: after с более высоким z-index, чтобы занять его место. Таким образом, активная метка всегда будет сверху при наведении мыши.

```

/* Активный тег label будет статичным и перемещен из окна*/

label:active {

margin-left: 200%;

position: static;

}

/* Псевдоэлемент метки занимает все пространство с более высоким z-index */

label:active::before {

content: "";

position: absolute;

top: 0;

right: 0;

left: 0;

bottom: 0;

z-index: 10;

}

```

Вот код с решением с более быстрым временем анимации:

После внесения этого изменения осталось создать небольшой интерфейс для рисования псевдо кубиков, по которым можно щелкнуть мышью, и CSS [игра Змеи и Лестницы](https://codepen.io/alvaromontoro/pen/gjWPNW#html-box) были завершены.

#### Эта техника имеет некоторые очевидные неудобства

1. Требуется взаимодействие с пользователем — необходимо щелкнуть метку, чтобы вызвать «генерацию случайных чисел».

2. Метод плохо масштабируется — он отлично работает с небольшими наборами значений, но это боль для больших диапазонов.

3. Это не настоящий Random, а все таки псевдо случайность, и компьютер может легко определить, какое значение будет генерироваться в каждый момент.

Но с другой стороны, это 100% CSS (нет необходимости в препроцессорах или других внешних помощниках), и для человека это может выглядеть на 100% случайно.

И, да этот метод можно использовать не только для случайных чисел, но и для случайного всего. В этом случае мы использовали его, чтобы «случайно» выбора компьютера в игре «Камень-ножницы-бумага».

|

https://habr.com/ru/post/474818/

| null |

ru

| null |

# Бэкдор на Node.js: зачем, почему и как это работает

Недавно коллеги из Яндекса поделились с нами сэмплом интересного троянца, о чем мы сообщили в [этой](https://news.drweb.ru/show/?i=13315&c=9&lng=ru&p=0) новости. Такая малварь попадается не часто, поэтому мы решили подробнее ее разобрать, а заодно поговорить о том, почему мы так редко встречаем подобные сэмплы.

Троянец представляет собой многокомпонентный бэкдор, написанный на JavaScript’е и использующий для запуска Node.js. Основные его элементы – worker и updater, которые загружаются и устанавливаются в систему загрузчиком. Полезная нагрузка может быть любой, но в данном случае троянец устанавливает майнер xmrig. На момент проведения исследования разработчик использовал майнера для добычи криптовалюты TurtleCoin.

MonsterInstall распространяется через сайты с читами к популярным видеоиграм. Большинство таких ресурсов принадлежат разработчику троянца, но мы нашли еще несколько зараженных файлов на других подобных сайтах. Владелец одного из них регулярно следит за обновлениями конкурентов и пополняет свой ресурс свежим контентом. Для этого он использует скрипт parser.php, который через прокси ищет новые читы на cheathappens.com.

```

Proxy parse done, total: 1

Use sox 84.228.64.133:1080

Error: CURL error(#52), attempts left: 10

Use sox 84.228.64.133:1080

Posts found: 30!

[33mPage Satisfactory: Трейнер +8 vCL#96731 {CheatHappens.com} already in base[0m

[33mPage Borderlands: The Pre-Sequel - Трейнер +28 v1.2019 {LinGon} already in base[0m

[33mPage Borderlands - Game of the Year Enhanced: Трейнер +19 v1.0.1 {LinGon} already in base[0m

[33mPage Star Wars: Battlefront 2 (2017): Трейнер +4 v01.04.2019 {MrAntiFun} already in base[0m

[36mPage Far Cry 5: Трейнер +23 v1.012 (+LOST ON MARS/DEAD LIVING ZOMBIES) {CheatHappens.com} added 2019-Apr-09[0m

[36mPage Fate/Extella Link: Трейнер +13 v04.09.2019 {CheatHappens.com} added 2019-Apr-09[0m

[36mPage Superhot: Трейнер +3 v2.1.01p { MrAntiFun} added 2019-Apr-09[0m

[36mPage Dawn of Man: Трейнер +7 v1.0.6 {CheatHappens.com} added 2019-Apr-08[0m

[36mPage Borderlands 2: Трейнер +14 v06.04.2019 {MrAntiFun} added 2019-Apr-08[0m

[36mPage Borderlands: The Pre-Sequel - Трейнер +17 v06.04.2019 {MrAntiFun} added 2019-Apr-08[0m

[36mPage Tropico 6: Трейнер +9 v1.01 {MrAntiFun} added 2019-Apr-08[0m

[36mPage Operencia: The Stolen Sun - Трейнер +20 v1.2.2 {CheatHappens.com} added 2019-Apr-08[0m

[36mPage Enter the Gungeon: Трейнер +6 v2.1.3 {MrAntiFun} added 2019-Apr-07[0m

[36mPage The Guild 3: Трейнер +2 v0.7.5 {MrAntiFun} added 2019-Apr-07[0m

[36mPage Dead Effect 2: Трейнер +8 v190401 {MrAntiFun} added 2019-Apr-07[0m

[36mPage Assassin's Creed: Odyssey - Трейнер +26 v1.2.0 {FLiNG} added 2019-Apr-07[0m

[36mPage Assassin's Creed: Odyssey - Трейнер +12 v1.2.0 {MrAntiFun} added 2019-Apr-06[0m

[36mPage Super Dragon Ball Heroes: World Mission - Трейнер +11 v1.0 {FLiNG} added 2019-Apr-05[0m

[36mPage Tropico 6: Трейнер +7 v1.02 97490 {CheatHappens.com} added 2019-Apr-05[0m

[36mPage Risk of Rain 2: Трейнер +10 Build 3703355 {CheatHappens.com} added 2019-Apr-05[0m

[36mPage Sid Meier's Civilization 6 - Rise and Fall: Трейнер +12 v1.0.0.314 {MrAntiFun} added 2019-Apr-05[0m

[36mPage Sid Meier's Civilization 6 - Gathering Storm: Трейнер +12 v1.0.0.314 {MrAntiFun} added 2019-Apr-05[0m

[36mPage Sid Meier's Civilization 6: Трейнер +12 v1.0.0.314 {MrAntiFun} added 2019-Apr-05[0m

[36mPage Borderlands GOTY Enhanced: Трейнер +16 v1.0 {CheatHappens.com} added 2019-Apr-05[0m

[36mPage Borderlands Game of the Year Enhanced: Трейнер +13 v1.00 {MrAntiFun} added 2019-Apr-04[0m

[36mPage Assassin's Creed: Odyssey: Трейнер +24 v1.2.0 (04.04.2019) {CheatHappens.com} added 2019-Apr-04[0m

[36mPage Sekiro: Shadows Die Twice - Трейнер +24 v1.02 {FLiNG} added 2019-Apr-04[0m

[36mPage Hearts of Iron 4: Трейнер +24 v1.6.2 {MrAntiFun} added 2019-Apr-04[0m

[36mPage Wolcen: Lords of Mayhem - Трейнер +5 v1.0.2.1 {MrAntiFun} added 2019-Apr-04[0m

[36mPage Devil May Cry 5: Трейнер +18 v1.0 (04.03.2019) {CheatHappens.com} added 2019-Apr-04[0m

Parse done

```

На сайтах разработчика – большой выбор читов, но по всем ссылкам будет отдаваться один и тот же архив. При попытке скачать любой из файлов с сайта малварщика пользователь получит Trojan.MonsterInstall. О некоторых параметрах троянца можно догадаться по ссылке на скачивание:

```

https:///fc/download.php?name=Borderlands%20GOTY%20Enhanced:%20%D0%A2%D1%80%D0%B5%D0%B9%D0%BD%D0%B5%D1%80%20+16%20v1.0%20{CheatHappens.com}&link=https:////r.php?site=http://gtrainers.com/load/0-0-1-7081-20&password=/&uid=101&sid1=1&sid2=1&charset=utf-8

```

* name – имя архива и ехе в архиве;

* link – ссылка на файл, который пользователь хотел скачать (зашивается в data.json);

* password – пароль на архив.

Допустим, мы выбрали нужный чит и скачали с сайта разработчика троянца защищенный паролем 7zip-архив с многообещающим названием “ExtrimHack.rar”. Внутри него – исполняемый файл, конфигурационный файл, библиотека 7zip, а также bin-архив с нативными библиотеками С++ и скриптами, запускаемыми с помощью бинаря Node.js.

Пример содержимого архива:

* 7z.dll;

* data.bin;

* data.json;

* ESP чит для КС ГО.exe.

При запуске исполняемого файла троянец установит все необходимые для его работы компоненты, а также скачает нужный пользователю чит, используя информацию из data.json-файла с параметрами.

Пример содержимого data.json:

```

{"source":[5,10,11,43],"dataVersion":[0,0,0,115],"link":"http:\/\/clearcheats.ru\/images\/dl\/csgo\/ESP_csgo.dll"}

```

Чтобы исключить работу нескольких копий своего процесса, троянец создает мьютекс «cortelMoney-suncMutex» и устанавливается в директорию "%WINDIR%\WinKit\". Затем проверяет, есть ли он в реестре ([HKLM\\Software\\Microsoft\\Windows Node]). Если да, то читает свои параметры и сравнивает версию с той, что указана в data.json. Если версия актуальная, ничего дальше не делает и завершается.

После этого троянец распаковывает содержимое data.bin в %WINDIR%\\WinKit\\ и устанавливает службу для запуска start.js.

Содержимое data.bin:

* Daemon;

* node\_modules;

* 7z.dll;

* msnode.exe;

* start.js;

* startDll.dll;

* update.js;

* updateDll.dll.

При этом msnode.exe – это исполняемый файл Node.js с действительной цифровой подписью, а каталог node\_modules содержит библиотеки «ffi», «node-windows» и «ref».

В start.js подгружается библиотека startDll.dll и вызывается ее экспорт mymain, в котором она читает из реестра свои параметры, запускает "%WINDIR%\\WinKit\\msnode %WINDIR%\\WinKit\\update.js" и останавливает службу «Windows Node». Скрипт update.js, в свою очередь, подгружает библиотеку updateDll.dll и вызывает ее экспорт mymain. Ничего сложного.

В updateDll.dll троянец начнет проверять подключение к интернету. Для этого он каждые 10 секунд будет отправлять запросы на google.com, yahoo.com, facebook.com, пока все трое не вернут 200 код. Затем отправит на сервер [s44571fu](http://s44571fu)[.]bget[.]ru/CortelMoney/enter.php POST запрос с конфигурационными данными:

```

{"login":"NULL","mainId":"PPrn1DXeGvUtzXC7jna2oqdO2m?WUMzHAoM8hHQF","password":"NULL","source":[0,0,0,0],"updaterVersion":[0,0,0,0],"workerVersion":[0,0,0,0]}

```

При этом для базовой авторизации используется пара «cortel:money», а User-Agent выставлен «USER AGENT». Для базовой авторизации последующих запросов будут использоваться login:password, которые сообщит сервер.

Сервер отвечает json-ом следующего вида:

```

{

"login": "240797",

"password": "tdzjIF?JgEG5NOofJO6YrEPQcw2TJ7y4xPxqcz?X",

"updaterVersion": [0, 0, 0, 115],

"updaterLink": "http:\/\/s44571fu.bget.ru\/CortelMoney\/version\/0-0-0-115-upd.7z",

"workerVersion": [0, 0, 3, 0],

"workerLink": "http:\/\/s44571fu.bget.ru\/CortelMoney\/version\/0-0-3-0-work.7z"

}

```

Как видим, в ответе сервера указаны версии основных элементов троянца. Если текущая версия updater’а на устройстве пользователя старше той, что сообщил сервер, троянец скачивает файл по указанной ссылке и распаковывает архив в директорию "%WINDIR%\\WinKit\\\\", где вместо будет указано значение параметра updaterVersion из ответа сервера.

Троянец распаковывает worker файл в директорию %WINDIR%\\WinKit\\SystemNode\\, после чего запускает "%WINDIR%\\WinKit\\SystemNode\\sysnode %WINDIR%\\WinKit\\SystemNode\\main.js".

Содержимое архива с worker’ом:

* node\_modules;

* 7za.exe;

* codex;

* main.js;

* sysnode.exe.

Затем троянец удаляет службу «Windows Node Guard», после чего создает ее заново, заменив исполняемый файл на файл службы «Windows Node». Таким же образом он пересоздает службу «Windows Node» с заменой исполняемого файла на daemon\\service.exe.

Рядом формирует service.xml с параметрами:

```

service.exeC:\Windows\\WinKit\0.0.0.115\msnode.exe"C:\Windows\\WinKit\0.0.0.115\start.js"

```

Updater устанавливается в директорию «C:\Windows\Reserve Service», прописывается службой и запускается бинарником Node.js. Он также состоит из нескольких js-скриптов и нативных библиотек на С++. Основным модулем является main.js.

Содержимое архива с updater’а:

* main.js;

* start.js;

* crypto.dll;

* network.dll;

* service.exe.

Первым делом троянец узнает текущую дату, отправив запрос к google.com, yandex.ru или [www.i.ua](http://www.i.ua). Полученную информацию он использует чуть позже. Затем расшифровывает с помощью библиотеки crypto.dll содержимое файла bootList.json.

Алгоритм дешифровки:

```

key = '123'

s = ''

for i in range(len(d)):

s += chr((ord(d[i]) - ord(key[i % len(key)])) & 0xff)

```

Получает оттуда список управляющих серверов:

```

[{"node":"http://cortel8x.beget.tech/reserve","weight":10},{"node":"http://reserve-system.ru/work","weight":10}]

```

Затем троянец читает информацию из реестра:

```

function getInfo()

{

var WindowsNodeInfo = new Object();

WindowsNodeInfo.mainId = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Windows Node", "mainId");

WindowsNodeInfo.login = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Windows Node", "log");

WindowsNodeInfo.password = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Windows Node", "pass");

WindowsNodeInfo.source = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Windows Node", "source");

WindowsNodeInfo.updaterVersion = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Windows Node", "updaterVersion");

WindowsNodeInfo.workerVersion = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Windows Node", "workerVersion");

var ReserveSystemInfo = new Object();

ReserveSystemInfo.workerVersion = windowsLib.getStringRegKey("HLM\\SOFTWARE\\Microsoft\\Reserve System", "updaterVersion");

var myInfo = new Object();

myInfo.windowsNode = WindowsNodeInfo;

myInfo.reserveSystem = ReserveSystemInfo;

return JSON.stringify(myInfo);

}

```

После чего добавляет HTTP-заголовок базовой авторизации, соответствующий паре «cortel:money», и отправляет ее POST-запросом на ранее расшифрованный управляющий сервер.

В ответ от сервера получает:

```

{

"data": {

"updaterVersion": [0, 0, 0, 1],

"updaterLink": "/upd.7z",

"updaterVerify": "£ñß(\u0012Ä\ti¾$ë5»\u001c²\u001c\fÙ=±÷ö´èUnÐÂBÔ\n\u001dW6?u½\u0005n\u000fp:üÍ\u0019\u0000\u000bSý«\u00137÷\u0013”’ì¥û§s7F\u0016ó\\\u000f%6ñê\"7î<ýoä0Æ%tñÅvS¡\r\u001eÅÆ¡¿N)v\\f8\u0004F\fUS¯³§ oIõiÆîGݪ\u0017êH/8Ö1-°[P5E7XFø%SXÕ6Oþ=Vô

:.3i\u000eÁù9Ã&¾M\u001eÛªé$\u0006#IèÞÛ\u0018À\u001b^è,ÁòÑCTXb\u001d$ç\u0004ð¶0UVÕ»e\u001f\b\u001e¡Ä¼è+Fjúÿoâz\r!çô3xØs_\u000b\u0017\u001fY]\u0001¥j^û\\W",

"dateTime": 1534868028000,

"bootList": [{

"node": "http://cortel8x.beget.tech/reserve/",

"weight": 10

}, {

"node": "http://reserve-system.ru/work/",

"weight": 10

}]

},

"dataInfo": "I`ù@ÀP‘ÈcÊÛ´#ièÒ~\u0007<\u0001Ýìûl«ÔÆq\u0013àÛ\u0003\b\u0017ÑLÁ}ÿÚDS']\u0003bf\u0003!¿Cð¸q¸ÖÜ’B¢CÄAMÀA¤d\u001c5¨d-\u0013\u0011ѼF‘|SB[¬°(ܹÈÒÜ £L\u00071¾:`\u001bìýKõ\"²¸$´3UºÅ¨J¨cf¿}r;Öeì¶xØKt¥47a\u001e¸Ôy\u0006\u001b\u0004ó\u001a\u0019\nu>¨)bkæ

'\u00127@é7µæy3ÈNrS’Mð\u0018\u0019¾òÓ[å5H·¦k‘¿É&PÂÈîåÚ~M\u0010ðnáH擪xÃv cד\u0013

T

ïÑÝ\t\u0018Æ\u00148$”Ôî"

}

```

И тут пригодится текущая дата, полученная ранее. Троянец сверяет ее с dataTime-параметром, переданным сервером. Если разница между датами больше недели (в пересчете на миллисекунды), троянец не станет выполнять команды. Также в параметре dataInfo содержится подпись данных (поле data), она проверяется с помощью зашитого в main.js публичного ключа. А в параметре «bootList» содержится список серверов, который троянец шифрует и сохраняет в «bootList.json».

После этого троянец сверяет свою версию с той, что указана в параметре «updaterVersion». Если установленная версия не ниже последней актуальной, троянец запускает «upd\\upd.exe», передав параметром «main.js». Если версия из ответа сервера новее, то троянец скачивает по ссылке из параметра «updaterLink» upd.7z архив с обновлением, проверяет его подпись и распаковывает. Затем записывает в реестр версию обновления [HKLM\\SOFTWARE\\Microsoft\\Reserve System] 'updaterVersion', после чего опять же запускает «upd\\upd.exe», передав параметром «main.js».

Worker троянца проверяет, что из компонентов уже установлено, и принимает решения о необходимости установки приложений. Первым делом он создает мьютекс «MoonTitleWorker», затем расшифровывает файл codeX XOR-ом со строкой «xor» и выполняет его. После этого формирует json с информацией:

```

{"userId": id, "starter": [], "worker": [], "source": [], "osInfo": {"isX64": True, "osString": "Windows 7 Enterprise"}}

```

Отправляет эту информацию POST-запросом на http://[.]xyz:1001/getApps (ради приличия мы не указываем доменное имя, но его можно узнать [здесь](https://github.com/DoctorWebLtd/malware-iocs/tree/master/Trojan.MonsterInstall).) Ответ сервера может содержать информацию о приложениях, которые нужно установить.

Пример ответа:

```

{

"body": {

"apps": [{

"hash": "452f8e156c5c3206b46ea0fe61a47b247251f24d60bdba31c41298cd5e8eba9a",

"size": 8137466,

"version": [2, 0, 0, 2],

"link": "xmr-1-64.7z",

"path": "%pf%\\Microsoft JDX\\64",

"runComand": "%path%\\moonlight.exe start.js",

"name": "xmr64"

}]

},

"head": "O~¨^Óå+ßzIçsG¬üSʶ$êLLùθZ\f\u0019ÐÐ\u000e\u0004\u001cÀU¯\u0011)áUÚ\u001flß²A\u001fôÝÔì±y%\"DP»^¯«FUâ\u001cÔû\u001dµ´Jï#¬ÌȹÎÚª?\r]Yj·÷õ³\u001e°ÖÒ\\é¤dBT\u0019·¦FõVQ°Aç)\u001cõªµ¦ýûHlb͸þ}é\u0000jvÔ%S;Ã×þA\u0011ßI[´\u0004ýÚ\u0007Z:ZÂ\nñz#ÈBö²2\u0007ÎJw±èTVoå\bÖR3½ù;ó\u0011ÉÌÅÖàð06ÓeÕþ7Ù\u0011»¢5µgôÛc&L\u000fê.?!Çæ}¨\u001eÕJ#A¼_Ì\u0015càñb"

}

```

Если на устройстве нет такого приложения, троянец скачивает его, отправив POST-запрос на URL http://[.]xyz:1001/, где вместо будет указано значение параметра «link» для соответствующего приложения из ответа сервера. Если такое приложение есть, но более старой версии, оно обновляется до актуальной.

Троянец сверяет размер и хэш скачанного файла с информацией, указанной сервером в параметрах «hash» и «size». Если данные сходятся, он перемещает файл по пути из параметра «path» и запускает команду, указанную в поле «runCommand». Информация о скачанном приложении сохраняется в реестре [HKLM\\SOFTWARE\\Microsoft\\MoonTitle\\apps\\].

На данный момент с помощью бэкдора ставится майнер xmrig. В зависимости от разрядности системы троянец скачивает xmr-1.7z или xmr-1-64.7z архив. В start.js подгружает библиотеку xmrig.dll и вызывает экспорт mymain, где она разворачивает свои переменные окружения и убивает процессы:

* %sys32\_86%\\xmr;

* %sys32\_86%\\xmr64;

* %pf\_86%\\Microsoft JDX\\32\\windows-update.exe;

* %pf\_86%\\Microsoft JDX\\64\\windows-update.exe.

Если рядом находится файл xmrig.exe, троянец загружает его в память текущего процесса, стирает сигнатуру MZ, расшифровывает его с использованием XOR с 0x39, после чего сохраняет его дамп в файле «dump ». Если троянец находит в той же директории файл «dump», то расшифровывает его таким же образом, запускает windows-update.exe и встраивает в него расшифрованную полезную нагрузку.

Троянец собирает и отправляет POST-запросом на URL: [cherry-pot](http://cherry-pot)[.]top/RemoteApps/xmr/main.php следующую информацию о системе: {«action»:«enter»,«architecture»:«INTEL»,«cpuAES»:true,«cpuCache»:8192,«cpuSpeed»:3392.0,«cpuThreads»:2,«cpuVendorString»:" Intel® Core(TM) i5-4690S CPU @ 3.20GHz\u0000",«hightPages»:false,«login»:«null»,«password»:«null»,«ramPhysicalSize»:3071,«xmrigVersion»:[2,10,0]}

В ответ сервер присылает конфигурацию майнера:

```

{"maxCpuLoad":1000,"minCpuLoad ":0,"algo":"cryptonight-pico/trtl","av":0,"background":false,"donate-level":1,"max-cpu-usage":75,"retries":5,"retry-pause":5,"cpu-priority":1,"pools":[{"url":"185.224.133.91:5511","keepalive":true,"nicehash":true}]}

```

После того как троянец сохранит конфигурацию в config.json, он автоматически запустится и начнет майнить.

У MonsterInstall есть и другие модификации. К примеру, кроме читов для игр разработчик малвари распространял его под видом установщика браузера Chrome и программы для проверки файлов. В более поздних версиях троянца разработчик задумался о безопасности и добавил шифрование строк, а также необходимость ввода пароля для некоторых файлов. Кроме того, в загрузчике одной из версий троянца даже есть ссылка на лицензионное соглашение, размещенное на домене разработчика троянца.

(Вопросы о юридической силе подобных соглашений, к сожалению, выходят за рамки этой статьи, но если вам было бы интересно почитать материал на эту тему, сообщите нам в комментариях).

**Выводы**

Node.js – не самое практичное решение для вирусописателей. Если размер такого троянца и может быть небольшим, то обвязка Node.js (исполняемый файл и библиотеки) будет значительно «тяжелее» стандартной малвари. Чем же продиктован такой выбор? Как правило, разработчики выбирают инструменты, с которыми они хорошо знакомы. Поэтому даже в случае с малварщиками выбор технологии – в большей степени вопрос личных предпочтений. Тем не менее, у Node.js есть свои плюсы, одним из которых является валидная подпись. В системе такой процесс будет подписан как Node.js, что редко вызывает подозрения.

Подводя итоги, можно отметить, что, несмотря на интересный выбор инструментов, это не дало разработчику бэкдора какого-то значительного преимущества. Маловероятно, что в будущем мы увидим больше вредоносных программ, использующих Node.js.

Как обычно, делимся [индикаторами компрометации](https://github.com/DoctorWebLtd/malware-iocs/tree/master/Trojan.MonsterInstall).

|

https://habr.com/ru/post/460255/

| null |

ru

| null |

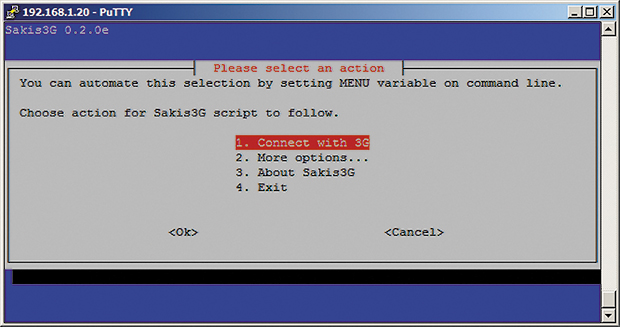

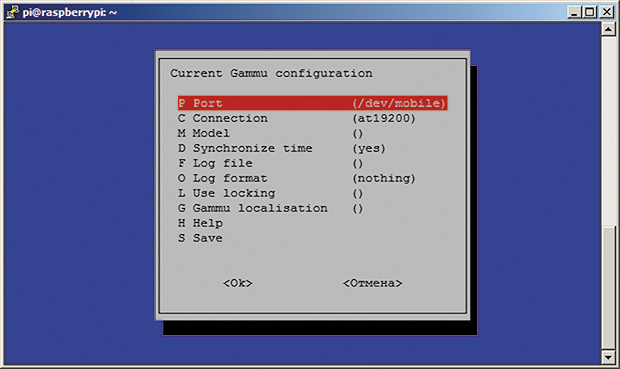

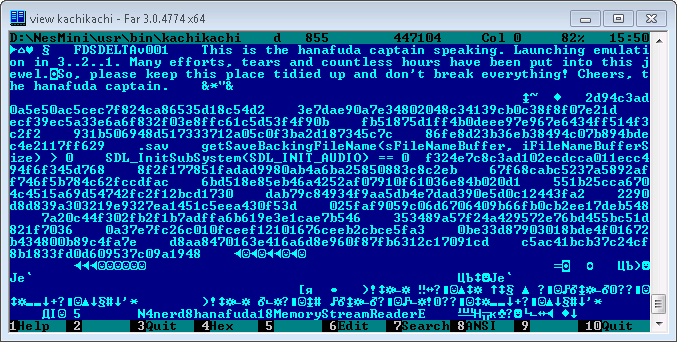

# Raspberry Pi Zero внутри брайлевского дисплея Handy Tech Active Star 40

Автор поместил Raspberry Pi Zero, Bluetooth-«свисток» и кабель внутрь своего нового брайлевского дисплея Handy Tech Active Star 40. Встроенный USB-порт обеспечивает питание. Получился самодостаточный безмониторный компьютер на ARM с операционной системой Linux, оборудованный клавиатурой и брайлевским дисплеем. Можно заряжать/питать его через USB, в т.ч. от пауэрбанка или солнечного зарядного устройства. Поэтому он может обходиться без электросети не несколько часов, а несколько дней.

Габаритная дифференциация брайлевских дисплеев

==============================================

Прежде всего, они различаются длиной строки. Устройства на 60 и более знакомест хороши при работе с настольным компьютером, на 40 — удобны для переноски вместе с ноутбуком. Сейчас существуют и брайлевские дисплеи, подключаемые к смартфонам и планшетам, с длиной строки в 14 или 18 знакомест.

В прошлом брайлевские дисплеи были довольно массивными. 40-знакоместный, например, имел размеры и вес как у 13-дюймового ноутбука. Теперь они при том же количестве знакомест достаточно миниатюрны, чтобы можно было поставить дисплей перед ноутбуком, а не ноутбук на дисплей.

Это, конечно, лучше, но всё равно не очень удобно держать на коленях два отдельных устройства. Когда работаешь за столом, претензий нет, но стоит вспомнить, что ноутбук по-другому называется лэптопом, и попробовать оправдать это его название, как оказывается, что миниатюрный 40-знакоместный дисплей даже менее удобен.

Так что автор дождался выхода давно обещанной новой модели в серии Handy Tech Star. Ещё в 2002 году была выпущена предыдущая модель Handy Tech Braille Star 40, где площади корпуса достаточно, чтобы поставить сверху ноутбук. А если он не помещается — предусмотрена выдвижная подставка. Сейчас эта модель заменена на Active Star 40, это практически то же самое, но с модернизированной электроникой.

И выдвижная подставка осталась:

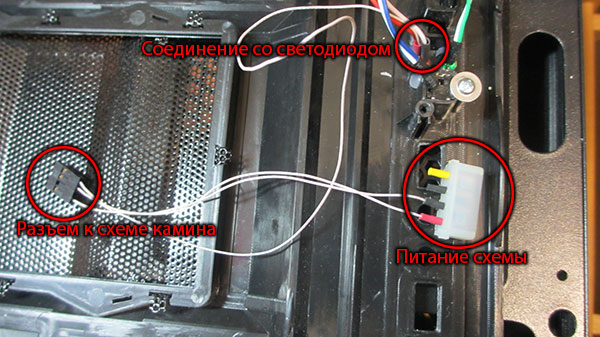

Но самое удобное в новинке — это углубление размерами приблизительно со смартфон (см. КДПВ). Открывается оно при сдвиге площадки назад. Держать там смартфон оказалось неудобно, но надо же как-то задействовать пустой отсек, внутри которого даже выход питания предусмотрен.

Первое, что придумал автор — поместить туда Raspberry Pi, но когда дисплей был приобретён, оказалось, что с «малинкой» не задвигается подставка, закрывающая отсек. Вот если бы плата была всего на 3 мм тоньше…

Но коллега рассказал о выходе Raspberry Pi Zero, который оказался настолько миниатюрным, что в отсек их поместилось бы два… или, пожалуй, даже три. Он был тут же заказан вместе с картой памяти на 64 ГБ, Bluetooth,«свистком» и кабелем Micro USB. Через несколько дней всё это приехало, а зрячие друзья помогли автору подготовить карту. Всё сразу заработало как надо.

Что для этого было сделано

==========================

На задней стенке Handy Tech Active Star 40 расположены два USB-порта для таких устройств, как клавиатуры. Малогабаритная клавиатура с магнитным креплением прилагается. Когда клавиатура подключена, а сам дисплей работает через Bluetooth, компьютер дополнительно опознаёт его ещё и как Bluetooth-клавиатуру.

Таким образом, если к Raspberry Pi Zero, помещённому в отсек для смартфона, подключить Bluetooth-«свисток», он сможет обмениваться данными с брайлевским дисплеем по Bluetooth при помощи [BRLTTY](http://brltty.com/), а если ещё и подключить к дисплею клавиатуру — «малинка» будет работать и с ней.

Но и это ещё не всё. Сама «малинка», в свою очередь, может получать доступ в интернет по Bluetooth PAN с любого поддерживающего его устройства. Автор настроил соответствующим образом свой смартфон и компьютеры дома и на работе, но в дальнейшем планирует приспособить для этого ещё одну «малинку» — классическую, не Zero, подключённую к Ethernet и другому Bluetooth-«свистку».

BlueZ 5 и PAN

=============

Способ конфигурации PAN при помощи [BlueZ](http://www.bluez.org/) оказался неочевидным. Автор нашёл Pyhton-скрипт bt-pan (см. ниже), позволяющий сконфигурировать PAN без GUI.

С его помощью можно настроить как сервер, так и клиент. Получив соответствующую команду по D-Bus при работе в клиентском режиме, он создаёт новое сетевое устройство bnep0 сразу после установки соединения с сервером. Обычно для назначения IP-адреса этому интерфейсу используется DHCP. В серверном режиме BlueZ требует указания названия устройства-моста, к которому он может добавить по ведомому устройству для подключения каждого из клиентов. Сконфигурировать адрес для устройства-моста и запустить DHCP-сервер плюс IP-маскарадинг на мосту — обычно всё, что требуется.

Точка доступа Bluetooth PAN с Systemd

=====================================

Для конфигурации моста автор применил systemd-networkd:

Файл /etc/systemd/network/pan.netdev

```

[NetDev]

Name=pan

Kind=bridge

ForwardDelaySec=0

```

Файл /etc/systemd/network/pan.network

```

[Match]

Name=pan

[Network]

Address=0.0.0.0/24

DHCPServer=yes

IPMasquerade=yes

```

Теперь нужно заставить BlueZ сконфигурировать профиль NAP. Оказалось, штатными утилитами BlueZ 5.36 это сделать нельзя. Если автор ошибается, поправьте его: mlang (умеет двигать ушами) blind (бывает доступа и квантовой) guru

Но он нашёл [сообщение в блоге](http://blog.fraggod.net/2015/03/28/bluetooth-pan-network-setup-with-bluez-5x.html) и [скрипт на Python](https://github.com/mk-fg/fgtk/blob/master/bt-pan) для осуществления необходимых вызовов на D-Bus.

Для удобства автор применил службу Systemd для запуска скрипта и проверки разрешённости зависимостей.

Файл /etc/systemd/system/pan.service

```

[Unit]

Description=Bluetooth Personal Area Network

After=bluetooth.service systemd-networkd.service

Requires=systemd-networkd.service

PartOf=bluetooth.service

[Service]

Type=notify

ExecStart=/usr/local/sbin/pan

[Install]

WantedBy=bluetooth.target

```

Файл /usr/local/sbin/pan

```

#!/bin/sh

# Ugly hack to work around #787480

iptables -F

iptables -t nat -F

iptables -t mangle -F

iptables -t nat -A POSTROUTING -o eth0 -j MASQUERADE

exec /usr/local/sbin/bt-pan --systemd --debug server pan

```

Второй файл не понадобился бы, если бы в Debian была поддержка IPMasquerade= (см. [#787480](https://bugs.debian.org/cgi-bin/bugreport.cgi?bug=787480)).

После выполнения команд *systemctl daemon-reload* и *systemctl restart systemd-networkd* можно запустить Bluetooth PAN командой *systemctl start pan*

Клиент Bluetooth PAN с применением Systemd

==========================================

Клиентскую часть также несложно сконфигурировать при помощи Systemd.

Файл /etc/systemd/network/pan-client.network

```

[Match]

Name=bnep*

[Network]

DHCP=yes

```

Файл /etc/systemd/system/pan@.service

```

[Unit]

Description=Bluetooth Personal Area Network client

[Service]

Type=notify

ExecStart=/usr/local/sbin/bt-pan --debug --systemd client %I --wait

```

Теперь после перезагрузки конфигурации можно подключиться к заданной Bluetooth-точке доступа так:

```

systemctl start pan@00:11:22:33:44:55

```

Сопряжение при помощи командной строки

======================================

Разумеется, конфигурацию сервера и клиентов необходимо выполнять после сопряжения их по Bluetooth. На сервере нужно запустить bluetoothctl и дать ему команды:

```

power on

agent on

default-agent

scan on

scan off

pair XX:XX:XX:XX:XX:XX

trust XX:XX:XX:XX:XX:XX

```

Запустив сканирование, подождите несколько секунд, пока в списке не появится нужное вам устройство. Запишите его адрес и используйте его, подавая команду pair, а при необходимости — и команду trust.

Со стороны клиента надо проделать то же самое, но команда trust не понадобится точно. Серверу она нужна, чтобы принять соединение по профилю NAP без ручного подтверждения пользователем.

Автор не уверен, что это оптимальная последовательность команд. Возможно, всё, что нужно — это сопряжение клиента с сервером и выполнение команды trust на сервере, но так он делать ещё не пробовал.

Разрешение использования Bluetooth-профиля HID

==============================================

Требуется, чтобы «малинка» распознала клавиатуру, подключённую к брайлевскому дисплею проводом, и проброшенную уже самим дисплеем по Bluetooth. Делается так же, только вместо *agent on* надо дать команду *agent KeyboardOnly*, и bluetoothctl найдёт устройство с профилем HID.

Но настраивать Bluetooth через командную строку сложновато

==========================================================

Хотя автору удалось всё сконфигурировать, он понимает, что настраивать BlueZ через командную строку неудобно. Сначала он думал, что агенты нужны только для ввода PIN-кодов, но оказалось, например, что для включения профиля HID нужно набирать «agent KeyboardOnly». Удивительно, что для запуска Bluetooth PAN необходимо лазить по репозиториям в поисках нужного скрипта. Он помнит, что в предыдущей версии BlueZ для этого был готовый инструмент *pand* — куда же он делая в BlueZ 5? Вдруг появилось новое решение, неизвестное автору, но лежащее на поверхности?

Производительность

==================

Скорость передачи данных составила примерно 120 кбит/с, чего вполне достаточно. 1-гигагерцовый ARM-процессор очень быстр для интерфейса командной строки. Автор всё равно планирует использовать на устройстве в основном ssh и emacs.

Консольные шрифты и разрешение экрана

=====================================

Разрешение экрана, используемое фреймбуфером на Raspberry Pi Zero по умолчанию, довольно странное: fbset сообщает, что оно составляет 656x416 пикселей (монитор, конечно, не подключён). При консольной шрифте 8x16 получилось 82 символа в строке и 26 строк.

Работать с брайлевским дисплеем на 40 знакомест в таком режиме неудобно. Также автору хотелось бы, чтобы на дисплей выводились в брайлевском виде знаки Unicode. К счастью, Linux поддерживает 512 символов, а в большинстве консольных шрифтов их 256. С помощью console-setup можно использовать два 256-символьных шрифта совместно. Автор добавил к файлу /etc/default/console-setup такие строки:

```

SCREEN_WIDTH=80

SCREEN_HEIGHT=25

FONT="Lat15-Terminus16.psf.gz brl-16x8.psf"

```

Примечание: чтобы стал доступен шрифт brl-16x8.psf, нужно установить console-braille.

Что дальше?

===========

На брайлевском дисплее есть 3,5-миллиметровый «джек», но автору неизвестны переходники для снятия аудиосигнала с Mini-HDMI. Автору не удалось задействовать встроенную в «малинку» звуковую карту (странно, переводчик был уверен, что в Zero таковой нет, но есть способы вывода звука ШИМом на GPIO). Он планирует применить USB-OTG-хаб и подключить внешнюю карту и вывести звук на встроенную в брайлевский дисплей колонку. Две внешние карты почему-то не заработали, сейчас он ищет аналогичное устройство на другом чипсете.

Ещё неудобно вручную отключать «малинку», ждать несколько секунд и отключать брайлевский дисплей. А всё потому что он при отключении снимает питание с разъёма в отсеке. Автор планирует поместить в отсек небольшой буферный аккумулятор и через GPIO сообщать «малинке» об отключении дисплея, чтобы та приступила к завершению работы. Такой вот ИБП в миниатюре.

Образ системы

=============

Если у вас есть такой же брайлевский дисплей, и вы желаете проделать с ним то же самое, автор готов предоставить готовый образ системы (на основе Raspbian Stretch). Напишите ему об этом по адресу, указанному выше. Если желающих наберётся достаточно много, возможен даже выпуск наборов, включающих в себя всё необходимое для такой переделки.

Благодарности

=============

Спасибо Dave Mielke за вычитку текста.

Спасибо Simon Kainz за фотоиллюстрации.

Спасибо коллегам по Грацкому техническому университету за быстрое приобщение автора к миру Raspberry Pi.

P.S. [Первый твит](https://twitter.com/blindbird23/status/740169540018044928/photo/1) автора на данную тему (не открывается — переводчик) был сделан всего за пять дней до публикации оригинала этой статьи, и можно считать, что за исключением проблем со звуком, поставленная задача практически решена. Кстати, финальный вариант текста автор отредактировал с изготовленного им «самодостаточного брайлевского дисплея», подключив его по SSH к домашнему компьютеру.

|

https://habr.com/ru/post/445454/

| null |

ru

| null |

# DynamicXml: «динамическая» оболочка для работы с XML данными

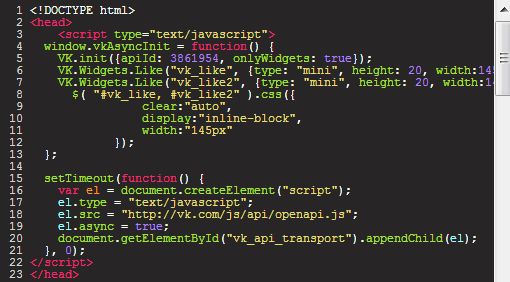

Я уже однажды писал о том, что, несмотря на мою любовь к статической типизации, в некоторых сценариях преимущества от той свободы, которую дает динамическая типизация, может превосходить связанные с ней недостатки. В прошлый раз шла речь о [Dynamic LINQ](http://sergeyteplyakov.blogspot.com/2010/12/dynamic-linq.html), а в этот раз речь пойдет об использовании новой возможности C# 4.0 под названием **dynamic**, для работы с такими исходно слаботипизированными данными, как XML.

ПРИМЕЧАНИЕ

Исходный код библиотеки DynamicXml, рассматриваемой в данной статье, доступен на [github](https://github.com/SergeyTeplyakov/DynamicXml)

#### Введение

Начиная с версии 4.0, в языке C# появилась поддержка динамического программирования, благодаря новому статическому типу под названием **dynamic**. По сути, применение этого ключевого слова говорит компилятору сгенерировать весь необходимый код, чтобы процесс привязки (binding) и диспетчеризации вызовов (dispatch operations) производился во время выполнения, вместо определения всех этих характеристик во время компиляции. При этом компилятор генерирует весь необходимый код с помощью библиотеки DLR – Dynamic Language Runtime (\*), которая была изначально создана при проектировании языка программирования Iron Python и впоследствии вошла в состав .Net Framework 4.0, как основа для реализации динамических языков программирования, а также для взаимодействия между ними.

Несмотря на появление ключевого слова **dynamic** язык программирования C# остался в своей основе статически типизированным; вам все еще нужно явно указать, что решение о том, что именно будет происходить с этим кодом, откладывается до времени выполнения. Кроме того, никто не предполагает, что этой возможностью будут пользоваться ежедневно; эта функция предназначена, прежде всего, для взаимодействия с другими динамически типизированными языками, как Iron Python, Iron Ruby, а также для взаимодействия со слаботипизированным окружением, таким как VSTO (Visual Studio Tools for Office) и другими СОМ API. Еще одним классическим примером использования dynamic является создание «динамических» оболочек над объектами. Весьма известным примером является создание оболочки для доступа к закрытым или защищенным членам класса (\*\*); другим не менее известным примером является создание динамической оболочки для доступа к XML данным. Вот именно на реализации второй возможности мы здесь и остановимся.

#### Простой пример чтения XML данных

Итак, давайте предположим, что у нас есть строка, в которой содержатся следующие данные (\*\*\*):

> `<books>

>

> <book>

>

> <title>Mortal Enginestitle>

>

> <author name=""Philip Reeve"" />

>

> book>

>

> <book>

>

> <title>The Talismantitle>

>

> <author name=""Stephen King"" />

>

> <author name=""Peter Straub"" />

>

> book>

>

> books>

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

И нашей задачей является написание простенького кода, который будет читать и обрабатывать эти данные. Конечно же, в некоторых случаях разумнее десериализировать все это добро в некоторый объект бизнес-логики (в данном случае в список сущностей типа **Book**) с помощью класса **XmlSerializer** и манипулировать уже этим бизнес-объектом, однако во многих случаях значительно лучше подойдет более легковесное решение, например, на основе LINQ 2 XML.

Если предположить, что приведенная выше строка содержится в переменной с именем books, то для получения названия для получения некоторых данных можно воспользоваться весьма простым кодом:

> `var element = XElement.Parse(books);

>

> string firstBooksTitle =

>

> element.Element("book").Element("title").Value;

>

> Assert.That(firstBooksTitle, Is.EqualTo("Mortal Engines"));

>

>

>

> string firstBooksAuthor =

>

> element.Element("book").Element("author").Attribute("name").Value;

>

> Assert.That(firstBooksAuthor, Is.EqualTo("Philip Reeve"));

>

>

>

> string secondBooksTitle =

>

> element.Elements().ElementAt(1).Element("title").Value;

>

> Assert.That(secondBooksTitle, Is.EqualTo("The Talisman"));

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Я совершенно ничего не имею против явного использования **XElement**, более того, этот вариант достаточно простой и элегантный, но тем не менее этот код не лишен недостатков. Во-первых, он достаточно многословен, а во-вторых, он не совсем честен по одной отношению к обработке ошибок: если в переменной **books** не будет элемента с именем **book** или элемента с именем **title** мы получим **NullReferenceException**. Так что этот код нужно доработать напильником, что несколько усложнит его чтение, понимание и сопровождение.

> `// Получаем Dynamic Wrapper над объектом XElement

>

> dynamic dynamicElement = // ...

>

>

>

> // Получаем автора первой книги

>

> string firstBooksTitle = dynamicElement.book.title;

>

> Assert.That(firstBooksTitle, Is.EqualTo("Mortal Engines"));

>

>

>

> // С помощью индексатора, принимающего строку, получаем доступ к атрибуту элемента

>

> string firstBooksAuthor = dynamicElement.book.author["name"];

>

> Assert.That(firstBooksAuthor, Is.EqualTo("Philip Reeve"));

>

>

>

> // С помощью индексатора, принимающего целое число, получаем доступ ко второй книге

>

> string secondBooksTitle = dynamicElement.book[1].title;

>

> Assert.That(secondBooksTitle, Is.EqualTo("The Talisman"));

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Нам все еще нужно использовать индексатор для доступа к значениям атрибутов, поскольку приходится разделять доступ к элементу от доступа к атрибуту, но поскольку, как мы увидим позднее, все полностью в наших руках, то мы можем принять другой решение и реализовать доступ к атрибуту с помощью другого синтаксиса. Тем не менее, полученный синтаксис является более простым и понятным, нежели код с непосредственным использованием LINQ 2 XML и нам осталось ответить на один простой вопрос: что же такое должно скрываться за комментарием “*получаем Dynamic Wrapper над объектом XElement*”, чтобы подобная уличная магия была возможна.

#### Создание «динамической» оболочки для чтения XML данных

Наиболее простым способом создания динамической оболочки, которая при этом будет обладать достаточно широкой функциональностью, является использование класса **DynamicObject** из пространства имен **System.Dynamic**. Данный класс содержит несколько виртуальных функций вида **TryXXX**, которые позволяют «перехватывать» все основные действия с вашим динамическим объектом, которые будут происходить с ним во время выполнения, включая вызовы методов, обращение к свойствам, преобразование типов и многие другие.

Таким образом, все, что нам нужно сделать, это создать класс наследник от **DynamicObject**, который бы принимал в качестве параметра конструктора объект **XElement** и переопределял ряд вспомогательных методов:

> `///

>

> /// "Динамическая оболочка" вокруг XElement

>

> ///

>

> public class DynamicXElementReader : DynamicObject

>

> {

>

> private readonly XElement element;

>

>

>

> private DynamicXElementReader(XElement element)

>

> {

>

> this.element = element;

>

> }

>

>

>

> public static dynamic CreateInstance(XElement element)

>

> {

>

> Contract.Requires(element != null);

>

> Contract.Ensures(Contract.Result<object>() != null);

>

>

>

> return new DynamicXElementReader(element);

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Использование фабричного метода в данном случае обусловлено тем, что он более четко показывает контекст использования этого класса; помимо этого метода в коде библиотеки DynamicXml, содержится еще и статический класс с методами расширения, которые позволяют более удобным образом создавать экземпляры динамической оболочки. Использование контрактов (библиотеки Code Contracts) в данном случае всего лишь упрощает создание подобных библиотечных классов, упрощает тестирование и документирование, а статический анализатор позволяет находить ошибки во время компиляции. Это мое личное предпочтение, если же вам такой подход кажется несимпатичным (хотя очень даже зря) то с помощью волшебного инструмента поиска/замены, вы можете заменить контракты удобным для вас механизмом проверки входных параметров.

Теперь давайте вернемся к реализации класса **DynamicXElementReader**. Вначале немного теории: любое обращение к свойству или методу класса наследника от **DynamicObject** происходит в два этапа: вначале выполняется поиск соответствующего метода или свойства с одноименным именем в этом самом наследнике, а затем уже вызывается соответствующий метод, в котором можно обработать отсутствие данного члена динамически. Поскольку никакая обертка никогда не предоставит абсолютно всю мыслимую и немыслимую функциональность (да в большинстве случаев это и не нужно), то нужно обеспечить получение из обертки нижележащего **XElement**. Кроме того, как мы видели в предыдущем примере, нам нужно сделать два индексатора: один должен принимать **int** и возвращать подэлемент, а второй – принимать строку (или, как мы увидим позднее **XName**) и возвращать атрибут.

> `public class DynamicXElementReader : DynamicObject

>

> {

>

> ///

>

> /// Возвращает true, если текущий элемент содержит родительский узел.

>

> ///

>

> ///

>

> /// Атрибут Pure позволяет использовать этот метод в предусловиях любых методов

>

> ///

>

> [Pure]

>

> public bool HasParent()

>

> {

>

> return element.Parent != null;

>

> }

>

>

>

> public dynamic this[XName name]

>

> {

>

> get

>

> {

>

> Contract.Requires(name != null);

>

>

>

> XAttribute attribute = element.Attribute(name);

>

>

>

> if (attribute == null)

>

> throw new InvalidOperationException(

>

> "Attribute not found. Name: " + name.LocalName);

>

>

>

> return attribute.AsDynamic();

>

> }

>

> }

>

>

>

> public dynamic this[int idx]

>

> {

>

> get

>

> {

>

>

>

> Contract.Requires(idx >= 0, "Index should be greater or equals to 0");

>

> Contract.Requires(idx == 0 || HasParent(),

>

> "For non-zero index we should have parent element");

>

>

>

> // Доступ по нулевому индексу означает доступ к самому текущему элементу

>

> if (idx == 0)

>

> return this;

>

>

>

> // Доступ по ненулевому индексу означает поиск "брата" текущего элемента.

>

> // Для этого необходимо, чтобы текущий элемент содержал родительский узел

>

> var parent = element.Parent;

>

> Contract.Assume(parent != null);

>

>

>

> XElement subElement = parent.Elements().ElementAt(idx);

>

>

>

> // subElement не может быть равен null, поскольку метод ElementAt генерирует

>

> // исключение, если подэлемента с указанным индексом не существует.

>

> // Однако статический анализатор об этом не знает, поэтому мы подсказываем

>

> // ему об этом с помощью метода Contract.Assume

>

> Contract.Assume(subElement != null);

>

>

>

> return CreateInstance(subElement);

>

> }

>

> }

>

>

>

> public XElement XElement { get { return element; } }

>

>

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Первый индексатор, принимает **XName** в качестве параметра и предназначен для получения атрибута текущего элемента по его имени. Типом возвращаемого значения также является dynamic, а реальное возвращаемое значение получается в результате вызова метода расширения **AsDynamic** для объекта **XAttribute**. В принципе, никто не мешает в качестве типа возвращаемого значения использовать тип **XAttribute**, однако в этом случае, для получения непосредственного значения атрибута придется дополнительно обратиться к свойству **Value**, полученного значения, либо воспользоваться явным приведением типа. В целом же, реализация динамической оболочки для атрибутов значительно проще, и реализована аналогичным образом.

Теперь давайте перейдем к реализации двух главных (для этого класса) виртуальных методов класса **DynamicObject**: метода **TryGetMember** – который отвечает за доступ к свойству или полю вида **dynamicObject.Member**, а также метода **TryConvert** – который вызывается при неявном преобразовании типа из динамического типизированного объекта к статически типизированному, **string value = dynamicObject**.

> `public class DynamicXElementReader : DynamicObject

>

> {

>

> // not used

>

> private XElement element;

>

> public static dynamic CreateInstance(XElement) {return null;}

>

>

>

> ///

>

> /// Этот метод вызывается в случае использования оболочки в выражении вида:

>

> /// SomeType variable = dynamicElement;

>

> ///

>

> public override sealed bool TryConvert(ConvertBinder binder, out object result)

>

> {

>

> // При попытке преобразования оболочки к XElement возвращаем

>

> // нижележащий xml-элемент

>

> if (binder.ReturnType == typeof(XElement))

>

> {

>

> result = element;

>

> return true;

>

> }

>

>

>

> // В противном случае получаем значение текущего элемента

>

> // и преобразовываем это значение к типу запрошенного результата

>

> string underlyingValue = element.Value;

>

> result = Convert.ChangeType(underlyingValue, binder.ReturnType,

>

> CultureInfo.InvariantCulture);

>

>

>

> return true;

>

> }

>

>

>

> ///

>

> /// Этот метод вызывается при доступе к члену или свойству

>

> ///

>

> public override bool TryGetMember(GetMemberBinder binder, out object result)

>

> {

>

> string binderName = binder.Name;

>

> Contract.Assume(binderName != null);

>

>

>

> // Если соответствующий подэлемент с указанным именем существует,

>

> // то создаем для него динамическую оболочку

>

> XElement subelement = element.Element(binderName);

>

> if (subelement != null)

>

> {

>

> result = CreateInstance(subelement);

>

> return true;

>

> }

>

>

>

> // В противном случае вызываем базову версию метода, что приводит к ошибке

>

> // времени выполнения

>

> return base.TryGetMember(binder, out result);

>

> }

>

>

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Как уже было сказано выше, метод **TryConvert** вызывается при любой попытке преобразования xml элемента или одного из его подэлементов к указанному типу. Поскольку мы легко можем получить значение текущего xml- лемента, то все, что нужно для реализации этого метода – это вызвать **ChangeType** класса **Convert**; единственным исключением является тип **XElement**, который обрабатывается отдельно и позволяет получить нижележащий **XElement** напрямую.

Метод **TryGetMember** также достаточно простой: вначале мы получаем имя члена, к которому пользовательский код пытается получить доступ, а затем пробуем найти элемент с этим именем. Если указанный элемент найден, мы создаем динамическую оболочку и возвращаем его через выходной параметр result. В противном случае мы вызываем базовую версию, что приводит к исключению времени выполнения, в котором будет сказано, что запрошенный член не найден.

Все это позволяет использовать оболочку следующим образом:

> `// Получаем доступ к первому подэлементу с именем bookXElement

>

> string firstBooksElement = dynamicElement.book;

>

> Console.WriteLine("First books element: {0}", firstBooksElement);

>

>

>

> // Получаем заголовок первой книги и преобразуем его к строке

>

> string firstBooksTitle = dynamicElement.book.title;

>

> Console.WriteLine("First books title: {0}", firstBooksTitle);

>

>

>

> // Получаем количество строк первой книге и преобразуем его к int

>

> int firstBooksPageCount = dynamicElement.book.pages;

>

> Console.WriteLine("First books page count: {0}", firstBooksPageCount);

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Результат выполнения этого кода:

> `First books element: <book>

>

> <title>Mortal Enginestitle>

>

> <author name="Philip Reeve" />

>

> <pages>347pages>

>

> book>

>

>

>

> First books title: Mortal Engines

>

> First books page count: 347

>

> First books author: Philip Reeve

>

> Second books title: The Talisman

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

#### Создание «динамической» оболочки для создания/изменения XML данных

Причиной создания двух классов, одного – ответственного за чтение данных, а второго – за создание и изменение, обусловлено тем, что в реализации метода **TryGetMember** мы заранее не можем узнать, для чего происходит обращение к нижележащему члену. Ведь если это обращение происходит для чтения данных, а указанного элемента нет в исходных XML данных, то наиболее логичным поведением является генерация исключения, в котором будет сказано, что элемент с указанным именем не найден. Именно так себя и ведет приведенная выше реализация в классе **DynamicXElementReader**. Однако нам нужно совершенно иное поведение при создании/изменении XML данных: в этом случае, вместо генерации исключения нам нужно создать пустой элемент с указанным именем; ведь вполне логично предположить, что в создаваемом элементе может и не быть (а точнее, скорее всего не будет) элемента с указанным именем.

Таким образом, к приведенному выше классу **DynamicXElementReader**, предназначенному только для чтения, мы добавляем еще один – **DynamicXElementWriter**, задачей которого будет создание и изменение XML данных. Однако поскольку у двух этих классов есть достаточно много общего, например, реализация метода **TryConvert**, а также некоторые вспомогательные методы, типа HasParent, то реальный код, содержит еще один вспомогательный класс **DynamixXElementBase**, устраняющий дублирование кода и упрощающий реализацию его наследников. Однако поскольку анализировать код с дополнительным базовым классом несколько сложнее, то здесь я его показывать не буду.

Основное отличие в динамической оболочке, предназначенной для создания/изменения XML данных, заключается в наличии сеттеров у двух индексаторов: один – для изменения значения атрибутов, а второй – для добавления дополнительных под элементов. Вторым отличием является наличие двух дополнительных нединамических методов: **SetValue** и **SetAttributeValue**, которые служат для изменения значения текущего элемента и его атрибутов.

> `public class DynamicXElementWriter : DynamicObject

>

> {

>

> // Код, отвечающий за создание экземпляра аналогичен

>

>

>

> ///

>

> /// Изменение значения текущего элемента

>

> ///

>

> public void SetValue(object value)

>

> {

>

> Contract.Requires(value != null);

>

>

>

> element.SetValue(value);

>

> }

>

>

>

> ///

>

> /// Изменение атрибута текущего элемента

>

> ///

>

> public void SetAttributeValue(XName name, object value)

>

> {

>

> Contract.Requires(name != null);

>

> Contract.Requires(value != null);

>

>

>

> element.SetAttributeValue(name, value);

>

> }

>

>

>

> ///

>

> /// Идексатор для доступа к атрибутом текущего элемента

>

> ///

>

> public dynamic this[XName name]

>

> {

>

> get

>

> {

>

> // Реализация геттера абсолютно аналогична

>

> }

>

>

>

> set

>

> {

>

> // А в сеттере нам всего лишь нужно вызвать метод

>

> // XElement.SetAttributeValue, и он зделает всю работу за нас

>

> element.SetAttributeValue(name, value);

>

> }

>

>

>

> }

>

>

>

> ///

>

> /// Индексатор для доступа к "брату" текущего элемента по указанному индексу

>

> ///

>

> public dynamic this[int idx]

>

> {

>

> get

>

> {

>

> // Предусловие аналогично предыдущей реализации

>

> Contract.Requires(idx >= 0, "Index should be greater or equals to 0");

>

> Contract.Requires(idx == 0 || HasParent(),

>

> "For non-zero index we should have parent element");

>

>

>

> // Доступ по нулевому индексу означает доступ к текущему элементу

>

> if (idx == 0)

>

> return this;

>

>

>

> // Доступ по ненулевому индексу означает поиск "брата" текущего элемента.

>

> // Для этого необходимо, чтобы текущий элемент содержал родительский узел

>

> var parent = element.Parent;

>

> Contract.Assume(parent != null);

>

>

>

> // Если в данный момент нет "брата" с указанным индексом,

>

> // добавляем его руками

>

> XElement subElement = parent.Elements(element.Name).ElementAtOrDefault(idx);

>

> if (subElement == null)

>

> {

>

> XElement sibling = parent.Elements(element.Name).First();

>

> subElement = new XElement(sibling.Name);

>

> parent.Add(subElement);

>

> }

>

>

>

> return CreateInstance(subElement);

>

> }

>

>

>

> set

>

> {

>

> Contract.Requires(idx >= 0, "Index should be greater or equals to 0");

>

> Contract.Requires(idx == 0 || HasParent(),

>

> "For non-zero index we should have parent element");

>

>

>

> // Поскольку вся основная логика по добавлению нового подэлемента

>

> // уже реализована в геттере, то проще всего сеттер реализовать

>

> // через него

>

> dynamic d = this[idx];

>

> d.SetValue(value);

>

> return;

>

> }

>

>

>

> }

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`

Реализация геттеров весьма похожа на предыдущую реализацию, особенно это касается индексатора, принимающего XName и предназначенного для работы с атрибутами. Реализация индексатора, принимающего целое число несколько сложнее, поскольку даже геттер содержит дополнительную логику по созданию дополнительного «брата», если такого элемента еще нет. Реализация же сеттеров в обоих случаях достаточно тривиальна.

Еще одним существенным отличием является реализация метода **TryGetMember**, а также наличие дополнительного метода TrySetMember, который будет вызываться в случае установки значения xml элемента: **dynamicElement.SubElement = value**.

> `///

>

> /// Вызывается при доступе к члену или свойству

>

> ///

>

> public override bool TryGetMember(GetMemberBinder binder, out object result)

>

> {

>

> string binderName = binder.Name;

>

> Contract.Assume(binderName != null);

>

>

>

> // Получаем подэлемент с указанным именем

>

> XElement subelement = element.Element(binderName);

>

>

>

> // Создаем и добавляем новый элемент, если текущий элемент не содержит

>

> // под элемент с заданным именем

>

> if (subelement == null)

>

> {

>

> subelement = new XElement(binderName);

>

> element.Add(subelement);

>

> }

>

>

>

> result = CreateInstance(subelement);

>

> return true;

>

> }

>

>

>

> ///

>

> /// Вызывается при изменения значения члена или свойства

>

> ///

>

> public override bool TrySetMember(SetMemberBinder binder, object value)

>

> {

>

> Contract.Assume(binder != null);

>

> Contract.Assume(!string.IsNullOrEmpty(binder.Name));

>

> Contract.Assume(value != null);

>

>

>

> string binderName = binder.Name;

>

>

>

> // Если взываеющий код пытается установить значение свойства, соответствующего

>

> // имени текущего элемента, изменяем значение текущего элемента;

>

> // В противном случае вызываем метод XElement.SetElementValue, который

>

> // сделает всю работу за нас

>

> if (binderName == element.Name)

>

> element.SetValue(value);

>

> else

>

> element.SetElementValue(binderName, value);

>

> return true;

>

> }

>

>

>

> \* This source code was highlighted with Source Code Highlighter.`