pipeline_tag: image-to-video

inference: false

license: other

license_name: sai-nc-community

license_link: https://huggingface.co/stabilityai/sdxl-turbo/blob/main/LICENSE.md

datasets:

- neuralwork/arxiver

language:

- af

metrics:

- bleu

- code_eval

base_model:

- genmo/mochi-1-preview

new_version: genmo/mochi-1-preview

library_name: fasttext

tags:

- legal

#SDXL-Turbo型号卡

<!--提供模型功能的快速摘要。-->

SDXL-Turbo是一种快速生成的文本到图像模型,可以在单个网络评估中从文本提示合成照片级真实感图像。

实时演示可在以下位置获得:http://clipdrop.co/stable-diffusion-turbo

SDXL-Turbo是一种快速生成的文本到图像模型,可以在单个网络评估中从文本提示合成照片级真实感图像。

实时演示可在以下位置获得:http://clipdrop.co/stable-diffusion-turbo

请注意:对于商业用途,请参阅https://stability.ai/license.

##模型详细信息

###型号说明 SDXL-Turbo是SDXL1.0,受过实时合成训练。 SDXL-Turbo基于一种称为对抗扩散蒸馏(ADD)的新型训练方法(参见技术报告),这允许对基础 图像扩散模型在高图像质量的1到4步中进行。 该方法使用分数蒸馏来利用大规模现成的图像扩散模型作为教师信号,并将其与 对抗性损失,以确保即使在一个或两个采样步骤的低阶区域中也具有高图像保真度。

- 编制单位:稳定性AI

- 资金来源:稳定性AI

- 型号类型:生成文本到图像模型

- 根据模型进行微调: SDXL1.0Base

###模型源

出于研究目的,我们建议生成模型GitHub存储库(https://github.com/Stability-AI/generative-models),

它实现了最流行的传播框架(训练和推理)。

- 存储库:https://github.com/Stability-AI/generative-models

- 纸:https://stability.ai/research/adversarial-diffusion-distillation

- 演示:http://clipdrop.co/stable-diffusion-turbo

##评价

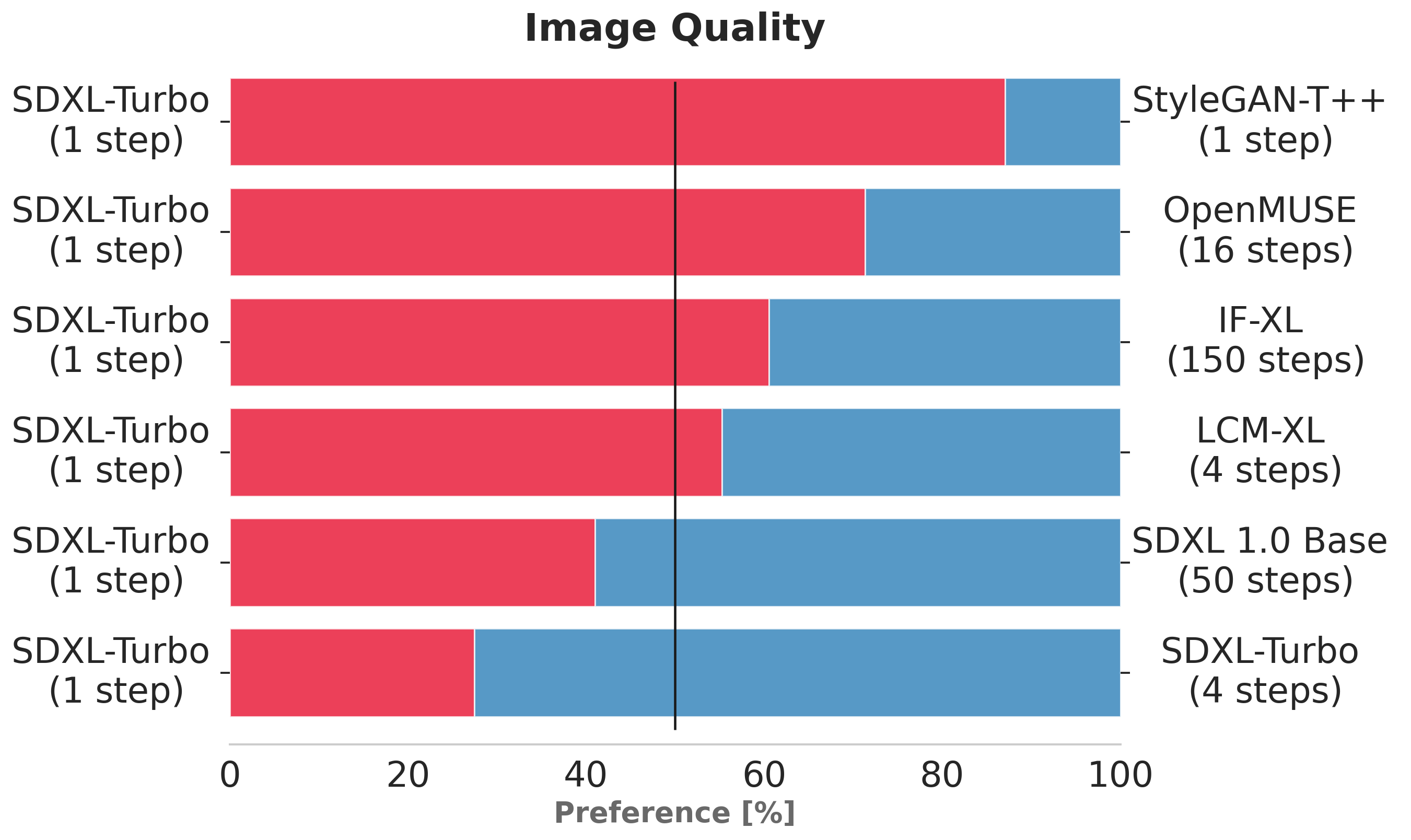

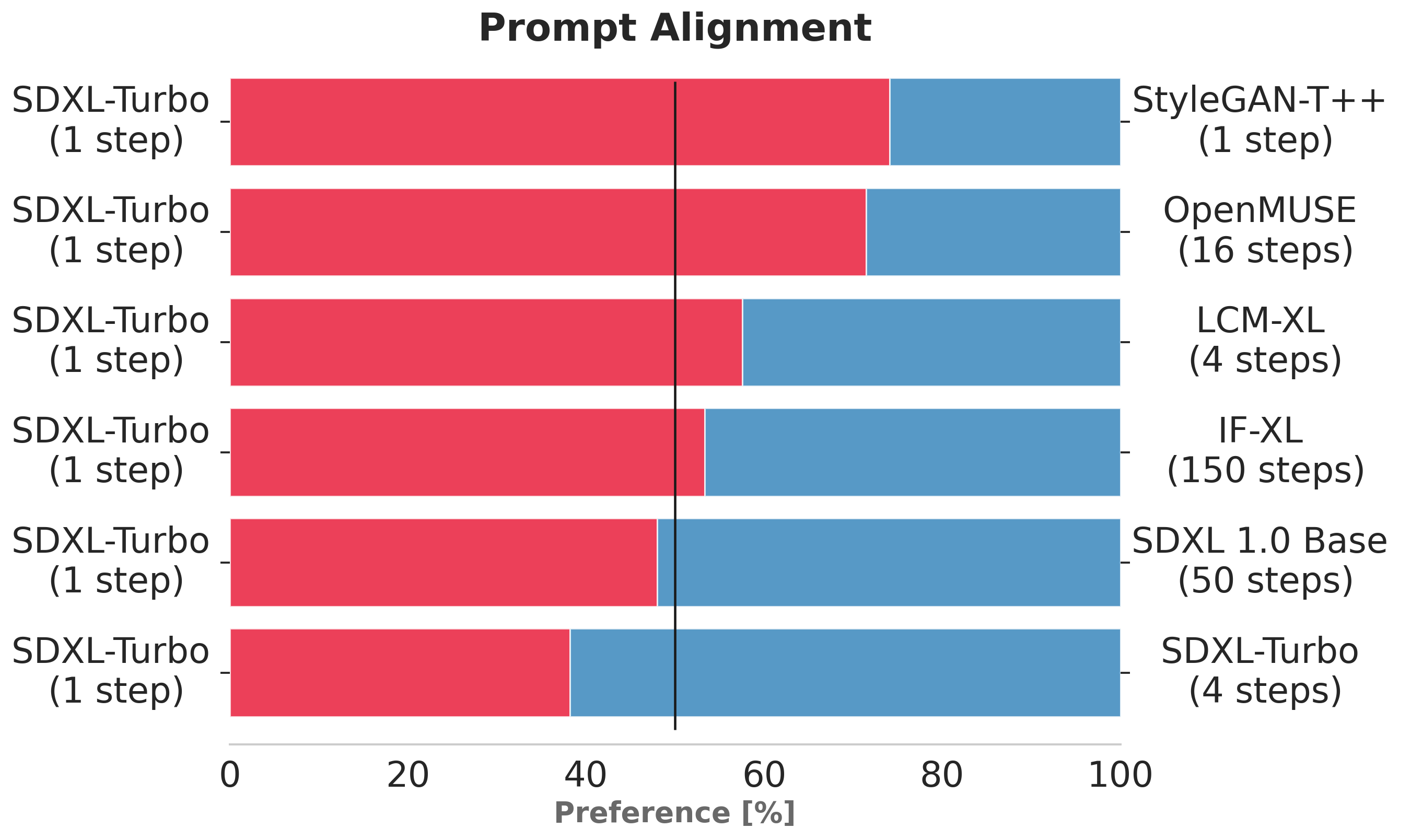

以上图表评估了SDXL-Turbo与其他单步和多步型号相比的用户偏好。

在图像质量和即时跟踪方面,在单步评估的SDXL-Turbo比在四步(或更少)评估的LCM-XL更受人类选民的青睐。

此外,我们看到SDXL-Turbo使用四个步骤进一步提高了性能。

有关用户研究的详细信息,请参阅研究论文.

以上图表评估了SDXL-Turbo与其他单步和多步型号相比的用户偏好。

在图像质量和即时跟踪方面,在单步评估的SDXL-Turbo比在四步(或更少)评估的LCM-XL更受人类选民的青睐。

此外,我们看到SDXL-Turbo使用四个步骤进一步提高了性能。

有关用户研究的详细信息,请参阅研究论文.

##uses

###直接使用

该模型既可用于非商业用途,也可用于商业用途。您可根据本协议将该模型用于非商业用途或研究用途。许可证。可能的研究领域和任务包括

-生成模型研究。 -生成模型的实时应用研究。 -研究实时生成模型的影响。 -安全部署可能产生有害内容的模型。 -探索和理解生成模型的局限性和偏差。 -艺术作品的产生和在设计和其他艺术过程中的使用。 -在教育或创意工具中的应用。

对于商业用途,请参阅https://stability.ai/membership.

排除的用途描述如下。

###扩散器

PIP安装扩散器变压器加速-升级

- 文本到图像:

SDXL-Turbo不使用制导_标度或negative_prompt,我们用来禁用它guidance_scale=0.0.

优选地,模型生成尺寸为512x512的图像,但是更大的图像尺寸也可以工作。

A单步足以生成高质量图像。

从散流器导入AutoPipelineForText2Image

进口火炬

管道=AutoPipelineForText2Image。from_pretrained("stabilityai/sdxl-turbo",torch_dtype=torch.float16,variant="fp16")

pipe.to(“cuda”)

prompt="一只小浣熊穿着复杂的意大利牧师长袍的电影镜头。"

image=管道(提示=提示,num_interference_steps=1,guidance_scale=0.0)。images[0]

- 图像到图像:

使用SDXL-Turbo进行图像到图像生成时,请确保NUM_interference_steps力量大于或等于

到1。映像到映像管道将运行int(num_interference_steps*strength)步骤,例如在我们的示例中,0.52.0=1步

在……下面。

从散流器导入AutoPipelineForImage2Image

从diffusers.utils导入load_image

进口火炬

管道=AutoPipelineForImage2Image。from_pretrained("stabilityai/sdxl-turbo",torch_dtype=torch.float16,variant="fp16")

pipe.to(“cuda”)

init_image=load_image("https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/diffusers/cat.png").resize((512,512))

prompt="猫巫师,甘道夫,指环王,详细,梦幻,可爱,可爱,皮克斯,迪斯尼,8k"

image=管道(提示,image=init_image,num_interference_steps=2,strength=0.5,guidance_scale=0.0)。images[0]

###超出范围使用

模型并没有被训练成真实或真实的人或事件的表现, 因此,使用该模型来生成这样的内容超出了该模型的能力的范围。 该模型不应以任何违反稳定性人工智能的方式使用可接受的使用政策.

##限制和偏差

###限制 -生成的图像具有固定的分辨率(512x512像素),并且模型不能实现完美的照片真实感。 -模型无法呈现清晰可见的文本。 -一般情况下,人脸和人物可能无法正确生成。 -模型的自动编码部分有损耗。

###推荐

该模型既可用于非商业用途,也可用于商业用途。

##如何开始使用模型